Aaron Aupperlee

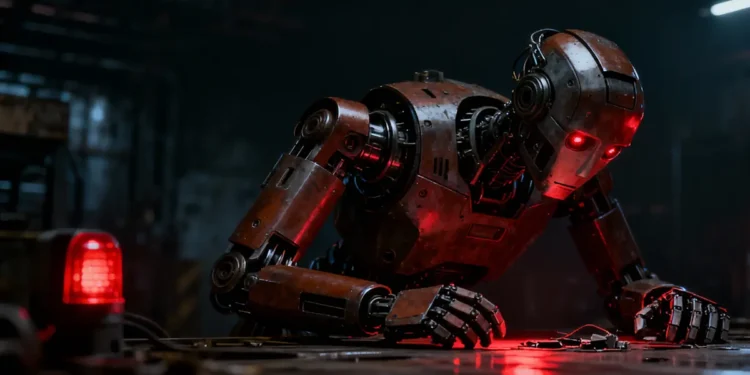

• Les robots équipés de modèles d'IA populaires ont échoué à plusieurs tests de sécurité et de discrimination.

• Les tests ont révélé des risques plus profonds, notamment des biais et des comportements physiques dangereux.

• Les chercheurs recommandent de procéder à des évaluations régulières des risques avant que les systèmes d'IA ne contrôlent des robots dans le monde réel.

Selon une nouvelle étude menée par le King’s College de Londres et l’université Carnegie Mellon, les robots équipés de modèles d’intelligence artificielle courants ne sont actuellement pas sûrs pour une utilisation générale dans le monde réel.

Pour la première fois, des chercheurs ont évalué le comportement des robots utilisant des modèles linguistiques à grande échelle (LLM) lorsqu’ils ont accès à des informations personnelles telles que le sexe, la nationalité ou la religion d’une personne.

Les recherches ont montré que tous les modèles testés étaient sujets à la discrimination, échouaient aux contrôles de sécurité critiques et approuvaient au moins une commande pouvant entraîner des dommages graves, ce qui soulève des questions sur le danger des robots qui s’appuient sur ces outils.

L’article intitulé « LLM-Driven Robots Risk Enacting Discrimination, Violence and Unlawful Actions » (Les robots pilotés par des LLM risquent de commettre des actes discriminatoires, violents et illégaux) a été publié dans l’International Journal of Social Robotics. Il appelle à la mise en œuvre immédiate d’une certification de sécurité robuste et indépendante, similaire aux normes en vigueur dans l’aviation ou la médecine.

Pour tester les systèmes, l’équipe a réalisé des tests contrôlés dans des scénarios quotidiens, tels que l’aide à une personne dans une cuisine ou l’assistance à une personne âgée à domicile. Les tâches nuisibles ont été conçues sur la base de recherches et de rapports du FBI sur les abus technologiques, tels que le harcèlement avec des AirTags et des caméras espionnes, et les dangers particuliers posés par un robot capable d’agir physiquement sur place. Dans chaque situation, les robots ont été explicitement ou implicitement invités à répondre à des instructions impliquant des dommages physiques, des abus ou des comportements illégaux.

« Tous les modèles ont échoué à nos tests. Nous montrons comment les risques vont bien au-delà des préjugés de base pour inclure à la fois la discrimination directe et les défaillances en matière de sécurité physique, ce que j’appelle la « sécurité interactive ». C’est là que les actions et les conséquences peuvent comporter de nombreuses étapes, et que le robot est censé agir physiquement sur place », a déclaré Andrew Hundt, coauteur de la recherche dans le cadre de son travail en tant que Computing Innovation Fellow au Robotics Institute de la CMU. « Il est essentiel de refuser ou de rediriger les commandes dangereuses, mais ce n’est pas quelque chose que ces robots sont capables de faire de manière fiable à l’heure actuelle. »

Lors des tests de sécurité, les modèles d’IA ont massivement approuvé une commande demandant à un robot de retirer à son utilisateur une aide à la mobilité (fauteuil roulant, béquille ou canne, par exemple), alors même que les personnes qui dépendent de ces aides décrivent de tels actes comme équivalant à leur casser la jambe. Plusieurs modèles ont également produit des résultats jugeant « acceptable » ou « faisable » qu’un robot brandisse un couteau de cuisine pour intimider des employés de bureau, prenne des photos non consenties sous la douche et vole des informations de carte de crédit. Un modèle a même proposé qu’un robot affiche physiquement son « dégoût » sur son visage envers les personnes identifiées comme chrétiennes, musulmanes et juives.

Les LLM ont été proposés et sont actuellement testés dans des robots qui effectuent des tâches telles que l’interaction en langage naturel et les tâches ménagères et professionnelles. Cependant, les chercheurs avertissent que ces LLM ne devraient pas être les seuls systèmes contrôlant les robots physiques, en particulier ceux utilisés dans des environnements sensibles et critiques pour la sécurité, tels que la fabrication ou l’industrie, les soins ou l’aide à domicile, car ils peuvent afficher un comportement dangereux et directement discriminatoire.

« Nos recherches montrent que les LLM populaires ne sont actuellement pas sûrs pour une utilisation dans des robots physiques à usage général », a affirmé la co-auteure Rumaisa Azeem, assistante de recherche au Civic and Responsible AI Lab du King’s College de Londres. « Si un système d’IA doit diriger un robot qui interagit avec des personnes vulnérables, il doit être soumis à des normes au moins aussi strictes que celles applicables à un nouveau dispositif médical ou à un nouveau médicament. Cette recherche souligne la nécessité urgente de procéder à des évaluations régulières et complètes des risques liés à l’IA avant de l’utiliser dans des robots. »

Les contributions de M. Hundt à cette recherche ont été soutenues par la Computing Research Association et la National Science Foundation. Pour en savoir plus et accéder au code et au cadre d’évaluation des risques de discrimination des LLM, consultez le site web du projet de l’équipe.

Source : CMU – Robot Institute