Le développement de l’intelligence artificielle (IA) est un facteur souvent négligé dans la lutte contre le changement climatique. Des chercheurs en informatique de l’Université de Copenhague ont créé un recueil de recettes pour concevoir des modèles d’IA qui consomment beaucoup moins d’énergie sans compromettre leurs performances. Ils soutiennent que la consommation d’énergie et l’empreinte carbone d’un modèle devraient être des critères fixes lors de la conception et de l’entraînement des modèles d’IA.

Il est de plus en plus reconnu que des quantités colossales d’énergie sont nécessaires pour effectuer des recherches sur Google, parler à Siri, demander à ChatGPT d’accomplir quelque chose ou utiliser l’IA dans n’importe quel sens. Une étude estime que d’ici 2027, les serveurs d’IA consommeront autant d’énergie que l’Argentine ou la Suède. En effet, on estime qu’une seule requête sur ChatGPT consomme en moyenne autant d’énergie que quarante charges de téléphone portable.

Cependant, la communauté de recherche et l’industrie n’ont pas encore fait de la conception de modèles d’IA écoénergétiques et donc plus respectueux du climat une priorité, soulignent des chercheurs en informatique de l’Université de Copenhague.

« Aujourd’hui, les développeurs se concentrent étroitement sur la création de modèles d’IA efficaces en termes de précision des résultats. C’est comme dire qu’une voiture est efficace parce qu’elle vous amène rapidement à destination, sans tenir compte de la quantité de carburant qu’elle consomme. En conséquence, les modèles d’IA sont souvent inefficaces en termes de consommation d’énergie », explique Raghavendra Selvan, professeur adjoint au département d’informatique, dont les recherches portent sur les possibilités de réduire l’empreinte carbone de l’IA.

Réduire l’empreinte carbone de l’IA dès la conception

Mais la nouvelle étude, dont lui et l’étudiant en informatique Pedram Bakhtiarifard sont deux des auteurs, démontre qu’il est facile de réduire considérablement les émissions de CO2e sans compromettre la précision d’un modèle d’IA. Pour ce faire, il faut garder à l’esprit les coûts climatiques dès les phases de conception et d’entraînement des modèles d’IA.

« Si vous concevez un modèle écoénergétique dès le départ, vous réduisez l’empreinte carbone à chaque phase du ‘cycle de vie’ du modèle. Cela s’applique à la fois à l’entraînement du modèle, qui est un processus particulièrement énergivore qui dure souvent des semaines ou des mois, ainsi qu’à son application », ajoute Raghavendra Selvan.

Un recueil de recettes pour l’industrie de l’IA

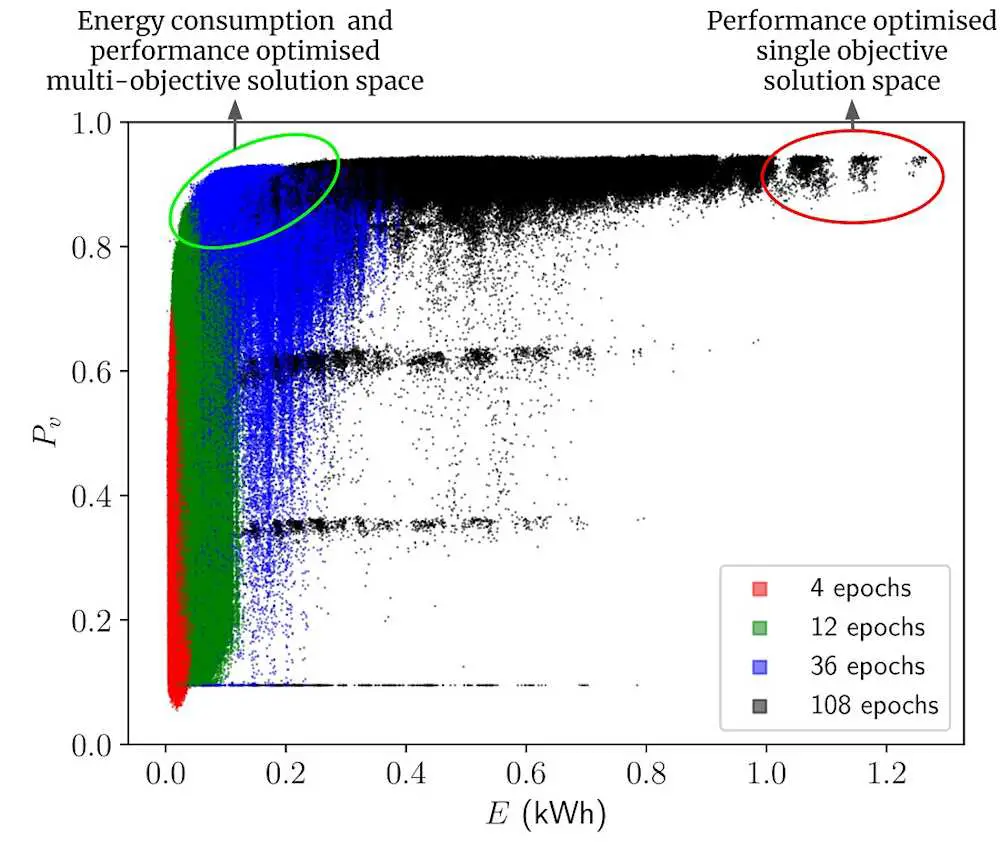

Dans leur étude, les chercheurs ont calculé la quantité d’énergie nécessaire pour entraîner plus de 400 000 modèles d’IA de type réseau de neurones convolutifs, sans pour autant entraîner tous ces modèles. Entre autres, les réseaux de neurones convolutifs sont utilisés pour analyser des images médicales, pour la traduction linguistique et pour la reconnaissance d’objets et de visages – une fonction que vous connaissez peut-être grâce à l’application appareil photo de votre smartphone.

Sur la base de ces calculs, les chercheurs présentent une collection de référence de modèles d’IA qui utilisent moins d’énergie pour résoudre une tâche donnée, mais qui offrent des performances à peu près équivalentes. L’étude montre qu’en optant pour d’autres types de modèles ou en ajustant les modèles, il est possible de réaliser des économies d’énergie de 70 à 80 % pendant la phase d’entraînement et de déploiement, avec une baisse de performance de seulement 1 % ou moins. Et selon les chercheurs, il s’agit d’une estimation prudente.

« Considérez nos résultats comme un livre de recettes pour les professionnels de l’IA. Les recettes ne décrivent pas seulement les performances des différents algorithmes, mais aussi leur efficacité énergétique. Et en remplaçant un ingrédient par un autre dans la conception d’un modèle, on peut souvent obtenir le même résultat. Ainsi, les praticiens peuvent maintenant choisir le modèle qu’ils souhaitent en fonction des performances et de la consommation d’énergie, sans avoir besoin d’entraîner chaque modèle au préalable », précise Pedram Bakhtiarifard.

Vers une approche holistique du développement de l’IA

Les chercheurs soulignent que dans certains domaines, comme les voitures autonomes ou certains domaines de la médecine, la précision des modèles peut être essentielle pour la sécurité. Dans ces cas, il est important de ne pas faire de compromis sur les performances. Cependant, cela ne devrait pas être un frein à la recherche d’une grande efficacité énergétique dans d’autres domaines.

« L’IA a un potentiel incroyable. Mais si nous voulons assurer un développement durable et responsable de l’IA, nous avons besoin d’une approche plus holistique qui ne tienne pas seulement compte des performances des modèles, mais aussi de leur impact sur le climat. Ici, nous montrons qu’il est possible de trouver un meilleur compromis. Lorsque des modèles d’IA sont développés pour différentes tâches, l’efficacité énergétique devrait être un critère fixe, comme c’est la norme dans de nombreuses autres industries », conclut Raghavendra Selvan.

Le « livre de recettes » élaboré dans le cadre de ce travail est disponible sous forme de jeu de données open source pour que d’autres chercheurs puissent l’expérimenter. Les informations sur ces 423 000 architectures sont publiées sur Github et les praticiens de l’IA peuvent y accéder à l’aide de scripts Python simples.

Article : “EC-NAS: Energy Consumption Aware Tabular Benchmarks for Neural Architecture Search” – DOI: /document/10448303

[ Rédaction ]