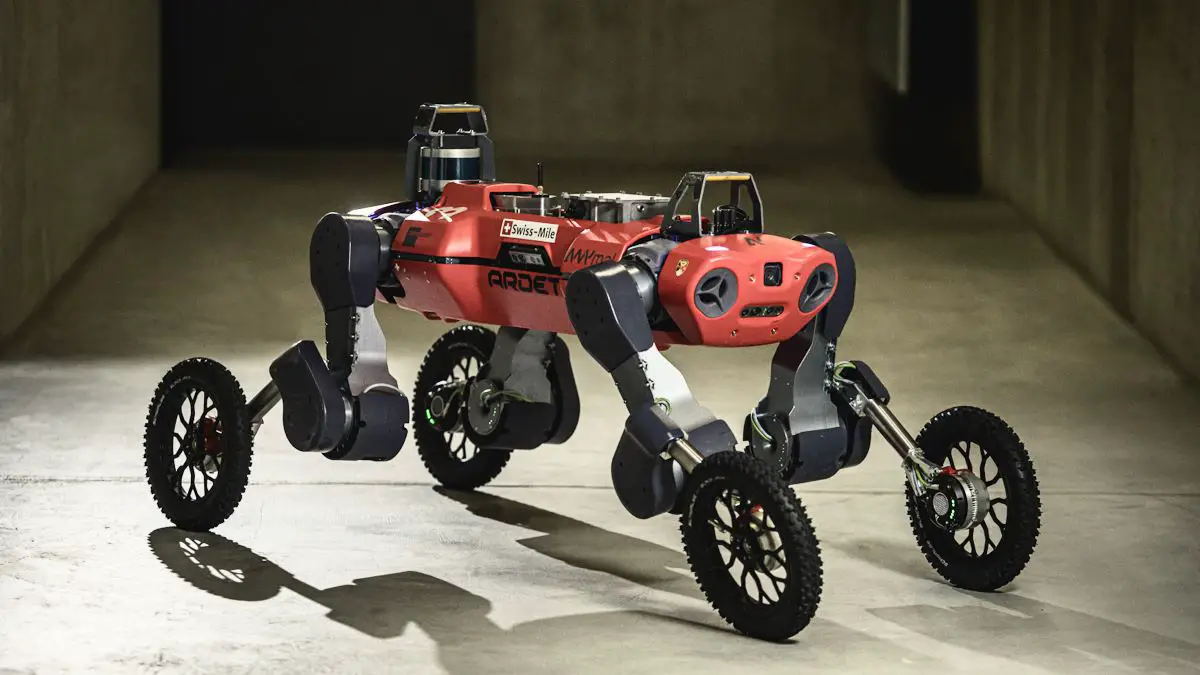

L’ANYmal quadrupède, développé par Swiss-Mile une société basée à Zurich, ne cesse de s’améliorer. Ce robot, initialement conçu pour la marche, a vu ses capacités décuplées grâce à l’ajout de roues motorisées. Il est désormais capable de manipuler des objets avec ses membres, qui font office à la fois de jambes et de bras.

Les chercheurs de l’ETH Zurich ont réussi à enseigner à ce robot des tâches complexes grâce à un apprentissage renforcé par la curiosité.

L’évolution de l’ANYmal

Initialement, l’ANYmal était juste un quadrupède. L’ajout de roues motorisées a non seulement rendu le robot plus rapide et efficace, mais lui a également permis de franchir des obstacles comme des trottoirs et des escaliers. Le robot a ensuite appris à se tenir debout, rendant sa gestuelle plus agréable ainsi que l’utilisation de ses deux membres avant afin d’être en mesure de saisir des objets.

La manipulation entière de l’ANYmal s’avère somme toute complexe, car ses membres au départ ont été conçus pour être des jambes et non des bras. Le laboratoire des systèmes robotiques de l’ETH Zurich a toutefois réussi à lui enseigner comment ouvrir des portes et même saisir un colis sur une table pour ensuite le jeter dans une boîte.

L’apprentissage renforcé par la curiosité

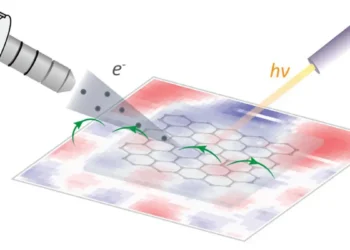

Les chercheurs de l’ETHZ ont réussi à faire exécuter de manière fiable ces comportements complexes au robot grâce à une forme d’apprentissage par renforcement appelée « apprentissage guidé par la curiosité ».

En simulation, le robot se voit attribuer un objectif à atteindre – dans ce cas, le robot est récompensé pour avoir réussi à passer par une porte ou à mettre un colis dans une boîte. Ce sont des objectifs de très haut niveau (également appelés « récompenses rares »), et le robot ne reçoit aucun encouragement en cours de route. Il doit donc comprendre comment accomplir la tâche entière à partir de zéro.

Pour donner au robot un point de départ utile, les chercheurs ont introduit le concept de curiosité, qui encourage le robot à jouer avec des objets liés à l’objectif.

Les comportements du robot

Les comportements que le robot développe grâce à ce processus sont fiables et diversifiés, ce qui est l’un des avantages de l’utilisation de récompenses rares.

Par exemple, avec la tâche d’ouverture de porte, le robot a découvert comment l’ouvrir avec l’un de ses effecteurs finaux, ou les deux en même temps, ce qui le rend plus efficace pour accomplir la tâche dans le monde réel.

La manipulation du colis est encore plus intéressante, car le robot a parfois laissé tomber le colis pendant l’entraînement, mais il a appris de manière autonome comment le ramasser à nouveau. Ainsi, lorsqu’il commet une erreur dans le monde réel, le robot a déjà acquis les compétences nécessaires pour se rétablir.

Un design hybride

Au fil du temps, l’intégration de roues motorisées a considérablement amélioré la vitesse et l’efficacité du robot, lui permettant de naviguer d’une façon optimale sur les trottoirs et les escaliers. Une évolution majeure s’est produite lorsque le robot a acquis la capacité de se tenir debout, améliorant sa mobilité et le rendant plus attrayant.

Le robot de Swiss Mile est basé sur le design du quadrupède ANYmal de l’ETH Zurich (ETHZ), doté d’une vitesse maximale de 22 km/h et d’une capacité de charge allant jusqu’à 50 kg. Son design hybride intègre un GPS, un LiDAR et des caméras pour une navigation indépendante dans les rues. L’autonomie de fonctionnement est environ de 2 heures.

En synthèse

L’ANYmal quadrupède, grâce à l’ajout de roues motorisées et à un apprentissage renforcé par la curiosité, a réussi à développer des comportements complexes et fiables. Il est capable d’ouvrir des portes, de saisir des colis et de les jeter dans une boîte. Les chercheurs de l’ETH Zurich continuent de travailler sur ce robot pour améliorer encore ses capacités et le rendre encore plus utile dans le monde réel.

Pour une meilleure compréhension

Qu’est-ce que l’ANYmal ?

L’ANYmal est un robot quadrupède initialement conçu pour la marche. Il a été amélioré par l’ajout de roues motorisées et est maintenant capable de manipuler des objets avec ses membres.

Qu’est-ce que l’apprentissage renforcé par la curiosité ?

C’est une forme d’apprentissage par renforcement où le robot est encouragé à jouer avec des objets liés à l’objectif. Cela permet au robot de découvrir des solutions pour des tâches sans avoir besoin d’ingénieurs pour spécifier explicitement quoi faire.

Quels sont les comportements que le robot a développés ?

Le robot a appris à ouvrir des portes, à saisir des colis et à les jeter dans une boîte. Il a également appris à se rétablir lorsqu’il commet une erreur, comme laisser tomber un colis.

Quels sont les avantages de l’utilisation de récompenses rares ?

Les récompenses rares permettent au robot de développer des comportements fiables et diversifiés. Elles rendent le processus d’apprentissage sensible à de petits changements dans l’environnement d’entraînement, ce qui permet au robot d’explorer diverses solutions et trajectoires.

Quelle est la prochaine étape pour l’ANYmal ?

Les chercheurs de l’ETH Zurich continuent de travailler sur ce robot pour améliorer encore ses capacités et le rendre encore plus utile dans le monde réel.

Références

Source : swiss-mile / Robotic Systems Lab: Legged Robotics at ETH Zürich