Patricia DeLacey

Une approche d’apprentissage automatique surpasse la norme industrielle pour ajuster la production d’énergie à la demande, particulièrement dans des conditions imparfaites.

Une approche d’apprentissage automatique exploite la symétrie des micro-réacteurs nucléaires pour réduire le temps d’entraînement lors de la modélisation des ajustements de puissance, selon une étude récente dirigée par des chercheurs de l’Université du Michigan.

L’amélioration de l’efficacité de l’entraînement aidera les chercheurs à modéliser plus rapidement les réacteurs, faisant un pas vers le contrôle automatisé en temps réel des micro-réacteurs nucléaires pour une exploitation dans des zones reculées ou éventuellement dans l’espace.

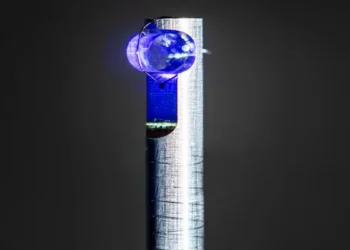

Ces réacteurs compacts – capables de générer jusqu’à 20 mégawatts d’énergie thermique utilisable directement comme chaleur ou convertie en électricité – pourraient être facilement transportés ou potentiellement utilisés dans des cargos effectuant de très longs trajets sans ravitaillement. Intégrés à un réseau électrique, les micro-réacteurs nucléaires pourraient fournir une énergie stable et sans carbone lorsque les énergies renouvelables comme le solaire ou l’éolien ne sont pas suffisamment disponibles.

Les petits réacteurs évitent les énormes coûts d’investissement des grands réacteurs, et l’automatisation partielle du contrôle de la puissance des micro-réacteurs contribuerait à maintenir les coûts bas. Dans des applications spatiales potentielles – comme la propulsion directe d’un vaisseau spatial ou l’alimentation électrique de ses systèmes – les micro-réacteurs nucléaires devraient fonctionner de manière entièrement autonome.

Comme première étape vers l’automatisation, les chercheurs simulent le suivi de charge – lorsque les centrales augmentent ou diminuent leur production pour correspondre à la demande électrique du réseau. Ce processus est relativement simple à modéliser comparé au démarrage du réacteur, qui implique des conditions rapidement changeantes plus difficiles à prédire.

La conception du micro-réacteur Holos-Quad modélisée dans cette étude ajuste la puissance via la position de huit tambours de contrôle entourant le cœur central du réacteur où les neutrons fissionnent les atomes d’uranium pour produire de l’énergie. Un côté de la circonférence des tambours de contrôle est revêtu d’un matériau absorbant les neutrons, le carbure de bore. Lorsqu’ils sont tournés vers l’intérieur, les tambours absorbent les neutrons du cœur, réduisant la population neutronique et la puissance. Les faire tourner vers l’extérieur maintient davantage de neutrons dans le cœur, augmentant la puissance de sortie.

« L’apprentissage par renforcement profond construit un modèle de la dynamique du système, permettant un contrôle en temps réel – ce que les méthodes traditionnelles comme le contrôle prédictif ont souvent du mal à réaliser en raison des besoins répétitifs d’optimisation », a déclaré Majdi Radaideh, professeur assistant de génie nucléaire et sciences radiologiques à l’UM et auteur principal de l’étude.

L’équipe de recherche a simulé le suivi de charge par rotation des tambours de contrôle basée sur la rétroaction du réacteur avec l’apprentissage par renforcement – un paradigme d’apprentissage automatique permettant aux agents de prendre des décisions par interactions répétées avec leur environnement par essais et erreurs. Bien que très efficace, l’apprentissage par renforcement profond nécessite un entraînement extensif qui augmente le temps et le coût computationnels.

Pour la première fois, les chercheurs ont testé une approche d’apprentissage par renforcement multi-agents qui entraîne huit agents indépendants à contrôler un tambour spécifique tout en partageant des informations sur le cœur dans son ensemble. Ce cadre exploite la symétrie du micro-réacteur pour aider à réduire le temps d’entraînement en multipliant l’expérience d’apprentissage.

L’étude a comparé l’apprentissage par renforcement multi-agents à deux autres modèles : une approche mono-agent, où un seul agent observe l’état du cœur et contrôle les huit tambours, et la norme industrielle de contrôle proportionnel-intégral-dérivé (PID), qui utilise une boucle de contrôle basée sur la rétroaction.

Les approches d’apprentissage par renforcement ont atteint un suivi de charge similaire ou supérieur au PID. Dans des scénarios imparfaits où les capteurs fournissaient des lectures inexactes ou lorsque les conditions du réacteur fluctuait, l’apprentissage par renforcement maintenait des taux d’erreur inférieurs au PID avec des coûts de contrôle jusqu’à 150% inférieurs – signifiant qu’il atteignait la solution avec moins d’effort.

L’approche multi-agents s’est entraînée au moins deux fois plus vite que l’approche mono-agent avec seulement un taux d’erreur légèrement plus élevé.

La technique nécessite une validation extensive dans des conditions plus complexes et réalistes avant une application réelle, mais ces résultats établissent une voie plus efficace pour l’apprentissage par renforcement dans les micro-réacteurs nucléaires autonomes.

« Cette étude est un pas vers un jumeau numérique prospectif où l’apprentissage par renforcement pilote les actions du système. Ensuite, nous visons à fermer la boucle avec une calibration inverse et des simulations haute fidélité pour améliorer la précision du contrôle », a conclu Majdi Radaideh.

Article : « Nuclear microreactor transient and load-following control with deep reinforcement learning », Leo Tunkle, Kamal Abdulraheem, Linyu Lin, Majdi I. Radaideh, Energy Conversion and Management: X (2025). DOI : 10.1016/j.ecmx.2025.101090