Ayse Coskun, Boston University

Le boom de l’intelligence artificielle a eu un tel effet sur les grandes entreprises technologiques que leur consommation d’énergie, et donc leurs émissions de carbone, ont explosé.

Le succès spectaculaire des grands modèles de langage tels que ChatGPT a contribué à alimenter cette croissance de la demande d’énergie. À raison de 2,9 wattheures par requête ChatGPT, les requêtes d’IA nécessitent environ 10 fois plus d’électricité que les requêtes traditionnelles sur Google, selon l’Electric Power Research Institute, une société de recherche à but non lucratif. Les capacités émergentes de l’IA, telles que la génération d’audio et de vidéo, sont susceptibles d’accroître cette demande d’énergie.

Les besoins énergétiques de l’IA modifient les calculs des entreprises du secteur de l’énergie. Celles-ci explorent désormais des options auparavant intenables, comme le redémarrage d’un réacteur nucléaire à la centrale de Three Mile Island, site de la tristement célèbre catastrophe de 1979, qui est en sommeil depuis 2019.

Les centres de données ont connu une croissance continue pendant des décennies, mais l’ampleur de la croissance dans l’ère encore jeune des grands modèles de langage a été exceptionnelle. L’IA nécessite beaucoup plus de ressources de calcul et de stockage de données que ne le permettait le taux de croissance des centres de données avant l’IA.

L’IA et le réseau

Grâce à l’IA, le réseau électrique, qui est déjà proche de sa capacité maximale ou sujet à des problèmes de stabilité dans de nombreux endroits, subit une pression plus forte qu’auparavant. Il existe également un décalage important entre la croissance informatique et la croissance du réseau. La construction d’un centre de données prend un à deux ans, tandis que l’ajout d’une nouvelle source d’énergie au réseau nécessite plus de quatre ans.

Comme le souligne un rapport récent de l’Electric Power Research Institute, 15 États seulement concentrent 80 % des centres de données aux États-Unis. Certains États, comme la Virginie, qui abrite le Data Center Alley, consacrent étonnamment plus de 25 % de leur électricité à l’alimentation des centres de données. On observe des tendances similaires de croissance des centres de données regroupés dans d’autres parties du monde. L’Irlande, par exemple, est devenue une nation de centres de données.

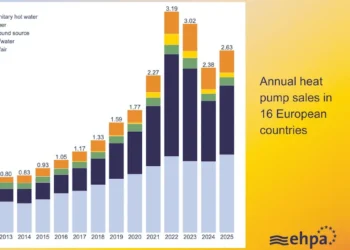

Outre la nécessité d’augmenter la production d’électricité pour soutenir cette croissance, presque tous les pays ont des objectifs de décarbonisation. Cela signifie qu’ils s’efforcent d’intégrer davantage de sources d’énergie renouvelables dans le réseau. Les énergies renouvelables telles que l’éolien et le solaire sont intermittentes : le vent ne souffle pas toujours et le soleil ne brille pas toujours. La pénurie de moyens de stockage d’énergie bon marché, écologiques et évolutifs signifie que le réseau est confronté à un problème encore plus important pour faire correspondre l’offre à la demande.

Parmi les autres défis liés à la croissance des centres de données, citons l’utilisation croissante du refroidissement par eau pour améliorer l’efficacité, ce qui met à rude épreuve les ressources limitées en eau douce. En conséquence, certaines communautés s’opposent aux nouveaux investissements dans les centres de données.

Une meilleure technologie

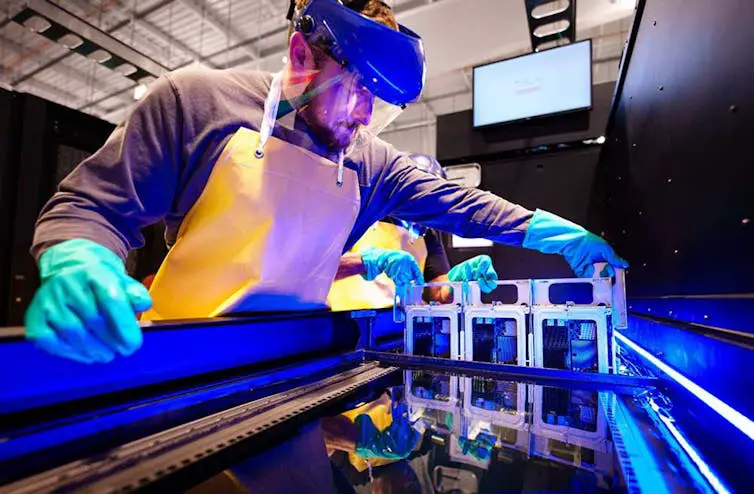

L’industrie s’attaque à cette crise énergétique de plusieurs manières. Tout d’abord, le matériel informatique est devenu beaucoup plus économe en énergie au fil des ans en termes d’opérations exécutées par watt consommé. L’efficacité énergétique des centres de données, un indicateur qui montre le rapport entre l’énergie consommée pour le calcul et celle consommée pour le refroidissement et d’autres infrastructures, a été réduite à 1,5 en moyenne, et même à un impressionnant 1,2 dans les installations de pointe. Les nouveaux centres de données sont équipés de systèmes de refroidissement plus efficaces, utilisant de l’eau et de l’air frais extérieur lorsqu’il est disponible.

Malheureusement, l’efficacité seule ne suffira pas à résoudre le problème de la durabilité. En effet, le paradoxe de Jevons montre comment l’efficacité peut entraîner une augmentation de la consommation d’énergie à long terme. De plus, les gains d’efficacité du matériel informatique ont considérablement ralenti, l’industrie ayant atteint les limites de la miniaturisation des puces.

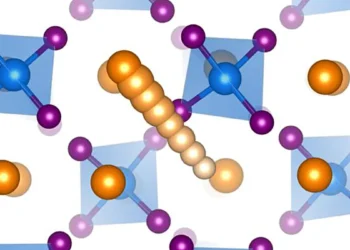

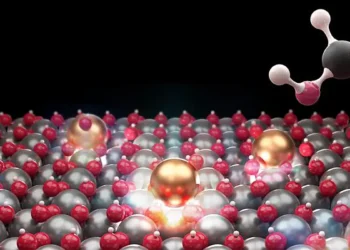

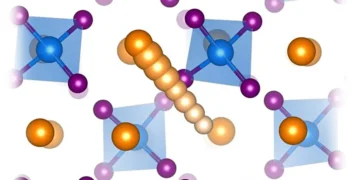

Afin de continuer à améliorer l’efficacité, les chercheurs conçoivent du matériel spécialisé, tel que des accélérateurs, de nouvelles technologies d’intégration, telles que les puces 3D, et de nouvelles techniques de refroidissement des puces.

De même, les chercheurs étudient et développent de plus en plus les technologies de refroidissement des centres de données. Le rapport de l’Electric Power Research Institute approuve les nouvelles méthodes de refroidissement, telles que le refroidissement liquide assisté par air et le refroidissement par immersion. Si le refroidissement liquide a déjà fait son apparition dans les centres de données, seuls quelques nouveaux centres ont mis en œuvre le refroidissement par immersion, qui est encore en cours de développement.

Un avenir flexible

Une nouvelle façon de construire des centres de données IA est l’informatique flexible, dont l’idée principale est de calculer davantage lorsque l’électricité est moins chère, plus disponible et plus verte, et moins lorsqu’elle est plus chère, rare et polluante.

Les opérateurs de centres de données peuvent convertir leurs installations pour qu’elles constituent une charge flexible sur le réseau. Le monde universitaire et l’industrie ont fourni les premiers exemples de réponse à la demande des centres de données, où ceux-ci régulent leur consommation d’électricité en fonction des besoins du réseau électrique. Ils peuvent par exemple programmer certaines tâches informatiques pendant les heures creuses.

La mise en œuvre d’une flexibilité plus large et à plus grande échelle en matière de consommation d’énergie nécessite des innovations en matière de matériel, de logiciels et de coordination entre le réseau et les centres de données. En particulier pour l’IA, il existe une grande marge de manœuvre pour développer de nouvelles stratégies visant à ajuster les charges informatiques des centres de données et, par conséquent, leur consommation d’énergie. Les centres de données peuvent par exemple réduire la précision afin de diminuer la charge de travail lors de l’entraînement des modèles d’IA.

La concrétisation de cette vision nécessite une meilleure modélisation et de meilleures prévisions. Les centres de données peuvent essayer de mieux comprendre et prévoir leurs charges et leurs conditions. Il est également important de prévoir la charge et la croissance du réseau.

L’initiative de prévision de la charge de l’Electric Power Research Institute comprend des activités visant à faciliter la planification et l’exploitation du réseau. Une surveillance complète et des analyses intelligentes, éventuellement basées sur l’IA, tant pour les centres de données que pour le réseau, sont essentielles pour établir des prévisions précises.

À la périphérie

Les États-Unis se trouvent à un tournant critique avec la croissance explosive de l’IA. Il est extrêmement difficile d’intégrer des centaines de mégawatts de demande d’électricité dans des réseaux déjà saturés. Il est peut-être temps de repenser la manière dont l’industrie construit ses centres de données.

Une possibilité consiste à construire de manière durable davantage de centres de données périphériques – des installations plus petites et largement réparties – afin d’apporter des capacités de calcul aux communautés locales. Les centres de données périphériques peuvent également ajouter de manière fiable de la puissance de calcul aux régions urbaines densément peuplées sans solliciter davantage le réseau électrique. Si ces centres plus petits représentent actuellement 10 % des centres de données aux États-Unis, les analystes prévoient que le marché des centres de données périphériques à plus petite échelle connaîtra une croissance de plus de 20 % au cours des cinq prochaines années.

Outre la conversion des centres de données en charges flexibles et contrôlables, l’innovation dans le domaine des centres de données périphériques pourrait rendre les besoins énergétiques de l’IA beaucoup plus durables.

This article has been updated to correct an editing error about the date Three Mile Island’s Unit 1 nuclear reactor was shut down.

Ayse Coskun, Professor of Electrical and Computer Engineering, Boston University

Cet article est republié à partir de The Conversation sous une licence Creative Commons. Lire l’article original.