Début novembre, des chercheurs du laboratoire national Argonne du ministère de l’énergie ont utilisé le superordinateur le plus rapide de la planète pour effectuer la plus grande simulation astrophysique de l’univers jamais réalisée.

Cette prouesse a été réalisée à l’aide du superordinateur Frontier du laboratoire national d’Oak Ridge. Les calculs établissent une nouvelle référence pour les simulations d’hydrodynamique cosmologique et fournissent une nouvelle base pour la simulation simultanée de la physique de la matière atomique et de la matière noire. La taille de la simulation correspond aux relevés effectués par les observatoires à grand télescope, un exploit qui n’avait pas été possible jusqu’à présent à cette échelle.

« Il y a deux composantes dans l’univers : la matière noire – qui, pour autant que nous le sachions, n’interagit que par la gravitation – et la matière conventionnelle, ou matière atomique », a indiqué Salman Habib, directeur de la division des sciences informatiques à Argonne, qui dirige le projet.

« Si nous voulons savoir ce que fait l’univers, nous devons donc simuler ces deux éléments : la gravité et tous les autres phénomènes physiques, y compris le gaz chaud et la formation des étoiles, des trous noirs et des galaxies », a-t-il ajouté. « L’évier de la cuisine astrophysique, en quelque sorte. Ces simulations sont ce que nous appelons des simulations d’hydrodynamique cosmologique ».

Il n’est pas surprenant que les simulations d’hydrodynamique cosmologique soient beaucoup plus coûteuses en termes de calcul et beaucoup plus difficiles à réaliser que les simulations d’un univers en expansion qui n’impliquent que les effets de la gravité.

« Par exemple, si nous devions simuler une grande partie de l’univers observé par l’un des grands télescopes tels que l’observatoire Rubin au Chili, il s’agirait d’examiner d’énormes périodes de temps – des milliards d’années d’expansion », a déclaré M. Habib. « Jusqu’à récemment, nous ne pouvions même pas imaginer réaliser une simulation de cette ampleur, sauf dans l’approximation de la gravité uniquement ».

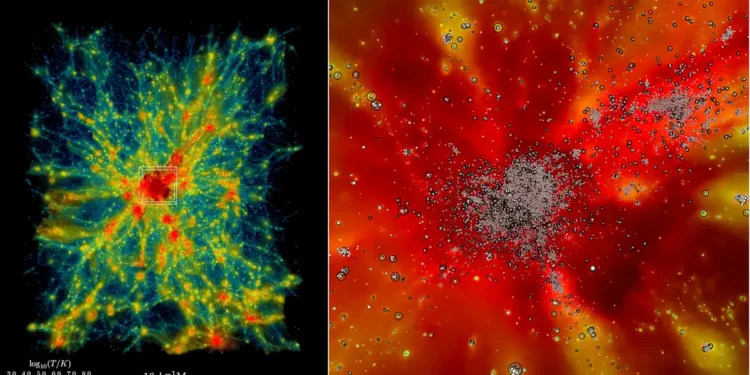

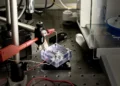

Un petit échantillon des simulations de Frontier révèle l’évolution de l’univers en expansion dans une région contenant un amas massif de galaxies, depuis des milliards d’années jusqu’à aujourd’hui (à gauche). Les zones rouges montrent des gaz plus chauds, avec des températures atteignant 100 millions de kelvins ou plus. En zoomant (à droite), les particules traceuses d’étoiles permettent de suivre la formation des galaxies et leur mouvement au fil du temps. Crédit : Laboratoire national d’Argonne, ministère américain de l’énergie

Le code du superordinateur utilisé pour la simulation s’appelle HACC, abréviation de Hardware/Hybrid Accelerated Cosmology Code (code cosmologique accéléré matériel/hybride). Il a été développé il y a une quinzaine d’années pour les machines pétascales. En 2012 et 2013, HACC a été finaliste du prix Gordon Bell de l’Association for Computing Machinery.

Plus tard, le HACC a été considérablement amélioré dans le cadre d’ExaSky, un projet spécial dirigé par Habib dans le cadre de l’Exascale Computing Project (ECP), une initiative du ministère de l’énergie d’un montant de 1,8 milliard de dollars qui s’est déroulée de 2016 à 2024. Le projet a rassemblé des milliers d’experts pour développer des applications scientifiques avancées et des outils logiciels pour la prochaine vague de superordinateurs de classe exascale capables d’effectuer plus d’un quintillion, ou d’un milliard de milliards, de calculs par seconde.

Dans le cadre d’ExaSky, l’équipe de recherche du HACC a passé les sept dernières années à ajouter de nouvelles capacités au code et à le réoptimiser pour qu’il puisse fonctionner sur des machines exascales dotées d’accélérateurs GPU. L’une des exigences du PEC était que les codes fonctionnent environ 50 fois plus vite que sur Titan, le supercalculateur le plus rapide au moment du lancement du PEC. Exécuté sur le supercalculateur Frontier de classe exascale, le HACC a été près de 300 fois plus rapide que l’exécution de référence.

Les nouvelles simulations ont atteint leur performance record en utilisant environ 9 000 nœuds de calcul de Frontier, alimentés par des GPU AMD Instinct™ MI250X. Frontier est situé à l’Oak Ridge Leadership Computing Facility (OLCF) de l’ORNL.

« Ce n’est pas seulement la taille du domaine physique, qui est nécessaire pour faire une comparaison directe avec les observations d’études modernes permises par le calcul exascale », a déclaré Bronson Messer, directeur scientifique de l’OLCF. « C’est aussi le réalisme physique supplémentaire de l’inclusion des baryons et de toute la physique dynamique qui fait de cette simulation un véritable tour de force pour Frontier ».

Légende illustration : Un petit échantillon des simulations Frontier révèle l’évolution de l’univers en expansion dans une région contenant un amas massif de galaxies, depuis des milliards d’années jusqu’à aujourd’hui (à gauche). Les zones rouges montrent des gaz plus chauds, avec des températures atteignant 100 millions de kelvins ou plus. En zoomant (à droite), des particules traceuses d’étoiles suivent la formation des galaxies et leur mouvement au fil du temps. Credit: Argonne National Laboratory, U.S Dept of Energy

Source : Oak Ridge – Traduction Enerzine.com