ChatGPT et d’autres grands modèles de langage apprennent à imiter les humains en analysant d’énormes quantités de données. Derrière la boîte de texte d’un chatbot se trouve un vaste réseau d’unités de traitement informatique qui prennent en charge la formation et l’exécution de ces modèles.

Quelle est la consommation d’énergie des réseaux utilisant de grands modèles de langage ? Beaucoup, selon Sajjad Moazeni, professeur adjoint d’ingénierie électrique et informatique à l’Université de Washington, qui étudie les réseaux pour l’IA et les supercalculateurs d’apprentissage automatique. La simple formation d’un chatbot peut consommer autant d’électricité qu’un quartier en un an.

Comment les grands modèles de langage, tels que ChatGPT, se comparent-ils à l’informatique en nuage sur le plan énergétique ?

Sajjad Moazeni : Ces modèles sont devenus si importants qu’il faut des milliers de processeurs pour former les modèles et répondre aux milliards de requêtes quotidiennes des utilisateurs. Tous ces calculs ne peuvent être effectués que dans un centre de données.

En comparaison, les charges de travail classiques de l’informatique en nuage, telles que les services en ligne, les bases de données et le streaming vidéo, sont beaucoup moins intensives en termes de calcul et nécessitent des ordres de grandeur moins importants en termes d’utilisation de la mémoire.

Pouvez-vous décrire ces centres de données ?

SM : Dans les centres de données actuels, il y a des centaines de milliers d’unités de traitement qui peuvent communiquer entre elles grâce à un grand nombre de fibres optiques et de commutateurs de réseau. Ces processeurs (en plus de la mémoire et des dispositifs de stockage) sont stockés dans des baies de serveurs. Il existe également une infrastructure interne pour refroidir les serveurs (avec de l’eau et de l’air) et des unités pour générer et distribuer l’énergie.

Il existe des centaines de centres de données de ce type dans le monde et ils sont principalement gérés par de grandes entreprises technologiques telles qu’Amazon, Microsoft et Google.

Quelle quantité d’énergie ces grands centres de données consomment-ils pour faire fonctionner ces grands modèles de langage ?

SM : Pour la formation d’un grand modèle linguistique, chaque unité de traitement peut consommer plus de 400 watts d’énergie en fonctionnement. En général, il faut également consommer une quantité d’énergie similaire pour le refroidissement et la gestion de l’énergie. Dans l’ensemble, la consommation d’énergie peut atteindre 10 gigawattheures (GWh) pour la formation d’un seul grand modèle linguistique tel que ChatGPT-3.

Aujourd’hui, il y a des centaines de millions de requêtes quotidiennes sur ChatGPT, bien que ce nombre soit en baisse. Ce nombre de requêtes peut coûter environ 1 GWh par jour, ce qui équivaut à la consommation quotidienne d’énergie d’environ 1 000 ménages américains.

Si ces chiffres peuvent sembler corrects pour l’instant, ce n’est que le début d’un développement et d’une adoption à grande échelle de ces modèles. Nous nous attendons à ce que, bientôt, de nombreux services différents utilisent cette technologie quotidiennement.

En outre, à mesure que les modèles deviennent plus sophistiqués, ils deviennent de plus en plus grands, ce qui signifie que l’énergie des centres de données pour la formation et l’utilisation de ces modèles peut devenir insoutenable. Chaque grande entreprise technologique essaie maintenant de développer son propre modèle, ce qui peut entraîner une charge de formation énorme pour les centres de données.

Quelles sont les solutions potentielles à ce problème ?

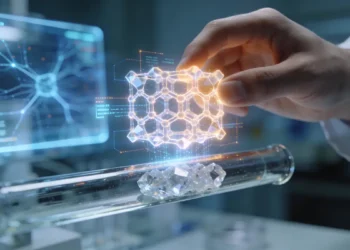

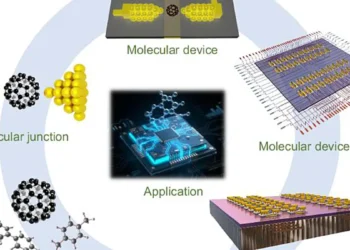

SM : Les chercheurs ont essayé d’optimiser le matériel et les processeurs des centres de données afin de les rendre plus efficaces sur le plan énergétique pour ces types de calculs.

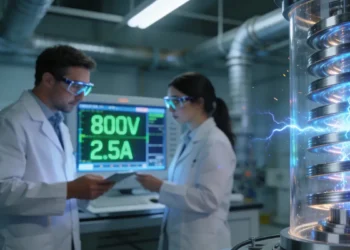

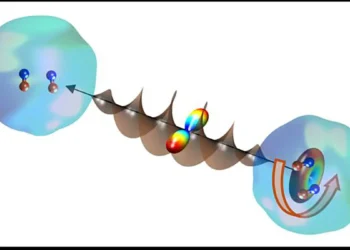

Mon groupe se concentre plus particulièrement sur l’aspect réseau. Dans les centres de données actuels, les processeurs envoient des signaux électriques pour faire entrer ou sortir les données à calculer. Mais ces signaux électriques peuvent être déformés. Afin d’envoyer rapidement un grand nombre de données, nous devons utiliser beaucoup d’énergie pour nous assurer que les signaux sont reçus correctement.

Nous construisons la prochaine génération de solutions d’interconnexion optique, qui comprend la conversion de ces signaux électriques en signaux optiques. Ces signaux optiques ont une perte beaucoup plus faible, ce qui minimise la consommation d’énergie.

Étant donné que nous n’en sommes qu’aux premières phases de cette nouvelle technologie, il est très important que les gens soient transparents quant à leurs résultats et créent des modèles à source ouverte. Cela nous aidera également à trouver des solutions avancées et durables.