Les chercheurs du MIT et de l’Université Stanford proposent une approche innovante d’apprentissage automatique qui pourrait permettre une meilleure gestion de robots tels que des drones ou des véhicules autonomes, particulièrement dans des environnements dynamiques et en perpétuel changement.

Imaginez un véhicule autonome capable d’ajuster instantanément sa conduite en réponse à des conditions de route glissantes, un drone suivant avec précision un skieur en descente malgré des vents violents, ou un robot spatial capable de tracter divers objets dans l’espace. Ce sont là quelques-unes des applications potentielles de cette nouvelle méthode d’apprentissage.

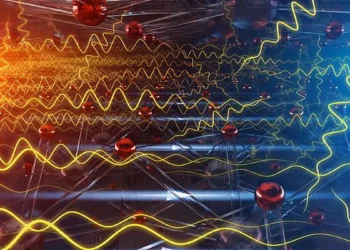

Les chercheurs ont réussi à intégrer des éléments de la théorie de contrôle dans le processus d’apprentissage d’un modèle, ce qui permet d’avoir la main de manière efficace sur des systèmes dynamiques complexes, comme ceux influencés par les impacts du vent sur la trajectoire d’un véhicule volant.

Selon Navid Azizan, Professeur adjoint au Département de génie mécanique du MIT et membre du Laboratoire d’Information et de Systèmes de Décision (LIDS), « l’objectif de notre travail est d’apprendre la structure intrinsèque de la dynamique du système afin de concevoir des régulateurs plus efficaces et stabilisants« .

Une méthode plus rapide et plus performante

À la différence des autres méthodes d’apprentissage automatique qui nécessitent des étapes supplémentaires pour dériver ou apprendre un régulateur, l’approche de ces chercheurs extrait instantanément un régulateur efficace à partir du modèle. De plus, leur méthode permet d’apprendre un régulateur efficace en utilisant moins de données que les autres approches, ce qui pourrait permettre à leur système de contrôle basé sur l’apprentissage d’atteindre de meilleures performances plus rapidement dans des environnements en constante évolution.

Spencer M. Richards, auteur principal de l’étude et étudiant diplômé à l’Université Stanford, explique que cette méthode « cherche à trouver un équilibre entre l’identification de la structure du système et l’apprentissage d’un modèle à partir des données ». Il ajoute que leur approche « tente d’identifier une structure utile à partir des données qui indique comment mettre en œuvre votre logique de contrôle« .

Apprendre à contrôler

Le défi de déterminer la meilleure façon de contrôler un robot pour accomplir une tâche donnée est complexe, même lorsque les chercheurs savent comment modéliser tous les aspects du système. Le contrôleur est la logique qui permet à un drone de suivre une trajectoire souhaitée, par exemple. Celui-ci indique au drone comment ajuster les forces de ses rotors pour compenser l’effet des vents qui peuvent le dévier d’une trajectoire stable pour atteindre son objectif.

« Les autres approches qui tentent d’apprendre la dynamique et un contrôleur à partir des données en tant qu’entités séparées sont un peu détachées philosophiquement de la façon dont nous le faisons normalement pour des systèmes plus simples. Notre approche rappelle davantage la dérivation de modèles à la main à partir de la physique et la liaison de cela au contrôle« , explique Richards.

Identifier la structure

L’équipe du MIT et de Stanford a développé une technique qui utilise l’apprentissage automatique pour apprendre le modèle de dynamique, mais de telle manière que le modèle a une structure prescrite qui est utile pour contrôler le système. « Nous avons constaté qu’au-delà de l’apprentissage de la dynamique, il est également essentiel d’apprendre la structure orientée vers le contrôle qui soutient la conception efficace du contrôleur« , explique Azizan.

En testant cette approche, les chercheurs ont constaté que leur contrôleur suivait de près les trajectoires souhaitées, surpassant toutes les méthodes de référence. De plus, leur méthode s’est révélée être efficiente en termes de données, ce qui signifie qu’elle a obtenu de hautes performances même avec peu de données.

Une technique générale et prometteuse

L’approche proposée par ces chercheurs est générale et pourrait être appliquée à de nombreux types de systèmes dynamiques, des bras robotiques aux vaisseaux spatiaux en libre vol opérant dans des environnements à faible gravité. À l’avenir, ils sont intéressés par le développement de modèles plus physiquement interprétables, qui seraient en mesure d’identifier des informations très spécifiques sur un système dynamique, ce qui pourrait conduire à des contrôleurs mieux performants.

En synthèse

L’approche innovante proposée par les chercheurs du MIT et de l’Université Stanford pourrait révolutionner le contrôle des systèmes dynamiques tels que les drones ou les véhicules autonomes. Grâce à leur méthode, ces systèmes pourraient s’adapter plus rapidement et de manière plus performante aux conditions environnementales en constante évolution. Cette technique, qui a montré une efficacité remarquable en termes de données, a un potentiel immense et pourrait être appliquée à de nombreux types de systèmes dynamiques.

Pour une meilleure compréhension

Qu’est-ce qu’un système dynamique ?

Un système dynamique est un système physique qui évolue dans le temps, par exemple, un drone dont la position et la vitesse changent au fur et à mesure qu’il vole à travers l’environnement.

Qu’est-ce que la théorie de contrôle ?

La théorie de contrôle est une branche des mathématiques qui traite des systèmes dynamiques avec des entrées, et comment modifier les entrées pour obtenir un comportement souhaité du système.

Comment cette nouvelle approche améliore-t-elle le contrôle des systèmes dynamiques ?

En intégrant des éléments de la théorie de contrôle dans le processus d’apprentissage d’un modèle, les chercheurs ont réussi à créer une méthode qui permet de contrôler efficacement des systèmes dynamiques complexes. De plus, leur méthode permet d’apprendre un régulateur efficace en utilisant moins de données que les autres approches. Cela permet à leur système de contrôle basé sur l’apprentissage d’atteindre de meilleures performances plus rapidement dans des environnements en constante évolution.

Les autres auteurs de l’article (« Learning Control-Oriented Dynamical Structure from Data« ) sont Jean-Jacques Slotine, professeur de génie mécanique et de sciences du cerveau et de la cognition au MIT, et Marco Pavone, professeur associé d’aéronautique et d’astronautique à Stanford.

Légende illustration principale : Des chercheurs du MIT et de l’université de Stanford ont créé une méthode d’apprentissage automatique qui permet d’obtenir un contrôleur pour un robot, un drone ou un véhicule autonome plus efficace que les autres méthodes pour suivre une trajectoire stable. Cette technique pourrait aider, par exemple, un drone à suivre de près un skieur de descente malgré les vents violents. Crédit MIT

Cette recherche est soutenue, en partie, par la NASA University Leadership Initiative et le Conseil de recherches en sciences naturelles et en génie du Canada.