Avec le Titan, le Laboratoire national d’Oak Ridge (ORNL) vient de lancer une nouvelle lignée de supercalculateurs, un système capable de réaliser plus de 20.000 milliards d’opérations de calcul à la seconde (ou 20 petaflops) – en employant une famille de processeurs dédiés au traitement graphique.

Titan sera ainsi 10 fois plus puissant que le Jaguar, le dernier supercalculateur en date de l’ORNL.

Soutenu par le ministère américain de l’Énergie, Titan fournira une puissance de calcul sans précédent pour la recherche, en matière d’énergie, de changement climatique, de moteurs, de matériaux ainsi que d’autres disciplines ouvrant la voie à un large éventail d’applications.

Le système Cray XK7 contient 18.688 nœuds, comprenant chacun un processeur AMD Opteron 16-core 6274, et une carte de traitement graphique GPU NVIDIA Tesla K20. Il possède également plus de 700 téraoctets de mémoire. L’association d’unités centrales de traitement (CPU) et de GPU (Graphics Processing Unit) plus modernes permet à Titan d’occuper le même espace que son prédécesseur en réclamant seulement un peu plus d’électricité. En effet, ce dernier requiert une puissance électrique de 8,2 MW et devient le 3ème supercalculateur le plus vert au monde.

"Aujourd’hui, l’un des défis des supercalculateurs demeure relatif à la consommation énergétique", a déclaré Jeff Nichols, directeur associé du laboratoire pour les sciences informatiques et computationnelles. "La combinaison des CPU et GPU dans un seul système nécessite moins d’énergie que le processeur seul, permettant au final de réduire notre empreinte carbone."

Parce qu’ils opèrent des centaines de calculs simultanément, la GPU peut être sollicitée davantage que le processeur, en un temps donné. En s’appuyant sur les 299.008 cœurs et sur le nouveau GPU NVIDIA, Titan permettra aux chercheurs d’effectuer des calculs scientifiques avec plus de rapidité et de précision. "Titan aidera les scientifiques à simuler des systèmes physiques d’une façon plus réaliste avec beaucoup plus de détails", a déclaré James Hack, directeur du Centre national de l’ORNL.

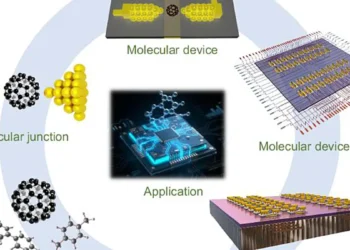

Parmi les applications scientifiques phares sur Titan, on trouve :

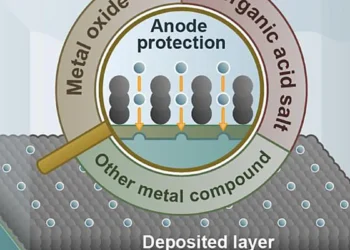

[ Science des matériaux ] : Les propriétés magnétiques des matériaux détiennent la clé pour des avancées technologiques majeures. L’application WL-LSMS par exemple fournit une analyse nanométrique de matériaux cruciaux tels que les aciers, les alliages fer-nickel et les aimants permanents qui aideront à concevoir les futurs moteurs et générateurs électriques. Titan permettra aux chercheurs d’améliorer les calculs sur les états magnétiques des matériaux car ces derniers varient en fonction de la température. "L’augmentation de l’ordre de grandeur de la puissance de calcul disponible avec Titan va nous permettre d’étudier des modèles encore plus réalistes, avec une meilleure précision", a déclaré Markus Eisenbach, chercheur à l’ORNL et concepteur du WL-LSMS.

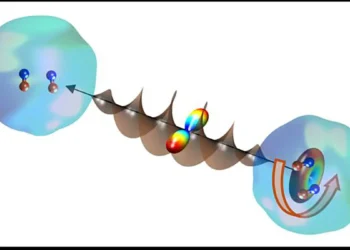

[ Combustion ] : La modélisation 3D des turbulences générées par la combustion du carburant dans un moteur à combustion interne. Cet axe de recherche est essentiel à la politique américaine menée dans les économies d’énergie, étant donné que les trois quarts des combustibles fossiles utilisés aux États-Unis alimentent les voitures et les camions, produisant un quart des gaz à effet de serre du pays. Titan devrait permettre aux chercheurs de modéliser de grosses molécules d’hydrocarbures telles que l’isooctane, une essence de substitution ; des alcools éthyliques tels que l’éthanol et le butanol, ainsi que des biocarburants qui mélangent du butanoate de méthyle, du décanoate de méthyle et du heptane. "En particulier, ces simulations nous permettront de comprendre les complexités associées à un fort couplage entre la chimie des carburants et la turbulence à des températures basses de préallumage", a précisé Jacqueline Chen, membre de l’équipe du Sandia National Laboratories.

[ Énergie nucléaire ] : Les chercheurs du nucléaire utilisent l’application Denovo pour modéliser le comportement des neutrons dans un réacteur nucléaire. Les centrales nucléaires américaines – vieillissantes – fournissent environ un cinquième de l’électricité du pays. Denovo aura donc pour mission d’aider à prolonger leur durée de vie tout en assurant une sécurité maximale. Titan permettra par exemple à l’application de simuler le fonctionnement d’une barre de combustible dans le cœur d’un réacteur en 13 heures au lieu de 60 heures requis sur le supercalculateur Jaguar.

[ Changements climatiques ] : The ‘Community Atmosphere Model-Spectral Element’ simule à long terme le climat mondial. L’amélioration de la modélisation de l’atmosphère aidera les chercheurs à mieux comprendre la qualité future de l’air ainsi que l’effet des particules en suspension dans l’air.

Sur une superficie de 14 km, le nouveau système sera en mesure de simuler entre un et cinq ans par jour de temps de calcul. "Comme les scientifiques sont invités à répondre aux questions sur le changement climatique, la charge de travail pour les modèles climatiques mondiaux augmentent de façon spectaculaire", a souligné Kate Evans de l’ORNL. "Titan va nous aider à répondre à la complexité qui sera nécessaire dans de tels modèles."

Ben ça alors c’est fort ! Bon 20 peta c’est 10x fois mieux que la génération d’avant sachant qu’une carte graphique haut de gamme approche les 2 tera flops actuellement. L’agencement n’est pas différent d’un datacenter dans le principe et les techniques de cablage. Donc c’est un peu « as usual » : les CPU-GPU ont amélioré leurs perfs , les super-bécanes basées dessus également , c’est assez logique et comme il y aura toujours quelqu’un pour mettre les millions$ sur la table.. Ce que je regrette, c’est qu’on met toujours le focus sur l’aspect matériel alors que le logiciel est depuis longtemps le grand défi de ces super-machines. En effet , pour mériter l’appellation de super-calculateur , il faut faire tourner une application UNIQUE sur toutes ces puces et non pas comme n’importe quel datacenter, autant de programmes que de cartes!! Et c’est là que ça se complique car les applis scientifiques sont souvent écrites en Fortran , language de boeufs dont personne ne veut à part eux. Il faut donc que le compilateur Fortran soit mis à jour pour supporter tous ces cores (2000 par carte au moins..) et le vénérable Fortran n’a pas du tout été conçu pour ça aux âges paléolitiques où il a été inventé.. Plus sérieusement, le calcul parallèle est une discipline pas intuitive du tout dont les fabricants de puces se sont emparés car ils ne parviennent plus à augmenter la puissance des cores mais seulement leur nombre.. Intel (grand absent de ce projet) tient à jour une suite de compilateurs et une base documentaire pour développeurs, sans parler du démarchage téléphonique qu’ils font aux développeurs qui acceptent de s’arracher les cheveux avec ce binz.. Mais pour la faire courte, tous les anciens langages se sont plus ou moins adaptés au multi-core-thread mais les véritables innovations dans ce domaine proviennent de langages spécifiquement conçus pour le capa (calcul parallèle) sur unités de calcul hétérogènes (shaders, tesselation, x86, …) comme celles qui animent les milliers de cores qui composent un GPU de bonne facture Ces petits nouveaux, s’appellent CUDA, OpenCL et plus généralement GPGPU .. Mais entre ça et le Fortran, il y a deux générations, façons de penser et modèles académiques totalement incompatibles… Bref si le matériel permet d’aligner de jolis chiffres de perfs, le logiciel peut parfaitement annuler toutes ces améliorations en perdant son efficacité au prorata du nombre de cores, bref, à ce prix là , la machine devient juste un très onéreux chauffage électrique. Mais je pense et j’espère que les « chercheurs » on fait le nécessaire… Simplement , ce serait sympa de parler de l’aspect logiciel