La capacité des grands modèles de langage à collecter et exposer des données privées et personnelles va bien au-delà des informations sur lesquelles ils s’entraînent ou mémorisent, selon une recherche de Northeastern.

Les préoccupations concernant la vie privée autour des grands modèles de langage comme ChatGPT, Claude et Gemini sont plus graves que les simples données que les algorithmes ingèrent, selon un expert en informatique de l’Université Northeastern.

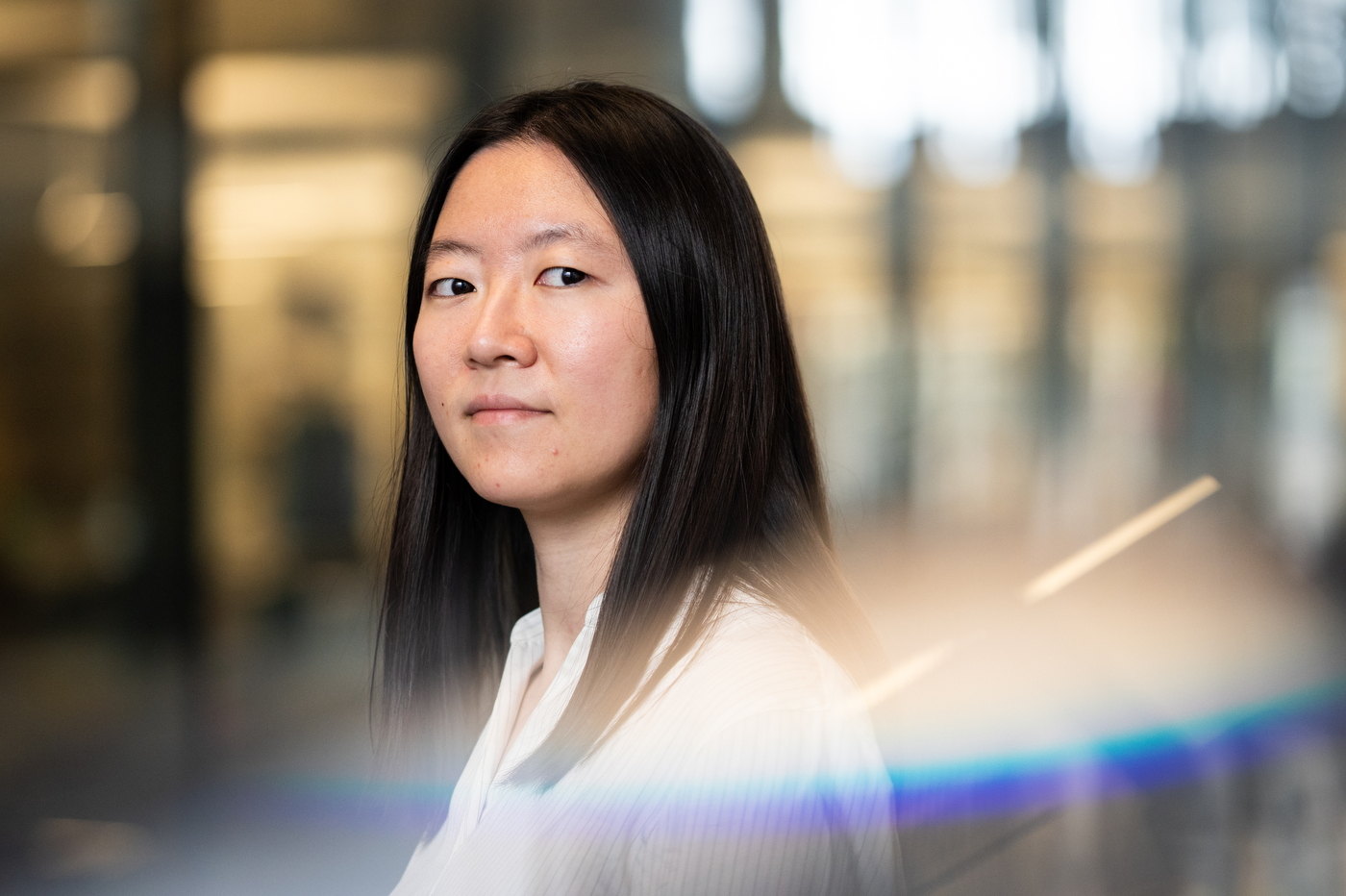

Il existe quatre autres menaces critiques et sous-étudiées pour la vie privée que l’intelligence artificielle pose : le consentement non éclairé dans les accords utilisateur, les outils d’IA autonomes qui ne comprennent pas les normes de confidentialité, l’inférence profonde qui permet la collecte rapide de données personnelles et l’agrégation directe d’attributs, qui démocratise les capacités de surveillance, argumente Tianshi Li, professeure adjointe en informatique à l’Université Northeastern.

Dans une revue de la littérature de plus de 1 300 articles de conférences en informatique de la dernière décennie traitant des préoccupations de confidentialité avec les grands modèles de langage, ou LLM, Li a observé que 92 % d’entre eux se concentraient sur les problèmes de mémorisation et de fuite de données, sous-estimant radicalement l’agrégation de données, l’inférence profonde et l’IA agentielle.

Les LLM peuvent percer votre bulle personnelle

La mémorisation des données, explique Li, est le processus par lequel un LLM ingère un ensemble de données et encode cette information dans ses algorithmes.

Toutes les données qu’un LLM lit ne sont pas mémorisées, une grande partie est simplement apprise puis rejetée, comme apprendre la grammaire d’une langue, comment les mots s’assemblent, sans apprendre le vocabulaire exact. Les données mémorisées sont réutilisées à plusieurs reprises jusqu’à ce qu’elles soient intégrées au système.

Cependant, il est incroyablement difficile de savoir quelles informations ont été mémorisées par le LLM, note Li, et surtout, « vous ne savez pas comment les effacer de la mémoire du modèle si vous souhaitez les supprimer. »

Pourtant, affirme Li, il existe au moins quatre autres façons dont les LLM peuvent créer des préoccupations significatives en matière de vie privée pour les utilisateurs et les non-utilisateurs.

L’une de ces façons, le consentement non éclairé, est familière à beaucoup de ceux qui utilisent régulièrement Internet, et comprend des formulaires de consentement ou de désinscription complexes qui obscurcissent les informations collectées par un site web. Chacune des entreprises examinées par les chercheurs avait des lacunes importantes leur permettant de conserver certains échanges avec leurs LLM même après qu’un utilisateur s’était désinscrit.

Tant de données étant conservées, il est difficile de savoir exactement quelles données sont ou ne sont pas stockées à long terme.

Les préoccupations autour de la mémorisation des données et du consentement non éclairé tournent autour de la fuite : les informations que le LLM a mémorisées pourraient être exposées à quelqu’un qui n’était pas censé les voir. Les trois autres préoccupations sont plus sinistres.

Agents, inférence et agrégation

Le troisième problème de confidentialité réside dans les capacités de plus en plus agentielles et autonomes que possèdent les grands modèles de langage et qu’ils continuent d’acquérir à un rythme rapide, explique Li.

Par exemple, certains utilisateurs intègrent désormais des LLM dans des comptes e-mail pour écrire des réponses automatiques. Ces outils ont accès à des éléments comme « des sources de données propriétaires, ou l’ensemble de l’Internet ouvert », précise Li.

Le problème est que les LLM ne comprennent ni ne respectent la vie privée, souligne Li, et donc la collecte et la diffusion de données personnelles sur l’Internet plus large, ou l’ingestion de données personnelles accidentellement laissées sur Internet, deviennent une réelle possibilité.

« Il y a aussi d’autres cas où des utilisateurs malveillants peuvent armer ces capacités d’IA agentielle, car elles sont capables de récupérer, d’analyser et de synthétiser des informations à une vitesse bien supérieure à celle des humains », poursuit-elle.

Cette vitesse profite à la fois à l’utilisateur moyen et au pirate malveillant essayant de collecter des informations personnelles sur une victime, et voici le problème : les LLM n’ont pas besoin des détails.

C’est la quatrième préoccupation, ce que Li appelle l’inférence profonde. Parce que les LLM sont si bons pour synthétiser et analyser les données si rapidement, « Vous pouvez l’utiliser pour déduire des attributs à partir de données apparemment normales et inoffensives », explique-t-elle. Lorsqu’une de ces IA agentielles regarde une photographie publiée en ligne, que le posteur pourrait penser ne contenir aucune information d’identification, l’IA pourrait néanmoins être capable de déduire un emplacement précis.

Soudain, une photo de médias sociaux peut être utilisée pour indiquer exactement à un utilisateur malveillant où vous étiez lorsque cette photo a été prise.

À titre d’exemple, Li suggère de demander à ChatGPT « de rechercher votre adresse e-mail, puis de lui demander d’essayer d’obtenir toutes les informations liées à cette adresse e-mail. Je pense que vous serez surpris par la quantité d’informations qu’il connaît. »

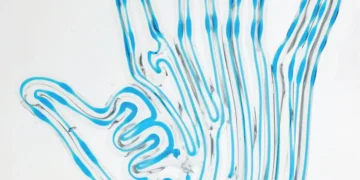

La dernière préoccupation sous-étudiée est l’agrégation directe d’attributs, que Li considère comme potentiellement la plus dangereuse en raison de son accessibilité facile.

L’agrégation directe d’attributs, selon le document de position de Li, démocratise radicalement « la surveillance », en raison de la capacité pure des LLMs à collecter, synthétiser et analyser « de grands volumes d’informations en ligne ».

Même ceux sans compétences en codage ou autres capacités techniques peuvent soudainement récupérer des informations sensibles, donnant un coup de main aux acteurs malveillants en matière d’usurpation d’identité, de cyberharcèlement ou de doxing, c’est à dire la diffusion de détails privés sur Internet avec l’intention de nuire.

Partager vos informations

Certains des dangers pour la vie privée sont peut-être désormais inévitables, déclare Li, et les risques vont au-delà de l’utilisation directe des LLMs. Toute divulgation faite maintenant sur Internet pourrait conduire à une violation de la vie privée. « Et très malheureusement, cela implique aussi, peut-être, comment vous avez fait ces divulgations dans le passé », poursuit-elle.

Li note que c’est une position un peu pessimiste à prendre, mais espère qu’à mesure que les gens prennent davantage conscience des risques, ils pourront prendre des décisions mieux informées sur les informations qu’ils partagent en ligne.

Source : Northeastern U.