Une équipe de chercheurs a récemment démontré que le matériel analogique utilisant des dispositifs ECRAM permettait de maximiser les performances de calcul de l’intelligence artificielle, ouvrant la voie à une possible commercialisation.

Leur étude met en lumière des avancées significatives dans le domaine de l’ingénierie des matériaux et de l’ingénierie des semi-conducteurs.

Ces dispositifs ont été testés dans un environnement contrôlé, démontrant des caractéristiques électriques et de commutation exceptionnelles. L’équipe a également observé un rendement élevé et une uniformité remarquable dans les dispositifs fabriqués.

La progression rapide de la technologie de l’IA, y compris les applications comme l’IA générative, a poussé les limites de l’évolutivité du matériel numérique existant (CPU, GPU, ASIC, etc.). En conséquence, des recherches actives sont menées sur le matériel analogique spécialisé pour le calcul de l’IA.

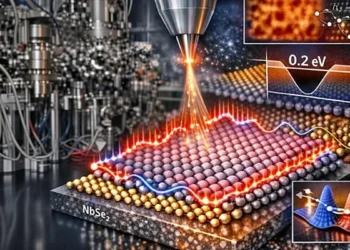

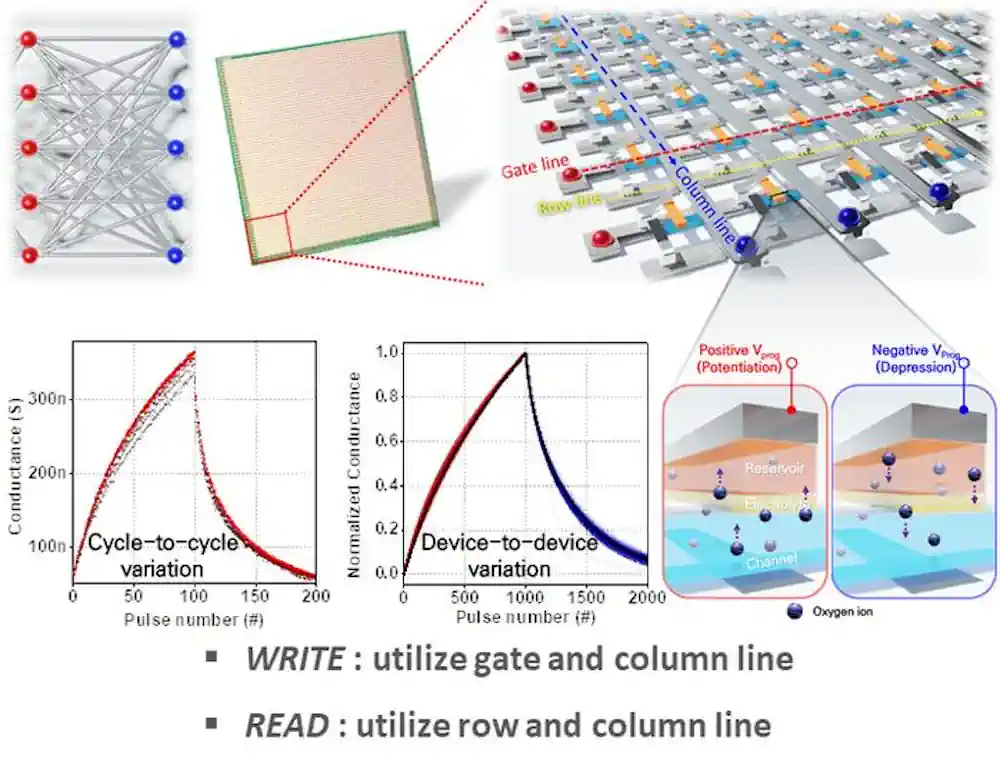

Le matériel analogique ajuste la résistance des semi-conducteurs en fonction de la tension ou du courant externe et utilise une structure de réseau croisé avec des dispositifs de mémoire croisés verticalement pour traiter les calculs d’IA en parallèle. Bien que cela offre des avantages pour certaines tâches de calcul et le traitement continu des données, répondre aux exigences diverses de l’apprentissage et de l’inférence computationnels reste un défi.

Pour surmonter les limitations des dispositifs de mémoire analogique, l’équipe de recherche s’est concentrée sur la Mémoire à Accès Aléatoire Électrochimique (ECRAM), qui gère la conductivité électrique par le mouvement et la concentration des ions. Contrairement à la mémoire traditionnelle des semi-conducteurs, ces dispositifs possèdent une structure à trois terminaux avec des chemins séparés pour la lecture et l’écriture des données, permettant une opération à relativement faible puissance.

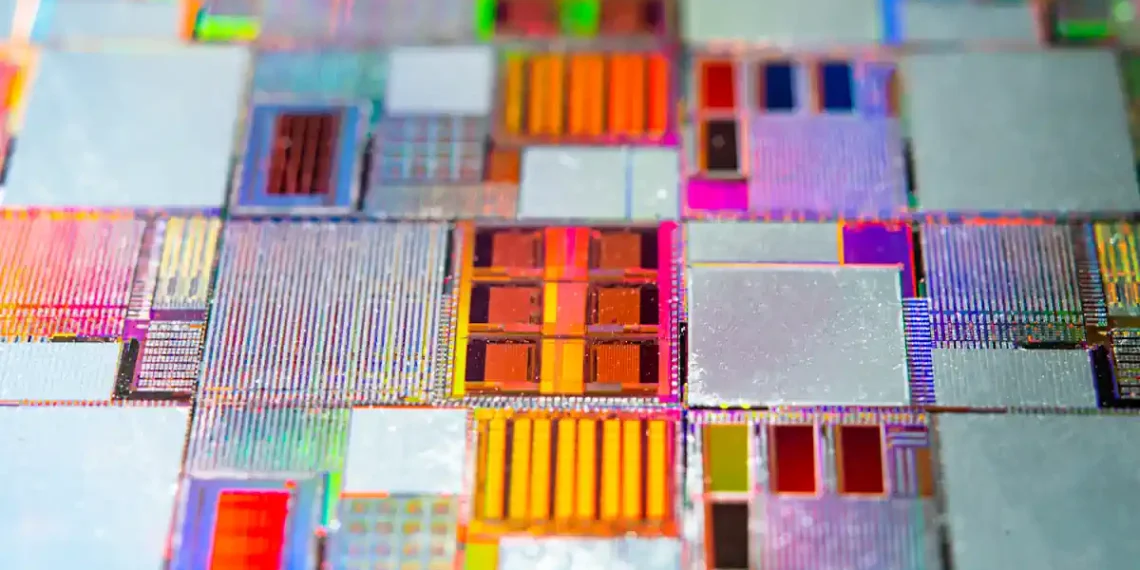

Dans leur étude, l’équipe a fabriqué avec succès des dispositifs ECRAM en utilisant des semi-conducteurs basés sur trois terminaux dans une matrice de 64×64. Les expériences ont révélé que le matériel incorporant les dispositifs de l’équipe présentait d’excellentes caractéristiques électriques et de commutation, ainsi qu’un rendement et une uniformité élevés.

En appliquant l’algorithme Tiki-Taka, un algorithme d’apprentissage analogique de pointe, à ce matériel à haut rendement, l’équipe a réussi à maximiser la précision des calculs d’entraînement des réseaux neuronaux de l’IA. Les chercheurs ont démontré l’impact de la propriété de «rétention de poids» du matériel d’entraînement sur l’apprentissage et ont confirmé que leur technique n’entraîne pas une surcharge des réseaux neuronaux artificiels.

Cette recherche est significative car la plus grande matrice de dispositifs ECRAM pour le stockage et le traitement des signaux analogiques rapportée dans la littérature à ce jour est de 10×10. Les chercheurs ont maintenant réussi à mettre en œuvre ces dispositifs à une échelle beaucoup plus grande, avec des caractéristiques variées pour chaque dispositif.

Le professeur Seyoung Kim de POSTECH a déclaré : «En réalisant des matrices à grande échelle basées sur des technologies de dispositifs de mémoire novatrices et en développant des algorithmes d’IA spécifiques à l’analogique, nous avons identifié un potentiel de performance de calcul de l’IA et d’efficacité énergétique qui dépasse de loin les méthodes numériques actuelles.»

Article : « Retention-aware zero-shifting technique for Tiki-Taka algorithm-based analog deep learning accelerator » – DOI: 10.1126/sciadv.adl3350