Alors que les limites de l’informatique classique se précisent, un domaine de recherche, longtemps confiné aux marges du possible, gagne en maturité. Le Quantum Systems Accelerator (QSA), un consortium réunissant quinze institutions sous l’égide du Département de l’Énergie américain, concentre ses efforts sur une technologie encore balbutiante : les qubits supraconducteurs. Ces unités d’information, refroidies à des températures proches du zéro absolu, pourraient un jour constituer la base d’ordinateurs capables de résoudre des problèmes hors de portée des machines actuelles. Trois axes de travail, récemment détaillés dans une série de publications, illustrent les avancées méthodiques de cette quête.

Simuler l’invisible : une grille de qubits pour explorer l’électromagnétisme

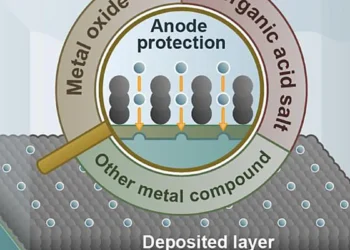

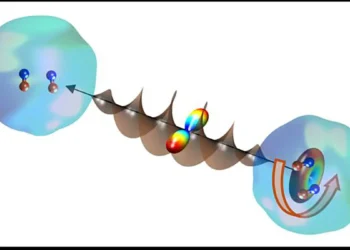

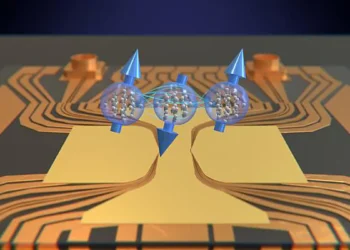

Au Massachusetts Institute of Technology (MIT), une équipe a franchi une étape dans la manipulation des qubits transmon, des composants supraconducteurs particulièrement stables. En disposant seize de ces éléments en une grille de 4×4, les chercheurs ont reproduit un phénomène clé de la physique : l’effet Hall. Ce comportement, observé lorsque des particules chargées sont déviées par un champ magnétique perpendiculaire, a été simulé à l’aide de signaux électriques continus appliqués via des lignes de contrôle indépendantes. Leur dispositif émule ainsi un « potentiel vecteur magnétique », un concept central en électromagnétisme qui influence la dynamique des particules.

Cette réalisation ne se limite pas à une démonstration technique. Elle permet d’envisager l’étude de matériaux quantiques aux propriétés inédites, depuis les supraconducteurs fonctionnant à température ambiante jusqu’aux structures topologiques aux comportements électroniques exotiques. Les simulations quantiques pourraient accélérer la découverte de composés révolutionnaires, au lieu de se limiter à des expérimentations coûteuses en laboratoire.

Contrôler l’insaisissable : l’IA au cœur des systèmes quantiques

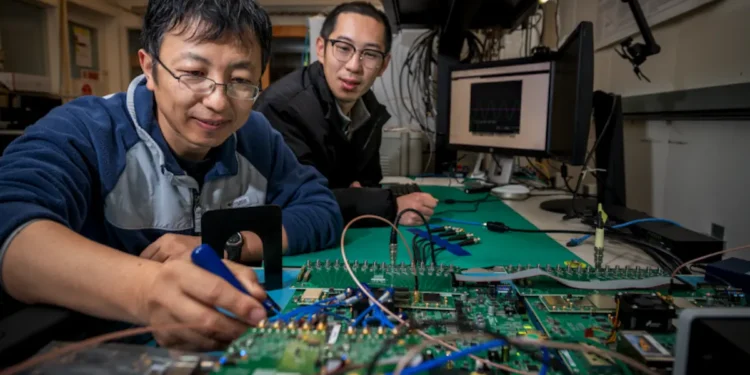

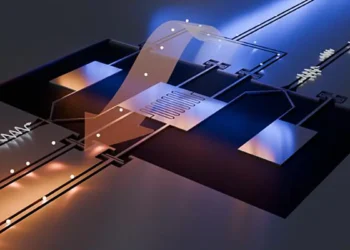

Au Lawrence Berkeley National Laboratory, une autre facette du défi quantique est prise à bras-le-corps : le contrôle des qubits. Le système QubiC 2.0, une plateforme électronique modulaire basée sur des circuits FPGA programmables, intègre désormais un réseau neuronal directement sur puce. Cette innovation permet d’analyser en temps réel l’état des qubits, avec une latence de 54 nanosecondes pour la discrimination d’états quantiques. Résultat : la fidélité des mesures passe de 92 % à 98 %, un gain substantiel pour la fiabilité des calculs.

L’intérêt de cette approche réside dans son adaptabilité. Les algorithmes d’apprentissage automatique pourraient non seulement corriger les erreurs en temps réel, mais aussi optimiser les opérations en fonction des caractéristiques individuelles des qubits. Une telle personnalisation serait impensable avec des méthodes traditionnelles, souvent génériques et peu flexibles.

Évaluer pour progresser : le « mirror randomized benchmarking »

La performance des processeurs quantiques dépend aussi de leur capacité à identifier et à quantifier les erreurs. Une collaboration entre l’Université de Californie à Berkeley, le Berkeley Lab et les Sandia National Laboratories a abouti au développement du « mirror randomized benchmarking » (MRB). Cette technique, évolution d’une méthode existante, permet d’évaluer la fidélité des portes logiques quantiques à grande échelle.

Contrairement au « randomized benchmarking » classique, limité aux systèmes à faible nombre de qubits, le MRB utilise des séquences de portes « miroir » pour amplifier la sensibilité aux erreurs de diaphonie — ces interférences parasites entre qubits voisins. Son application à des architectures comptant des milliers d’unités devient ainsi envisageable. Les premiers résultats révèlent que ces erreurs représentent une fraction significative des défaillances dans les processeurs actuels, soulignant l’urgence de stratégies de correction ciblées.

Un écosystème en mutation

Les travaux du QSA reflètent une tendance plus large : la montée en puissance des technologies quantiques supraconductrices. Chaque avancée, qu’elle touche à la simulation, au contrôle ou à l’évaluation, contribue à combler l’écart entre théorie et application pratique. Les collaborations interinstitutionnelles, combinées à l’ouverture de certaines technologies (comme le QubiC 2.0, disponible en open source), accélèrent la diffusion de leurs savoir-faire.

Reste que le chemin vers l’ordinateur quantique universel, tolérant aux erreurs, reste semé d’obstacles. Les températures extrêmes requises, la fragilité des qubits face aux perturbations externes, ou encore la complexité de l’ingénierie à grande échelle constituent autant de défis persistants. Pourtant, l’ampleur des investissements — tant publics que privés — et la créativité des approches laissent entrevoir des progrès rapides.

Un futur en construction

L’informatique quantique ne se résume pas à une course technologique. Elle représente un changement de paradigme, où la maîtrise des lois quantiques redéfinit les frontières du calculable. Le QSA, à travers ses projets structurants, participe à cette révolution silencieuse. Ses contributions, bien que spécialisées, esquissent déjà les contours d’une ère où la simulation de molécules complexes, l’optimisation de systèmes critiques ou la cryptographie post-quantique deviendront des réalités tangibles.

La question n’est plus de savoir si cette transition aura lieu, mais à quel rythme elle s’opérera — et dans quelles mains se concentreront ses bénéfices. Dans ce paysage en mouvement, chaque article scientifique, chaque logiciel open source, et chaque collaboration internationale dessine un peu plus le visage d’un futur désormais à portée de qubits.

Lexique

- Qubits supraconducteurs : Unités d’information quantique refroidies à 20 millikelvins, exploitant les propriétés de matériaux supraconducteurs pour des calculs exponentiellement plus puissants.

- Effet Hall : Phénomène physique où une particule chargée est déviée latéralement sous l’effet d’un champ magnétique perpendiculaire, simulé par le MIT via des qubits.

- QubiC 2.0 : Plateforme électronique open source du Berkeley Lab, utilisant des FPGA et un réseau neuronal pour contrôler les qubits avec une latence de 54 nanosecondes.

- Mirror randomized benchmarking (MRB) : Méthode d’évaluation des portes logiques quantiques, détectant les erreurs de diaphonie dans des systèmes à milliers de qubits, contrairement aux méthodes traditionnelles.

- Diaphonie quantique : Interférences parasites entre qubits voisins, réduisant la fidélité des calculs et diagnostiquées via le MRB.

- Transmon : Type de qubit supraconducteur stable, manipulé par des signaux électriques continus pour simuler des champs magnétiques synthétiques.

- Potentiel vecteur magnétique : Concept électromagnétique décrivant l’influence d’un champ magnétique sur des particules chargées, émulé par les grilles de qubits du MIT.

Légende illustration : Co-dirigeants des projets QubiC et QubiC 2.0 de la division ATAP (Accelerator Technology & Applied Physics) du Berkeley Lab.