Une nouvelle technique développée par des chercheurs permet aux programmes d’intelligence artificielle (IA) de mieux cartographier les espaces tridimensionnels à partir d’images bidimensionnelles capturées par plusieurs caméras. Cette méthode, efficace même avec des ressources informatiques limitées, pourrait améliorer la navigation des véhicules autonomes.

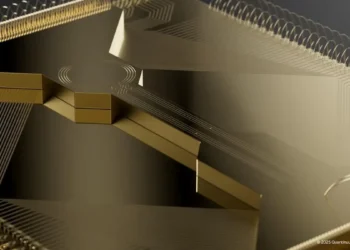

Les véhicules autonomes utilisent des programmes d’IA puissants, appelés transformateurs de vision, pour transformer des images 2D en une représentation 3D de leur environnement.

Tianfu Wu, auteur correspondant d’un article sur cette recherche et professeur associé en génie électrique et informatique à l’Université d’État de Caroline du Nord, explique : « La plupart des véhicules autonomes utilisent des transformateurs de vision pour prendre des images 2D de plusieurs caméras et créer une représentation de l’espace 3D autour du véhicule. Cependant, bien que chaque programme d’IA adopte une approche différente, il reste encore une marge d’amélioration substantielle. »

Présentation de la technique MvACon

La technique, nommée Multi-View Attentive Contextualization (MvACon), est un complément plug-and-play qui peut être utilisé avec les transformateurs de vision existants pour améliorer leur capacité à cartographier les espaces 3D. « Les transformateurs de vision ne reçoivent pas de données supplémentaires de leurs caméras, ils sont simplement capables de mieux utiliser les données », précise Tianfu Wu.

MvACon fonctionne en modifiant une approche appelée Patch-to-Cluster attention (PaCa), que Wu et ses collaborateurs ont publiée l’année dernière. PaCa permet aux transformateurs de mieux identifier les objets dans une image. « L’avancée clé ici est d’appliquer ce que nous avons démontré avec PaCa au défi de la cartographie de l’espace 3D en utilisant plusieurs caméras », ajoute Wu.

Tests et résultats

Pour tester la performance de MvACon, les chercheurs l’ont utilisé avec trois transformateurs de vision de pointe : BEVFormer, la variante BEVFormer DFA3D et PETR. Dans chaque cas, les transformateurs collectaient des images 2D de six caméras différentes. MvACon a significativement amélioré la performance de chaque transformateur.

« La performance a été particulièrement améliorée en ce qui concerne la localisation des objets, ainsi que la vitesse et l’orientation de ces objets », indique Wu. « Et l’augmentation de la demande informatique due à l’ajout de MvACon aux transformateurs de vision a été presque négligeable. »

Les prochaines étapes incluent des tests de MvACon sur des ensembles de données de référence supplémentaires, ainsi que des tests sur des entrées vidéo réelles provenant de véhicules autonomes. Si MvACon continue de surpasser les transformateurs de vision existants, les chercheurs sont optimistes quant à son adoption généralisée.

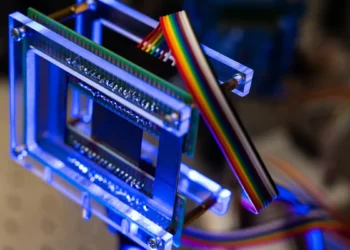

Légende illustration : Crédit Robin Pierre

Article: « Multi-View Attentive Contextualization for Multi-View 3D Object Detection »- ( accéder au .PDF )

Résumé : Nous présentons la contextualisation attentive multi-vues (MvACon), une méthode simple mais efficace pour améliorer l’élévation des caractéristiques 2D vers 3D dans la détection d’objets 3D multi-vues basée sur des requêtes (MV3D). Malgré les progrès remarquables enregistrés dans le domaine de la détection d’objets MV3D basée sur des requêtes, les méthodes antérieures souffrent souvent soit de l’absence d’exploitation des caractéristiques 2D à haute résolution dans l’extraction dense basée sur l’attention, en raison des coûts de calcul élevés, soit d’un ancrage insuffisamment dense des requêtes 3D aux caractéristiques 2D multi-échelles dans l’extraction clairsemée basée sur l’attention. Notre proposition MvACon fait d’une pierre deux coups en utilisant un schéma de contextualisation des caractéristiques attentionnelles à la fois dense sur le plan représentationnel et peu coûteux sur le plan informatique, qui ne dépend pas d’approches spécifiques d’élévation des caractéristiques de 2D à 3D. Dans les expériences, le MvACon proposé est testé de manière approfondie sur le benchmark nuScenes, en utilisant à la fois le BEVFormer et sa récente variante d’attention déformable en 3D (DFA3D), ainsi que le PETR, montrant une amélioration constante des performances de détection, en particulier dans l’amélioration des performances de prédiction de la localisation, de l’orientation et de la vélocité. Il est également testé sur le benchmark Waymo-mini en utilisant BEVFormer avec des améliorations similaires. Nous montrons qualitativement et quantitativement que les contextes globaux basés sur des clusters encodent efficacement des contextes denses au niveau de la scène pour la détection d’objets MV3D. Les résultats prometteurs de notre proposition MvACon renforcent l’adage de la vision par ordinateur – » les caractéristiques (contextualisées) sont importantes.