Des chercheurs de l’agence scientifique nationale australienne ont développé une technique qui pourrait aider à contrer la montée des fraudes par clonage vocal, qui ont coûté aux victimes plus de 410 millions de dollars au premier semestre 2025.

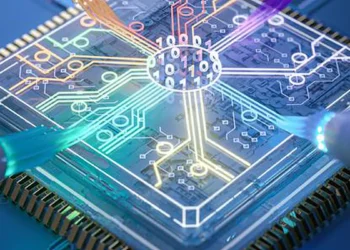

La méthode, appelée Rehearsal with Auxiliary-Informed Sampling (RAIS – Répétition avec échantillonnage assisté par ordinateur), a été annoncée par des scientifiques du CSIRO, de l’Université de la Fédération d’Australie et de l’Université RMIT. Leur technologie détermine si un clip audio est authentique ou généré artificiellement tout en maintenant sa précision face à l’émergence de nouvelles méthodes d’attaque, un défi qui a longtemps affecté les systèmes de détection existants.

Lutter contre l’oubli catastrophique

Contrairement aux systèmes de détection traditionnels qui doivent être réentraînés depuis zéro lorsque de nouvelles techniques de deepfake émergent, RAIS utilise ce que les chercheurs appellent « l’apprentissage continu ». Le système stocke automatiquement un ensemble diversifié d’exemples passés, incluant des traits audio imperceptibles pour les humains, lui permettant de reconnaître de nouveaux styles de deepfakes sans perdre la connaissance des anciens.

« Si vous affinez simplement le modèle sur les nouveaux échantillons, cela entraînera l’oubli par le modèle des anciens deepfakes qu’il connaissait auparavant« , a déclaré le Dr Kristen Moore du Data61 du CSIRO, l’un des auteurs de l’étude. La technique utilise des étiquettes auxiliaires—des marqueurs au-delà des simples classifications « faux » ou « réel »—pour maintenir un mélange riche de données d’entraînement.

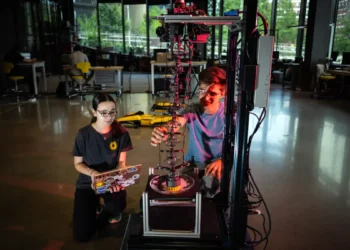

Lors des tests, RAIS a atteint un taux d’erreur moyen de 1,95 pour cent sur une séquence de cinq expériences d’apprentissage consécutives, surpassant les méthodes concurrentes. Le code est désormais disponible sur GitHub.

Un paysage de menaces en expansion

Les deepfakes audio sont devenus un outil pour contourner l’authentification biométrique vocale, l’usurpation d’identité et les campagnes de désinformation. En février, des criminels ont utilisé une voix clonée par IA du ministre italien de la Défense Guido Crosetto pour convaincre un ancien propriétaire de l’Inter Milan de transférer près d’un million d’euros pour ce qui était faussement présenté comme une opération gouvernementale visant à libérer des otages.

Les experts en cybersécurité estiment également que le clonage vocal par IA pourrait avoir facilité une violation des systèmes de Qantas en juin, qui a exposé les données de près de six millions de clients. Les attaquants présumés, un groupe appelé « Scattered Spider », ont un historique documenté d’utilisation de voix synthétiques pour tromper le personnel d’assistance technique afin d’obtenir des identifiants.

« Les deepfakes audio évoluent rapidement, et les méthodes de détection traditionnelles ne peuvent pas suivre« , a conclu Falih Gozi Febrinanto, récent diplômé du doctorat de l’Université de la Federation d’Australie qui a co-écrit la recherche. « RAIS aide le modèle à conserver ce qu’il a appris et à s’adapter aux nouvelles attaques« .

Le code, disponible sur GitHub, reste efficace avec une petite mémoire tampon et est conçu pour maintenir sa précision à mesure que les attaques deviennent plus sophistiquées.

Article : « Rehearsal with Auxiliary-Informed Sampling for Audio Deepfake Detection » – DOI : 10.21437/Interspeech.2025-2298

Source : CSIRO