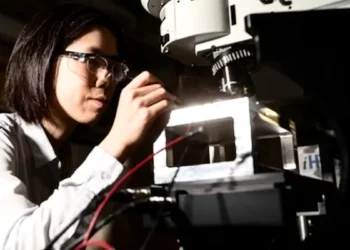

L’efficacité énergétique pose une question majeure dans le développement des intelligences artificielles. Les réseaux neuronaux artificiels, bien que performants, consomment des quantités considérables d’énergie. Des solutions alternatives, comme les neurones à impulsions, pourraient réduire cette consommation. Cependant, leur entraînement s’avère complexe. Une étude récente de l’Université de Bonn propose une nouvelle approche pour résoudre ce problème, offrant ainsi une nouvelle perspective sur l’efficacité énergétique des IA.

Les applications d’IA comme ChatGPT reposent sur des réseaux neuronaux artificiels qui imitent en de nombreux points les cellules nerveuses du cerveau humain. Ces réseaux sont formés grâce à des quantités énormes de données sur des ordinateurs haute performance, ce qui entraîne une consommation conséquente d’énergie. Les neurones à impulsions, moins gourmands en énergie, représentent une solution potentielle à ce défi, mais leur entraînement a longtemps été entravé par des limitations techniques.

L’efficacité des neurones biologiques

Le cerveau humain, avec une consommation énergétique équivalente à celle de trois ampoules LED, illustre parfaitement l’efficacité énergétique. Ce dernier accomplit des tâches complexes avec une précision remarquable. Les neurones biologiques utilisent des impulsions électriques courtes, ou potentiels d’action, pour communiquer. Cette méthode permet une consommation d’énergie réduite comparée aux réseaux neuronaux artificiels traditionnels où le flux électrique est constant.

«Les neurones biologiques fonctionnent différemment,» a expliqué le professeur Raoul-Martin Memmesheimer de l’Institut de génétique de l’Université de Bonn. « Ils communiquent au moyen de courtes impulsions de tension, appelées potentiels d’action ou spikes. » Avec cette méthode, les réseaux fonctionnent avec beaucoup moins d’énergie.

L’entraînement des réseaux à impulsions

Pour qu’un réseau neuronal puisse accomplir des tâches spécifiques, il doit être formé. Ce processus implique l’ajustement des connexions entre les neurones pour minimiser les erreurs. Dans les réseaux conventionnels, les signaux de sortie varient progressivement. «Dans les réseaux neuronaux conventionnels, les signaux de sortie changent graduellement,» a noté Memmesheimer. Cependant, avec les neurones à impulsions, les signaux sont binaires ; un spike est soit présent, soit absent.

La difficulté réside dans le fait que l’on ne peut pas régler finement la force des connexions comme dans les réseaux conventionnels. «Ce qui rend l’ajustement des poids des connexions plus complexe,» a souligné le Dr Christian Klos, co-auteur de l’étude.

Une nouvelle méthode d’entraînement

La recherche récente a montré que les techniques traditionnelles d’apprentissage par descente de gradient, autrefois jugées inappropriées pour les réseaux à impulsions, pouvaient en fait fonctionner. «Nous avons découvert que, dans certains modèles de neurones standards, les spikes ne peuvent pas simplement apparaître ou disparaître. Ils peuvent être avancés ou retardés dans le temps,» a expliqué Christian Klos. Cette découverte permet d’ajuster les temps des impulsions de manière continue en utilisant la force des connexions.

Les motifs temporels des impulsions influencent le comportement des neurones cibles. Plus les signaux arrivent simultanément, plus la probabilité qu’un neurone émette un spike augmente. Ainsi, l’influence d’un neurone sur un autre peut être ajustée à la fois par la force des connexions et le timing des impulsions.

Cette méthode a déjà été appliquée avec succès pour entraîner un réseau neuronal à impulsions à reconnaître des chiffres manuscrits. L’étape suivante consiste à tester cette technique sur des tâches plus complexes comme la compréhension du langage parlé, selon Raoul-Martin Memmesheimer. «Bien que nous ne sachions pas encore quel rôle jouera notre méthode dans l’entraînement des réseaux à impulsions à l’avenir, nous croyons qu’elle possède un grand potentiel en raison de sa précision et de sa similitude avec les méthodes efficaces des réseaux non à impulsions.»

Article : ‘Smooth Exact Gradient Descent Learning in Spiking Neural Networks’ / ( 10.1103/PhysRevLett.134.027301 ) – University of Bonn – Publication dans la revue Physical Review Letters

Source : Université de Bonn