Selon une nouvelle étude américaine, une méthode moins coûteuse pour former de grands modèles de langage, comme la série GPT, permet d’économiser jusqu’à 30 % d’énergie dans le même laps de temps.

Cette approche pourrait permettre d’économiser suffisamment d’énergie pour alimenter 1,1 million de foyers américains en 2026, sur la base des projections de Wells Fargo concernant la demande en énergie de l’IA. Elle pourrait également réduire les prévisions du Fonds monétaire international selon lesquelles les centres de données pourraient représenter 1,2 % des émissions mondiales de carbone d’ici à 2027, ainsi que les besoins en eau liés à cette consommation d’énergie.

Certains experts estiment que ces coûts pourraient être compensés par des avantages environnementaux. Selon eux, l’IA pourrait changer la donne dans la lutte contre le changement climatique en permettant d’optimiser les chaînes d’approvisionnement et le réseau électrique, de gérer nos besoins énergétiques et d’améliorer la recherche sur le changement climatique. Cela n’excuse pas pour autant le gaspillage d’énergie, et une partie de l’énergie utilisée pour entraîner l’IA n’a aucun impact sur le temps d’entraînement et la précision du modèle.

Mosharaf Chowdhury, professeur agrégé d’informatique et d’ingénierie à l’université de Michigan et auteur correspondant de l’étude présentée lors du 30e symposium sur les principes des systèmes d’exploitation, a déclaré : « Pourquoi dépenser quelque chose quand cela ne sert à rien ? »

« Nous ne pouvons pas continuer à construire des centres de données de plus en plus grands, car nous n’aurons pas l’énergie nécessaire pour les faire fonctionner. Si nous parvenons à réduire l’énergie consommée par l’IA, nous pourrons réduire son empreinte carbone et ses besoins en refroidissement et permettre davantage de calculs dans le cadre de nos contraintes énergétiques actuelles. »

Le gaspillage d’énergie se produit lorsque l’entraînement à l’IA est inégalement réparti entre les GPU, qui sont des processeurs informatiques spécialisés dans les applications graphiques et de données volumineuses. Bien qu’elle ouvre la porte au gaspillage, la répartition du travail est nécessaire pour traiter d’énormes ensembles de données.

« Les modèles d’IA sont aujourd’hui si volumineux qu’ils ne peuvent pas tenir dans un seul processeur », explique Jae-Won Chung, doctorant en informatique et ingénierie à l’université de Michigan et premier auteur de l’étude. « Ils doivent être divisés en dizaines de milliers de processeurs pour être entraînés, mais diviser les modèles en tailles parfaitement égales sur tous les processeurs est pratiquement impossible ».

S’il est si difficile de répartir uniformément les tâches de formation, c’est parce que certaines d’entre elles doivent être regroupées sur le même processeur, à l’instar de chaque épisode d’une série de livres dans une étagère organisée. Selon la manière dont les tâches sont regroupées, certains processeurs peuvent se voir confier l’équivalent de l’Encyclopédie Britannica pour la formation à l’IA, tandis que d’autres se verront confier une trilogie fantastique.

Étant donné que les méthodes de formation actuelles font fonctionner chaque processeur à sa vitesse maximale, les processeurs ayant une charge plus légère termineront leurs calculs avant les autres processeurs. Cela n’accélère pas la formation, qui n’est pas terminée tant que chaque processeur n’a pas fini son travail, mais c’est un gaspillage, car des calculs plus rapides nécessitent plus d’énergie. En outre, des problèmes tels qu’un matériel défectueux ou des retards de réseau entraînent un gaspillage d’énergie en ralentissant la vitesse de calcul d’un seul processeur.

Pour économiser de l’énergie, les chercheurs ont mis au point un outil logiciel, appelé Perseus, qui identifie un chemin critique, ou une série de sous-tâches qui prendront le plus de temps à réaliser. Perseus ralentit ensuite les processeurs qui ne sont pas sur le chemin critique afin qu’ils terminent tous leur travail à peu près en même temps, éliminant ainsi toute consommation d’énergie inutile.

« La réduction du coût énergétique de l’IA peut avoir d’importantes répercussions sur l’accès équitable à l’IA », a conclu M. Chowdhury. « Si un pays n’a pas assez d’énergie pour faire tourner un gros modèle, il devra peut-être faire appel à des services éloignés ou se contenter de modèles plus petits et moins précis. Cet écart pourrait perpétuer les disparités entre les différentes communautés ».

L’équipe a testé Perseus en entraînant GPT-3, trois autres grands modèles linguistiques et un modèle de vision par ordinateur.

Perseus est un outil en libre accès disponible dans le cadre de Zeus, un outil de mesure et d’optimisation de la consommation d’énergie de l’intelligence artificielle.

La recherche a été financée par la National Science Foundation, le Dutch Research Council (NWO) Talent Programme, VMware, Mozilla Foundation, Salesforce et Kwanjeong Educational Foundation. Chameleon Cloud et CloudLab ont soutenu la recherche en fournissant des ressources informatiques.

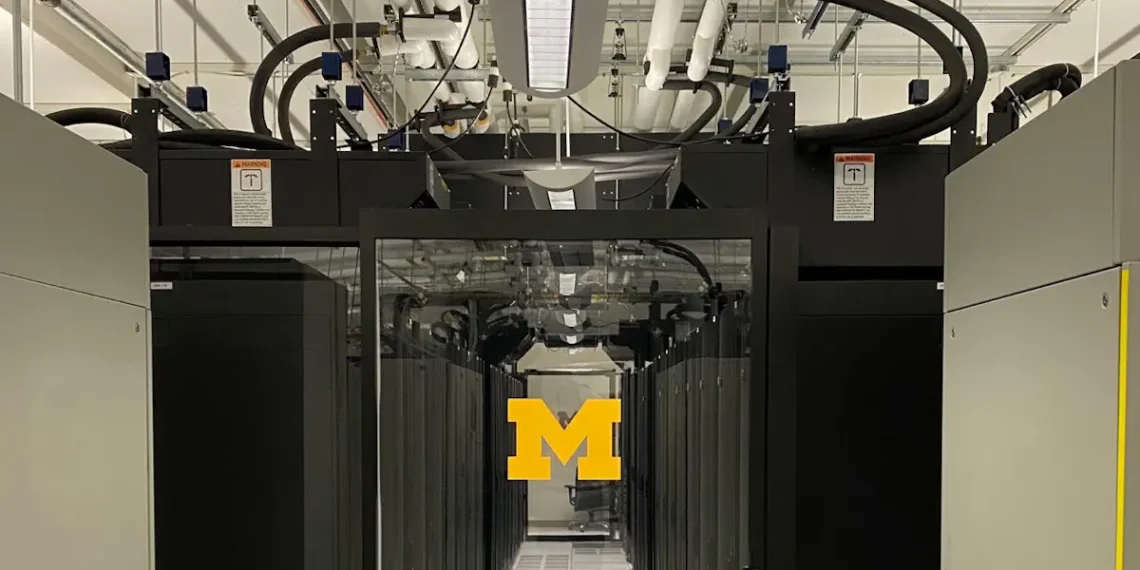

Légende illustration : Le Michigan Academic Computing Center (MACC) est un centre de données de 2 MW exploité par l’Université du Michigan. Il stocke des données provenant de différents départements et des calculs de haute performance pour la recherche sur l’intelligence artificielle. Crédit photo : Jae-Won Chung, SymbioticLab, Université du Michigan

Article : « Reducing Energy Bloat in Large Model Training » – abs/2312.06902

Source : Université du Michigan – Traduction Enerzine.com