Environ un tiers de l’électricité consommée par les grands centres de traitement de données est employé à refroidir les serveurs, et ce volume devrait augmenter au même rythme que la puissance des processeurs et la popularité des services du Cloud. Ce phénomène a été baptisé par certains "loi de Moore des centres de traitement de données", la croissance des besoins en refroidissement étant parallèle à la croissance de la puissance des processeurs, qui double tous les 18 mois.

Ce constat a amené des chercheurs du Georgia Institute of Technology à optimiser les stratégies de refroidissement et à développer de nouveaux modèles de transferts de chaleur permettant de concevoir des équipements plus efficaces. Expérimentant leurs travaux sur leur centre de traitement de données de 100 mètres carrés, les chercheurs espèrent réduire le pourcentage d’électricité dédié au refroidissement des serveurs de 15%.

La plupart des centres de traitement de données reposent sur de grandes unités d’air conditionné pour souffler de l’air frais dans les armoires de serveurs et les équipements traditionnels sont surélevés pour permettre à l’air de circuler sous les machines. "L’agencement des éléments de calcul est d’une grande importance vis-à-vis de la puissance de refroidissement requise" affirme Yogendra Joshi (cf photo haut), un des membres de l’équipe de recherche. "Nous explorons donc des moyens de réarranger les pièces entre elles pour permettre une meilleure circulation de l’air et une meilleure efficacité énergétique."

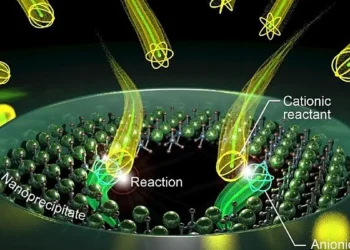

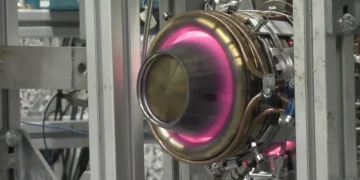

Les centres de traitement de données devront probablement bientôt remplacer l’air frais par des liquides de refroidissement pour les machines les plus puissantes afin d’assurer une consommation raisonnable, mais cela introduira un nouveau niveau de complexité qui ne sera pas forcément adéquat pour tous les besoins.

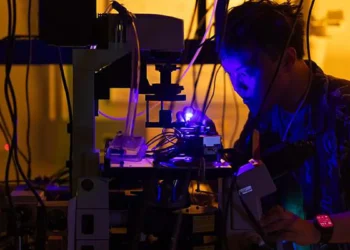

Afin de mesurer l’efficacité de leurs solutions, le professeur Joshi et son équipe utilisent des générateurs de fumée et des lasers pour visualiser les mouvements d’air, des capteurs infrarouges pour quantifier la chaleur, des anémomètres pour mesurer les vitesses de sortie des ventilateurs et des thermomètres sophistiqués pour relever la température des cartes mères. Leurs chercheurs étudient également l’impact des pannes des systèmes de refroidissement, des méthodes de répartition des tâches de calcul en fonction de la température des processeurs et l’exploitation de la chaleur générée par les centres de traitement de données.

BE Etats-Unis numéro 169 (12/06/2009) – Ambassade de France aux Etats-Unis / ADIT – http://www.bulletins-electroniques.com/actualites/59496.htm

Cette article est incorrect: Le ration puissance/croissance ne grandit plus depuis longtemps. Pour preuvre les derniers processeurs Core 2 Duo chauffe beaucoup moins que les pentium 4 d’il y a 4 ou 5 ans. Ce qui croit par contre c’est la taille de ces centres de serveurs et leur importance. Enfin, utiliser un refroidissement liquide pour des centre de donnees n’a rien de nouveau: Microsoft installe des contenaires remplis de serveurs refroidis a l’eau comme base de ses services de « cloud computing » depuis un bon moment deja.