Les infrastructures d’intelligence artificielle montent en puissance à un rythme tel que la facture énergétique des centres de données devient un sujet stratégique pour l’industrie numérique. Face à cette pression, Dell Technologies et Lenovo ont annoncé une série de solutions destinées à mieux maîtriser la consommation électrique et la dissipation de chaleur des serveurs.

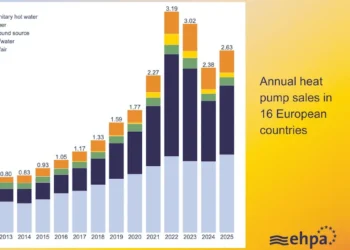

Le cœur de ces annonces porte autant sur le refroidissement des équipements que sur l’optimisation du coût de l’inférence de modèles d’IA, depuis le datacenter jusqu’aux stations de travail mobiles. Selon les informations fournies par Dell Technologies et Lenovo, ces innovations visent directement les entreprises qui cherchent à déployer des charges de travail d’IA intensives sans voir exploser leurs coûts d’exploitation. L’enjeu dépasse la seule performance brute : il s’agit de rendre soutenable une croissance de la demande énergétique qui, aux États‑Unis, a déjà porté la consommation des centres de données à environ 4% de l’électricité totale en 2024, avec une augmentation attendue de plus du double d’ici 2030.

Refroidir l’IA sans gonfler la consommation

L’augmentation continue de la puissance thermique des puces, passée d’environ 700 watts à plus de 1 000 watts par composant, oblige les acteurs du secteur à s’éloigner du refroidissement à air traditionnel. Dell Technologies met en avant un nouvel échangeur de chaleur arrière, l’échangeur thermique à porte arrière fermée PowerCool (eRDHx), conçu comme un système fermé capable de capter la totalité de la chaleur produite par les baies informatiques. Ce dispositif fonctionne avec une eau circulant à des températures comprises entre 32 et 36 degrés Celsius, ce qui permet de s’affranchir de groupes froids énergivores et de réduire fortement l’énergie nécessaire au refroidissement.

Selon Dell, l’association entre ce système et les baies IR7000 permet de diminuer les coûts de refroidissement pouvant atteindre jusqu’à 60% par rapport à des solutions classiques, tout en maintenant, voire en augmentant, la densité de calcul. Les entreprises peuvent en pratique installer davantage de racks fortement chargés en serveurs – jusqu’à environ 16% de baies supplémentaires – sans hausse de la consommation électrique globale dédiée à la climatisation. Cette approche illustre une évolution où la maîtrise de la thermique devient un levier d’augmentation de la capacité informatique, et non seulement un poste de dépense incompressible.

Lenovo généralise le refroidissement liquide

Lenovo capitalise, de son côté, sur la technologie de refroidissement liquide Neptune, désormais étendue à l’ensemble de son portefeuille pour centres de données. L’équipementier indique que les serveurs équipés de Neptune peuvent fonctionner avec une consommation d’énergie environ 40% inférieure à celle de systèmes refroidis par air, à puissance de calcul comparable. Cette orientation lui a permis de s’installer en tête des classements Top500 et Green500 de novembre 2025, qui évaluent respectivement la performance des supercalculateurs et leur efficacité énergétique.

Parmi les systèmes mis en avant figure le ThinkSystem SR780a, qui atteint un indice d’efficacité énergétique (PUE) de 1,1. Concrètement, pour chaque watt consacré au calcul, seulement 0,1 watt est consacré au refroidissement, ce qui illustre la marge de progression par rapport à des architectures plus anciennes. Combinée à une montée en puissance annoncée de l’adoption du refroidissement liquide dans les racks attendue autour de 47% d’ici 2026 cette stratégie place Lenovo parmi les acteurs qui anticipent une généralisation de ces technologies bien au‑delà du périmètre traditionnel des supercalculateurs de recherche.

Coûts et performances de l’inférence sur site

La bataille ne se joue pas uniquement dans les salles informatiques, mais aussi à la périphérie, là où se décident les arbitrages entre calcul local et cloud public. Dell a ainsi présenté une station de travail mobile, le Pro Max Plus, dotée d’un processeur neuronal (NPU) discret de niveau entreprise, reposant sur la carte d’inférence Qualcomm AI 100 PC. Cette configuration intègre 64 Go de mémoire dédiée à l’IA et peut exécuter localement des modèles de très grande taille, jusqu’à environ 120 milliards de paramètres, sans nécessairement recourir à un service distant.

Sur le segment des serveurs, Dell met également en avant les PowerEdge XE9785 et XE9785L, prévus pour le second semestre 2025, qui doivent prendre en charge les GPU AMD Instinct série MI350. Chaque GPU embarque 288 Go de mémoire HBM3E et vise des gains de performance d’inférence pouvant atteindre un facteur de 35 par rapport aux générations antérieures. Proposées en versions refroidies par air ou par liquide, ces plates‑formes s’intègrent dans une approche baptisée AI Factory, qui, selon Dell, peut rendre l’inférence de grands modèles de langage jusqu’à 62% plus économique sur site que via des services de cloud public, pour certains scénarios d’usage.

Une course à la puissance sous contrainte énergétique

Ces annonces arrivent dans une période où la montée en puissance de l’IA générative exerce une pression inédite sur les infrastructures électriques, au moment même où la puissance par puce continue de croître. La perspective d’un doublement, voire davantage, de la consommation énergétique des centres de données d’ici la fin de la décennie oblige les entreprises à arbitrer entre déploiement massif de capacités de calcul et maîtrise des coûts, sans oublier l’empreinte environnementale. En combinant refroidissement liquide, optimisation de la densité de calcul et déplacement d’une partie de l’inférence vers des ressources locales, Dell Technologies et Lenovo cherchent à rendre cette équation plus soutenable.

Si les prévisions d’adoption du refroidissement liquide et la généralisation de plates‑formes spécialisées se confirment, l’industrie pourrait retarder, sans l’éviter complètement, le moment où la contrainte énergétique deviendra un frein direct à la course à la puissance. Les prochaines années diront si ces innovations suffisent à contenir la croissance de la demande ou si elles ne font qu’accompagner un mouvement de fond qui, à terme, imposera des choix plus radicaux dans la façon de concevoir et d’exploiter les infrastructures d’IA. Les informations de cet article sont issues des présentations et communications de Dell Technologies et Lenovo sur leurs innovations d’infrastructure d’IA.

Source : Lenovo / Dell