On estime qu’un modèle d’IA peut nécessiter plus de 6 000 joules d’énergie pour générer une seule réponse textuelle. En comparaison, votre cerveau n’a besoin que de 20 joules par seconde pour vous maintenir en vie et vous permettre de fonctionner cognitivement. C’est pourquoi les chercheurs de l’Université de Buffalo s’inspirent du cerveau humain pour développer une architecture informatique capable de répondre aux besoins énergétiques croissants de l’intelligence artificielle.

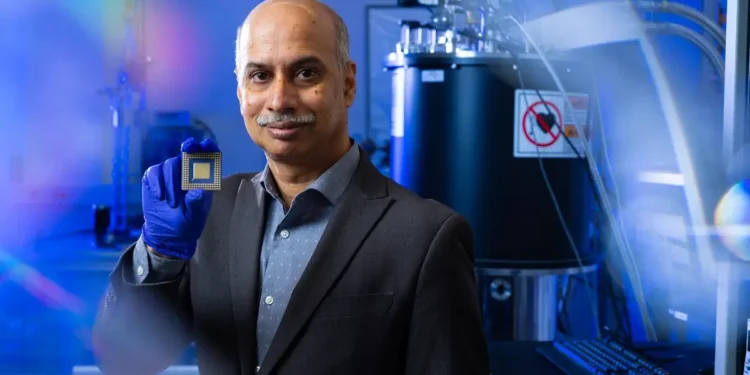

« Il n’y a rien au monde qui soit aussi efficace que notre cerveau : il a évolué pour maximiser le stockage et le traitement de l’information et minimiser la consommation d’énergie », affirme Sambandamurthy Ganapathy, docteur, professeur au département de physique de l’UB et doyen associé chargé de la recherche à la faculté des arts et des sciences de l’UB. « Bien que le cerveau soit beaucoup trop complexe pour être réellement recréé, nous pouvons imiter la façon dont il stocke et traite les informations afin de créer des ordinateurs plus économes en énergie, et donc une IA plus économe en énergie. »

Cette approche inspirée du cerveau est connue sous le nom d’informatique neuromorphique. Ses origines remontent aux années 1980, mais elle a pris de l’importance ces dernières années, les tâches informatiques étant devenues plus gourmandes en énergie et plus complexes, en particulier celles qui nécessitent l’IA.

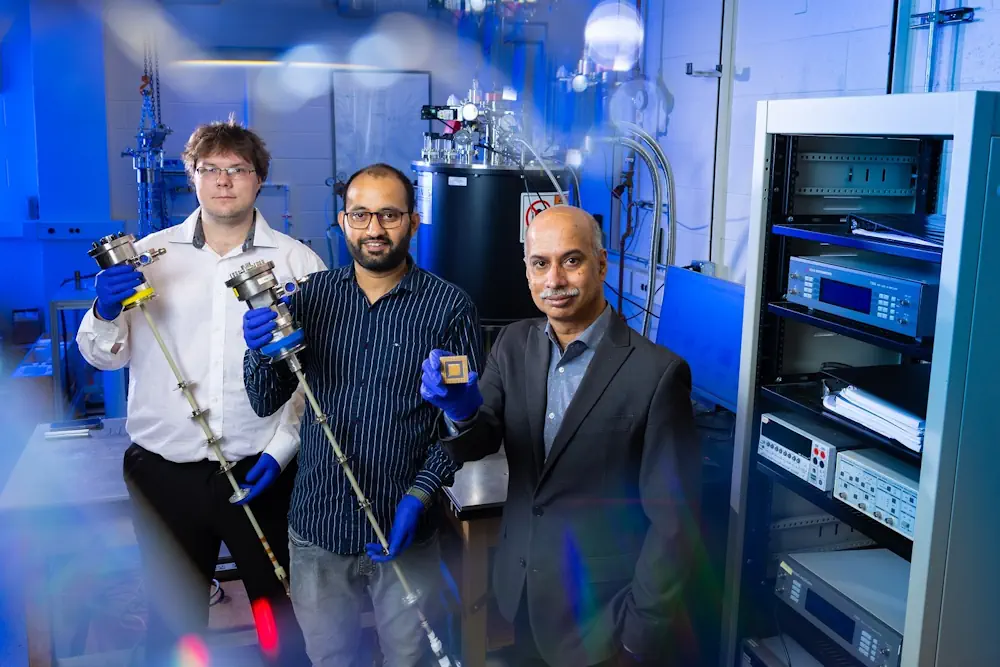

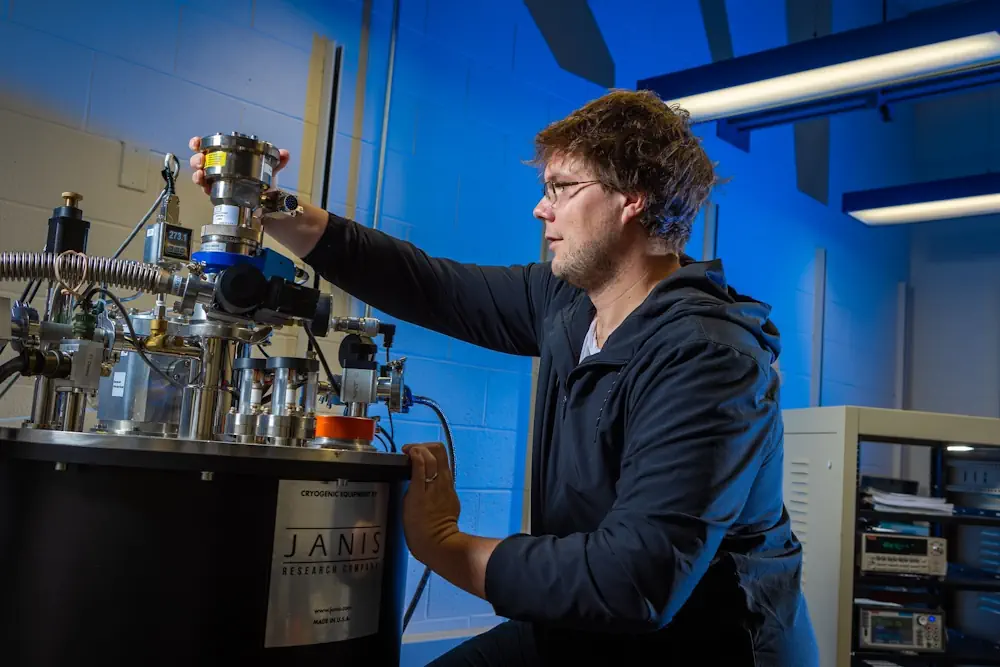

Si l’informatique neuromorphique peut concerner à la fois le matériel et les logiciels inspirés du cerveau, l’équipe de M. Ganapathy se concentre sur le matériel. Leurs recherches, financées par la National Science Foundation, sont un mélange de science quantique et d’ingénierie qui consiste à étudier les propriétés électriques uniques des matériaux pouvant être utilisés pour construire des puces informatiques neuromorphiques.

L’objectif de l’équipe est de développer à terme des puces et des appareils qui soient non seulement plus économes en énergie, mais aussi plus performants dans l’exécution des tâches, voire plus proches de l’humain.

« Les ordinateurs actuels ont été conçus pour effectuer des tâches simples et répétitives, mais avec l’essor de l’IA, nous ne voulons plus nous contenter de résoudre des problèmes simples », précise Ganapathy. « Nous voulons que les ordinateurs résolvent des problèmes complexes, comme le font les êtres humains au quotidien. L’informatique neuromorphique pourrait fournir la structure permettant aux ordinateurs d’y parvenir. »

Les ordinateurs présentent déjà des similitudes avec le cerveau

Un ordinateur qui imite le cerveau humain n’est pas aussi révolutionnaire qu’on pourrait le croire.

Les ordinateurs encodent toutes leurs informations en binaire (des uns et des zéros) à l’aide de milliards de transistors, de minuscules commutateurs qui conduisent l’électricité (un) ou la bloquent (zéro). Notre cerveau encode les informations d’une manière étonnamment similaire. Au lieu de transistors, nous avons des milliards de neurones qui émettent des signaux électriques ou restent silencieux.

« L’informatique neuromorphique vise simplement à dépasser le cadre binaire et à se rapprocher du système beaucoup plus complexe que nous offre la nature », indique Nitin Kumar, étudiant diplômé du laboratoire de Ganapathy.

Mémoire et traitement au même endroit

L’une des raisons pour lesquelles le cerveau est plus complexe – et plus économe en énergie – qu’un ordinateur est que les informations sont stockées et traitées au même endroit.

« Ce n’est pas comme si le côté gauche du cerveau contenait tous les souvenirs et que le côté droit était le siège de tout l’apprentissage », affirme Ganapathy. « Les deux sont étroitement liés. »

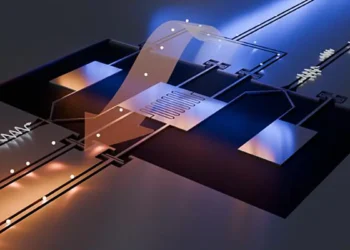

Dans les ordinateurs traditionnels, le stockage et le traitement des informations sont séparés, ce qui entraîne une consommation d’énergie importante pour le simple transport des données le long de minuscules circuits entre l’unité de mémoire et l’unité de traitement. Cette consommation peut être encore plus importante lorsque l’architecture informatique prend en charge un modèle d’IA.

« La question est alors de savoir à quel point nous pouvons rapprocher la mémoire et le traitement au sein d’une puce informatique », explique Ganapathy. « C’est ce qu’on appelle le calcul en mémoire, et c’est l’un des principaux avantages du calcul neuromorphique. »

Neurones et synapses artificiels

La mémoire et le traitement sont étroitement liés dans le cerveau grâce à un système complexe de neurones.

Les neurones s’envoient des signaux électriques les uns aux autres par l’intermédiaire des synapses qui les relient, transportant ainsi efficacement les informations à travers un vaste réseau. En terminologie informatique, les synapses stockent la mémoire et les neurones effectuent le traitement.

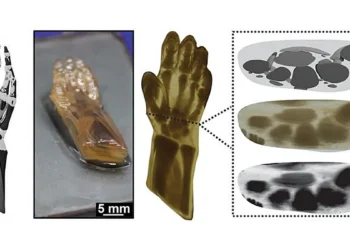

L’équipe de Ganapathy développe donc des neurones et des synapses artificiels conçus pour imiter la transmission électrique des informations par leurs homologues biologiques.

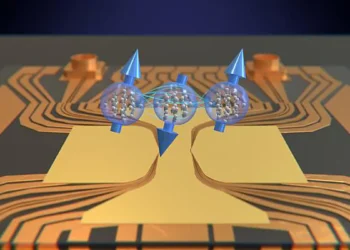

« Nous voulons essentiellement recréer ces oscillations électriques rythmiques et synchronisées que l’on peut observer sur un scanner cérébral », commente Kumar. « Pour ce faire, nous devons créer nos neurones et nos synapses à partir de matériaux avancés dont la conductivité électrique peut être activée et désactivée avec précision. »

Trouver les bons matériaux

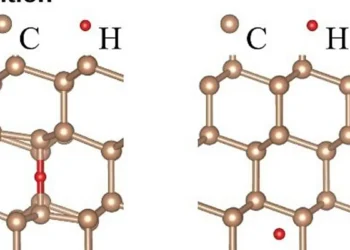

Les matériaux avancés qui répondent à ces critères sont appelés matériaux à changement de phase (PCM).

Les PCM peuvent passer de leur phase conductrice à leur phase résistive et inversement lorsqu’ils sont soumis à des impulsions électriques contrôlées, ce qui permet aux scientifiques de synchroniser leurs oscillations électriques.

Les PCM peuvent également conserver leur phase conductrice ou résistive même après la fin de l’impulsion électrique appliquée. En d’autres termes, ils conservent essentiellement la mémoire de leurs phases précédentes.

« Cela permet à leur niveau de conductivité de changer progressivement en réponse à des impulsions électriques répétées, de la même manière qu’une synapse biologique est renforcée par des activations répétées », explique M. Ganapathy.

Parmi les PCM sur lesquels l’équipe a récemment publié des études, on trouve le bronze d’oxyde de cuivre et de vanadium, l’oxyde de niobium et d’autres composés connus sous le nom de structures métallo-organiques.

« Nos expériences utilisent la tension ainsi que la température pour modifier la conductivité des matériaux. Nous examinons ensuite cet effet jusqu’au niveau des électrons des matériaux », précise M. Kumar. « Afin d’intégrer ces matériaux dans des puces neuromorphiques en tant que neurones et synapses artificiels, nous devons les comprendre à l’échelle atomique. C’est pourquoi nous travaillons actuellement avec leurs collaborateurs pour parvenir à un contrôle au niveau atomique des structures des matériaux, ce qui permettra un réglage précis des propriétés de commutation électrique. »

« Notre prochain objectif », ajoute Ganapathy, « est de synchroniser les oscillations de plusieurs dispositifs afin de construire un réseau neuronal oscillatoire capable d’émuler des fonctions cérébrales complexes telles que la reconnaissance de formes, le contrôle moteur et d’autres comportements rythmiques. »

Des ordinateurs plus humains ?

Ganapathy souligne que les ordinateurs neuromorphiques imitent le cerveau à un niveau purement phénoménologique. L’informatique neuromorphique vise à recréer les comportements fonctionnels et les avantages du cerveau, et non la conscience.

Cependant, il est possible que les ordinateurs neuromorphiques résolvent les problèmes moins comme des ordinateurs que comme des êtres humains.

Les ordinateurs actuels suivent une logique linéaire : une même entrée donnera toujours la même sortie. Le cerveau humain est profondément non linéaire : présentez la même situation à une personne 10 fois et elle pourra y répondre de 10 façons différentes.

Les ordinateurs actuels ne sont pas non plus très performants avec des données limitées ou mal définies. Par exemple, si vous donnez une instruction vague à une IA, il est peu probable qu’elle vous donne la sortie que vous recherchez. Les humains, en revanche, réagissent souvent bien à des informations limitées, voire confuses.

« Il est donc possible qu’en dotant un ordinateur d’une architecture plus complexe, comme celle du cerveau humain, on lui permette de traiter les informations de manière plus non linéaire et de mieux s’adapter à des données limitées », déclare M. Ganapathy.

Les chercheurs pensent que cela pourrait être particulièrement utile dans des applications telles que les voitures autonomes, où l’IA fonctionne bien dans la plupart des situations routières, mais reste moins performante que les humains lorsqu’il s’agit de scénarios plus complexes sans solution facile ; pensez à un cerf qui saute devant votre voiture alors que quelqu’un vous suit de près.

En fait, les voitures autonomes pourraient être l’une des meilleures applications pour les puces neuromorphiques, étant donné que les décisions en temps réel sont prises sur l’appareil lui-même, et non à des milliers de kilomètres de là, sur un serveur distant.

« Les puces neuromorphiques ne seront peut-être pas disponibles dans votre smartphone de sitôt, mais je pense que nous les verrons dans des applications très spécifiques, comme les voitures autonomes. Peut-être même une puce pour réagir à la route et une autre pour trouver le meilleur itinéraire possible », conclut M. Ganapathy. « Il n’y aura probablement pas un seul grand ordinateur neuromorphique qui résoudra tous les problèmes. Au contraire, vous verrez de nombreuses puces neuromorphiques différentes qui résoudront chacune un problème. »

Source : U. Buffalo