L’adoption de l’intelligence artificielle dans les entreprises ne se limite pas à l’intégration d’un outil supplémentaire aux process existants. Elle modifie profondément la manière dont l’entreprise et les écosystèmes fonctionnent. Pour ces raisons, elle pose de nouveaux dangers qu’il convient d’intégrer à la réflexion, plutôt que de foncer tête baissée uniquement sur des questions d’éthique.

L’intelligence artificielle (IA) est souvent présentée comme une révolution technologique dont l’impact dépasse largement le cadre des entreprises et du marché. Dans le domaine du management, la majorité des chercheurs s’accordent à souligner l’importance d’une utilisation éthique de l’IA : il s’agit d’éviter les biais algorithmiques, de protéger les données personnelles, ou encore de garantir une prise de décision transparente. Toutefois, cette approche occulte une question plus structurelle : la concentration du pouvoir au sein des plateformes d’IA et de leurs possesseurs, ainsi que leur influence croissante sur la dynamique des marchés et des sociétés.

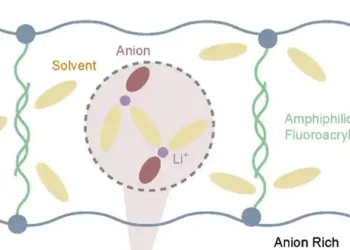

L’essor des plateformes d’IA s’accompagne d’une centralisation progressive du pouvoir informationnel entre les mains de leurs propriétaires. Cette concentration ne se limite pas à une domination technologique, mais soulève des enjeux concurrentiels et oligopolistiques. Ces plateformes ne se contentent pas d’assurer l’accès aux données : elles structurent les flux d’informations, définissent les standards et redéfinissent progressivement les règles du marché. À travers des mécanismes algorithmiques de recommandation, de classification et d’évaluation, elles exercent une domination qui dépasse la simple gestion technique des bases de données et qui influence directement les décisions économiques dans les écosystèmes qui les adoptent.

La confiance comme moteur de domination

L’IA est perçue comme un levier d’optimisation des processus décisionnels et d’amélioration de la performance organisationnelle. Son adoption repose sur la conviction que ses capacités de prédiction et d’analyse renforcent la rationalisation des décisions et l’efficience des systèmes économiques. Cette confiance dans l’IA justifie son intégration dans un nombre croissant d’écosystèmes, où elle redéfinit la relation entre fournisseurs et clients, y compris la « servitisation ».

Ce terme désigne la manière dont les entreprises déplacent leur orientation stratégique vers l’offre de services comme principaux moteurs de croissance, et ce, dans de nombreux secteurs.

Toutefois, cette dynamique d’adoption généralisée comporte plusieurs effets structurants. L’intégration des plateformes d’IA dans la servitisation introduit une standardisation accrue des processus et une homogénéisation des offres de services, réduisant ainsi la flexibilité et la capacité d’adaptation des entreprises. Les manufacturiers, historiquement au centre des écosystèmes de servitisation, se trouvent déplacés vers la périphérie face à la domination croissante des fournisseurs de ces plateformes.

En parallèle, cette dépendance aux infrastructures d’IA renforce la position de contrôle des plateformes. Ce phénomène ne se limite pas à une dépendance technique, mais englobe également des dimensions stratégiques et psychologiques.

L’exemple de la décision unilatérale d’OpenAI en 2023 est assez édifiant. Elle a retiré les anciennes interfaces de programmation d’applications (API), obligeant ainsi les premiers utilisateurs de la plateforme en tant que service (PAAS) à migrer vers des modèles plus récents. Une fois la dépendance établie, la marge de manœuvre pour adopter des alternatives se réduit, et les normes imposées par les plateformes deviennent des standards « naturels ».

Une nouvelle gouvernance invisible ?

L’essor des plateformes d’IA ne se traduit pas uniquement par une domination économique, mais s’accompagne également d’une transformation des modes de gouvernance. Rouvroy et Berns (2013) le conceptualisent avec la « gouvernementalité » algorithmique. Contrairement aux formes traditionnelles de pouvoir qui reposent sur des décisions explicites, le pouvoir algorithmique fonctionne de manière diffuse et normative, en orientant les comportements et en redéfinissant les cadres de référence à l’insu des acteurs.

Les plateformes ne contraignent pas directement les choix des acteurs économiques et sociaux, mais modèlent l’environnement décisionnel à travers l’organisation des informations, la hiérarchisation des priorités et l’imposition de métriques de performance spécifiques. Dans ce cadre, les décisions humaines se trouvent encadrées et influencées par des systèmes algorithmiques qui orientent implicitement les choix perçus comme pertinents ou efficaces. Un peu comme le fait l’application Waze pour orienter vers les chemins les plus courts.

Un problème de transparence et de contestabilité

Dans le domaine hospitalier, un algorithme conçu pour optimiser l’attribution des lits ne se limite pas à répartir efficacement les patients : il redéfinit les critères de priorité, influençant ainsi les décisions médicales sous couvert de rationalisation des ressources.

De la même manière, les écosystèmes de servitisation vont être dirigés par ces algorithmes de recommandation qui ne se contentent pas d’organiser l’information ; ils conditionnent la visibilité de certains contenus et l’occultation d’autres, structurant ainsi les priorités et les stratégies des acteurs.

Ce mode de gouvernance algorithmique pose un problème fondamental de transparence et de contestabilité. Contrairement aux décisions humaines, les décisions algorithmiques s’inscrivent dans des processus opaques et automatisés, rendant leur remise en question plus complexe. L’absence de responsabilité clairement identifiable et la difficulté d’accès aux logiques sous-jacentes des algorithmes limitent la possibilité d’une contre-offre ou d’une régulation efficaces.

Un risque de verrouillage

Comme le décrivent Canboy et Khlif (2025), l’intégration croissante des plateformes d’IA dans les écosystèmes de servitisation soulève des problématiques de dépendance et de verrouillage. Deux types de risques interdépendants émergent : la perturbation des modèles d’affaires traditionnels (effet de verrouillage algorithmique et dépendance aux fournisseurs) et la dépendance opérationnelle accrue (coûts de changement élevés et impossibilité d’adopter d’autres solutions).

Face à ces enjeux, une régulation à l’échelle internationale apparaît nécessaire pour limiter les effets oligopolistiques des plateformes dominantes. Plusieurs pistes d’intervention sont envisageables : démocratisation des données, application des lois antitrust, promotion des standards ouverts (open source) ou encore soutien aux plateformes alternatives. Dans cette perspective, la reconnaissance des données comme un bien partagé, et non comme un actif exclusivement privatisé, s’inscrit dans une logique de développement économique équitable et de démocratisation des savoirs.

Enfin, si ces technologies permettent des gains d’efficience, elles impliquent également une consommation énergétique et matérielle considérable. L’idée selon laquelle l’IA contribuerait automatiquement à une trajectoire de développement durable nécessite une interrogation critique. L’adoption généralisée des plateformes d’IA, sans une réflexion sur leur impact social et environnemental, risque de renforcer des formes de dépendance structurelle et d’accroître les déséquilibres au sein des écosystèmes économiques.

Un effet Frankenstein

Dans le célèbre roman de Mary Shelley (1797-1851), le docteur Frankenstein crée une créature rationnelle qui se veut supérieure à l’humain, mais dont l’existence propre devient rapidement insoutenable. L’IA, comme la créature de Frankenstein, incarne cette quasi-perfection rationnelle qui finit par révéler les failles de son créateur. Conçue pour optimiser, prédire et rationaliser, elle finit par refléter les inégalités, les jeux de pouvoir et les choix de société qui la façonnent. Comme le monstre du roman, elle pose une question centrale à ses créateurs : « Pourquoi m’avez-vous donné vie si c’est pour me laisser semer la destruction ? »

Le problème n’est donc pas tant l’IA elle-même, mais les dynamiques de pouvoir et de contrôle qu’elle maintient et renforce. Plutôt que de nous focaliser uniquement sur ses biais ou ses portées éthiques, nous devrions interroger les intérêts qui la contrôlent, à quelles fins et avec quelles conséquences pour le vivant.

Wafa Khlif, Professeure de contrôle de gestion, TBS Education

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.