À l’ère de l’accélération technologique, les expériences de physique nucléaire, souvent tributaires de longues heures ou journées de traitement informatique, pourraient bientôt basculer dans une ère inédite : celle du temps réel. Des chercheurs des laboratoires nationaux Lawrence Berkeley et Oak Ridge, sous l’égide du Département américain de l’énergie, travaillent activement à un système capable de réduire à quelques secondes la gestion de volumes de données massifs, grâce à une plateforme logicielle innovante baptisée DELERIA.

DELERIA et GRETA : un tandem dédié à la physique nucléaire

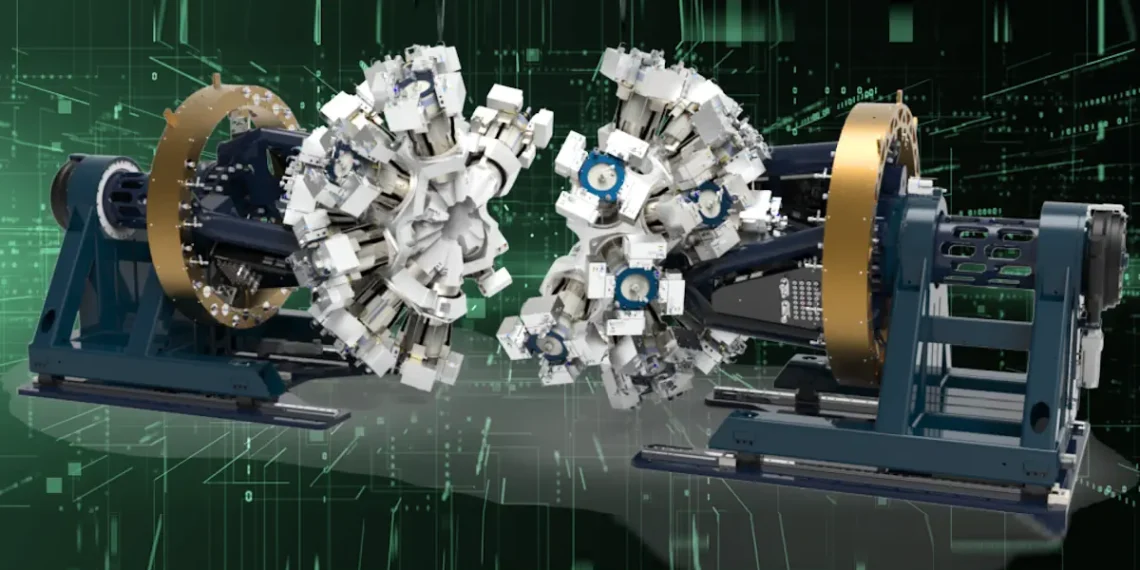

DELERIA, acronyme de Distributed Event-Level Experiment Readout and Integrated Analysis, est conçu pour répondre aux exigences spécifiques du spectromètre GRETA (Gamma Ray Energy Tracking Array). Cet instrument, en cours d’assemblage au Berkeley Lab, sera déployé en 2026 à l’installation de faisceaux d’isotopes rares (FRIB) de l’Université d’État du Michigan. GRETA, constitué de 120 cristaux de germanium ultrapur disposés en sphère, permettra d’analyser les interactions entre photons émis lors de collisions et noyaux atomiques. L’objectif ? Élucider la configuration spatiale et dynamique des protons et neutrons au sein des noyaux, une clé pour comprendre les forces fondamentales régissant la matière.

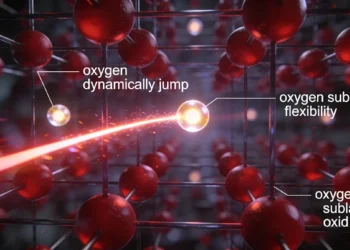

Le défi réside dans la quantité et la complexité des données générées. Chaque collision produit des centaines de milliers de photons par seconde, dont les trajectoires et énergies doivent être recalculées en temps réel. « Notre objectif premier est d’établir un pipeline de données pour les besoins futurs expérimentaux sans avoir à construire une infrastructure informatique locale », indique Gustav Jansen, informaticien spécialisé en physique nucléaire à l’Oak Ridge National Laboratory (ORNL), qui développe DELERIA depuis deux ans. « Le gazoduc nous permettra également d’augmenter la quantité d’analyses réalisées en ligne, tout en montrant que DELERIA peut être adapté à d’autres installations de recherche. »

Un réseau national pour désengorger les serveurs locaux

Le système repose sur une architecture distribuée exploitant les centres informatiques nationaux via le réseau ESnet (Energy Sciences Network). Les données captées par GRETA seront transmises à des clusters comme Defiant, un supercalculateur à base de processeurs graphiques (GPU) AMD composé de 36 nœuds, situé à l’ORNL. Ce dernier traite les informations enregistrées par les capteurs – coordonnées des impacts photoniques, énergies déposées – et renvoie les résultats pour stockage ou analyse complémentaire. Grâce à DELERIA, le volume de données stockées est réduit de 97,5 %, un facteur 40, évitant une saturation des serveurs locaux.

Pour Gustav Jansen, leur approche marque un tournant : « La mise en place d’un pipeline de données nous permet de décharger le calcul lourd vers les centres de données des laboratoires nationaux. Ainsi, au lieu de construire un tout nouveau système informatique pour une mise à niveau potentielle de GRETA, nous pouvons simplement nous connecter à un système existant. »

Des défis techniques et des solutions ingénieuses

Les tests actuels illustrent à la fois les avancées et les obstacles. Un banc d’essai virtuel simule les collisions photoniques à Berkeley, envoyant les données via ESnet6 à plus de 2 000 miles vers l’ORNL. Le système atteint déjà un débit de 35 gigabits par seconde (Gbps), dépassant les capacités prévues de GRETA. Cependant, la latence – délai de transmission dû à la distance – demeure un frein majeur. Si le traitement d’un événement individuel prend 5 millisecondes, le trajet aller-retour des données entre Berkeley et Oak Ridge nécessite 120 millisecondes.

« Bien sûr, ce n’est que dans la science-fiction que l’on peut contourner la vitesse de la lumière », souligne Jansen. Pour pallier ce problème, l’équipe mise sur le parallélisme : traiter simultanément plusieurs événements en cours de transfert, optimisant ainsi l’utilisation du cluster. « En trouvant le bon équilibre, nous pouvons nous assurer que le système reste constamment occupé, évitant un triplement du temps d’analyse. »

Tom Beck, chef de section au National Center for Computational Sciences de l’ORNL, ajoute avec humour : « Seul Gustav peut [contourner la vitesse de la lumière]. » Pour Beck, ce projet incarne un travail pionnier dans le cadre de l’IRI (Integrated Research Infrastructure), une initiative du DOE visant à relier ses installations nationales aux ressources informatiques de pointe. « C’est le premier cas opérationnel à ce niveau de maturité. Plus nous accumulerons de cas d’utilisation, plus les standards seront robustes. »

Vers une révolution silencieuse de la recherche

Au-delà de GRETA, DELERIA pourrait servir de modèle pour d’autres instruments scientifiques, notamment en astrophysique ou en biologie structurale. La possibilité de traiter des données en temps réel permettrait aux équipes de modifier leurs protocoles expérimentaux sur le terrain, d’affiner leurs paramètres en temps réel, et d’accélérer la publication de résultats.

Cette initiative illustre aussi une tendance plus large : la mutualisation des infrastructures informatiques pour répondre à la montée exponentielle des besoins en données. En centralisant les ressources, les laboratoires évitent les doublons coûteux tout en favorisant une approche collaborative.

Légende illustration : En cours de construction au Berkeley Lab, le Gamma-Ray Energy Tracking Array (GRETA) est un instrument de pointe pour la physique nucléaire. Le logiciel développé à l’ORNL permettra au GRETA d’envoyer des données aux superordinateurs les plus rapides du pays pour une analyse immédiate, ce qui réduira radicalement les besoins de stockage des données et permettra d’ajuster l’expérience en temps réel pour obtenir des résultats optimaux. Credit: Jason Smith/ORNL, Berkeley Lab, U.S. Dept of Energy

Source : ORNL