Les applications de suivi de la santé, utilisant uniquement un smartphone, peuvent aider les personnes à gérer des maladies chroniques ou à atteindre leurs objectifs de remise en forme. Ces applications peuvent être lentes et énergivores en raison des vastes modèles d’apprentissage automatique qui les alimentent et qui doivent être transférés entre un smartphone et un serveur de mémoire central.

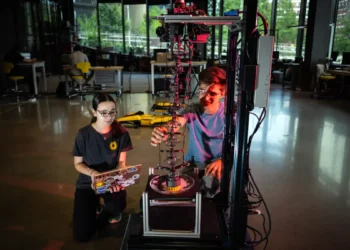

Des chercheurs du MIT et du MIT-IBM Watson AI Lab ont développé un accélérateur d’apprentissage automatique résistant aux deux types d’attaques les plus courants, permettant ainsi de préserver la confidentialité des données sensibles des utilisateurs tout en exécutant efficacement d’énormes modèles d’IA sur les appareils.

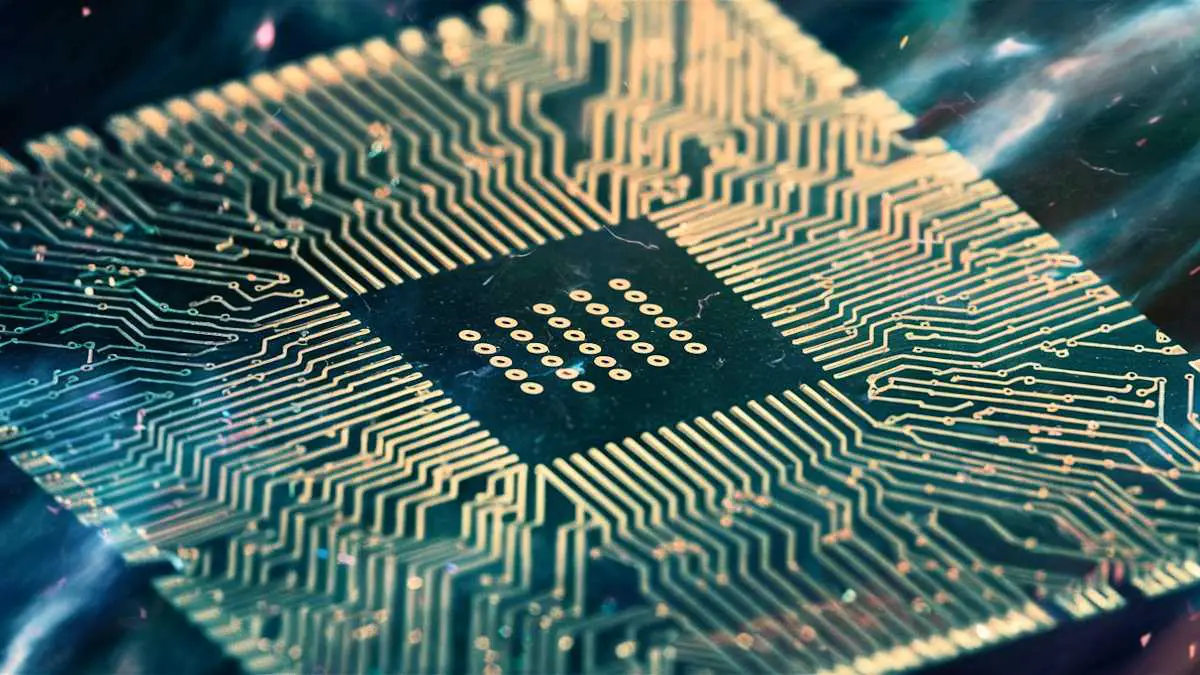

Un accélérateur d’apprentissage automatique sécurisé

Les ingénieurs accélèrent souvent les choses en utilisant du matériel qui réduit la nécessité de déplacer autant de données. Bien que ces accélérateurs d’apprentissage automatique puissent rationaliser le calcul, ils sont vulnérables aux attaquants qui peuvent voler des informations secrètes.

Pour réduire cette vulnérabilité, l’équipe a développé plusieurs optimisations qui permettent une sécurité renforcée tout en ne ralentissant que légèrement l’appareil. De plus, la sécurité ajoutée n’a pas d’impact sur la précision des calculs. Cet accélérateur d’apprentissage automatique pourrait être particulièrement bénéfique pour les applications d’IA exigeantes comme la réalité augmentée et virtuelle ou la conduite autonome.

Équilibrer les compromis lors de la conception

Bien que la mise en œuvre de la puce rende un appareil légèrement plus cher et moins écoénergétique, c’est parfois un prix qui vaut la peine d’être payé pour la sécurité, selon Maitreyi Ashok, auteure principale de l’étude et étudiante diplômée en génie électrique et informatique (EECS) au MIT.

«Il est important de concevoir en ayant la sécurité à l’esprit dès le départ. Si vous essayez d’ajouter ne serait-ce qu’une quantité minimale de sécurité après qu’un système a été conçu, c’est extrêmement coûteux. Nous avons pu équilibrer efficacement bon nombre de ces compromis pendant la phase de conception», explique Maitreyi Ashok.

Une approche à trois volets pour bloquer les attaques

Les chercheurs ont ciblé un type d’accélérateur d’apprentissage automatique appelé calcul numérique en mémoire (IMC). Une puce IMC numérique effectue des calculs à l’intérieur de la mémoire d’un appareil, où des parties d’un modèle d’apprentissage automatique sont stockées après avoir été déplacées depuis un serveur central.

L’équipe a adopté une approche à trois volets pour bloquer les attaques par canal auxiliaire et par sondage de bus. Premièrement, ils ont employé une mesure de sécurité où les données dans l’IMC sont divisées en morceaux aléatoires. Deuxièmement, ils ont empêché les attaques par sondage de bus en utilisant un chiffrement léger qui crypte le modèle stocké dans la mémoire hors puce. Troisièmement, pour améliorer la sécurité, ils ont généré la clé qui déchiffre le chiffrement directement sur la puce, plutôt que de la déplacer avec le modèle.

Tests de sécurité concluants

Pour tester leur puce, les chercheurs ont endossé le rôle de pirates informatiques et ont tenté de voler des informations secrètes en utilisant des attaques par canal auxiliaire et par sondage de bus.

Même après avoir fait des millions de tentatives, ils n’ont pas pu reconstruire de véritables informations ou extraire des parties du modèle ou de l’ensemble de données. Le chiffrement est également resté incassable. En revanche, il a suffi d’environ 5 000 échantillons pour voler des informations sur une puce non protégée.

L’équipe prévoit d’explorer des méthodes qui pourraient réduire la consommation d’énergie et la taille de leur puce à l’avenir, ce qui faciliterait sa mise en œuvre à grande échelle. « À mesure que cela devient trop cher, il devient plus difficile de convaincre quelqu’un que la sécurité est essentielle. Les travaux futurs pourraient explorer ces compromis. Peut-être pourrions-nous rendre la puce un peu moins sécurisée mais plus facile à mettre en œuvre et moins chère», conclut Maitreyi Ashok.

Cette recherche est financée en partie par le MIT-IBM Watson AI Lab, la National Science Foundation et une bourse d’ingénierie Mathworks.