Une nouvelle méthode d’optimisation de la formation des modèles d’apprentissage profond, un outil d’intelligence artificielle en évolution rapide, pourrait réduire la demande énergétique de l’IA (Intelligence Artificielle).

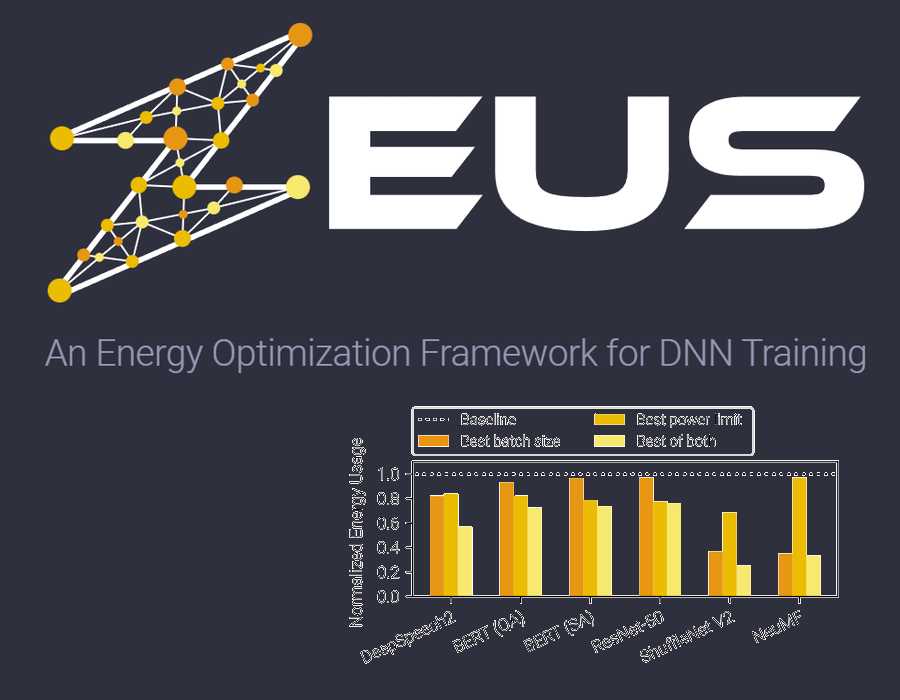

Développé à l’université du Michigan, le cadre d’optimisation open-source étudie les modèles d’apprentissage profond pendant leur formation, en identifiant le meilleur compromis entre la consommation d’énergie et la vitesse de la formation.

« À des échelles extrêmes, l’entraînement du modèle GPT-3 consomme une seule fois 1 287 MWh, ce qui est suffisant pour alimenter un ménage américain moyen pendant 120 ans« , a déclaré Mosharaf Chowdhury, professeur agrégé d’ingénierie électrique et d’informatique.

Grâce à Zeus, le nouveau cadre d’optimisation énergétique mis au point par M. Chowdhury et son équipe, il est possible de réduire ces chiffres de 75 % sans nouveau matériel et avec un impact mineur sur le temps nécessaire à l’apprentissage d’un modèle. Cette étude a été présentée lors du 2023 USENIX Symposium on Networked Systems Design and Implementation (NSDI), à Boston.

Les utilisations courantes des modèles d’apprentissage profond ont explosé au cours des trois dernières années, allant des modèles de génération d’images et des chatbots expressifs aux systèmes de recommandation de TikTok et d’Amazon. Alors que l’informatique en nuage dépasse déjà les émissions de l’aviation commerciale, l’augmentation de la charge climatique due à l’intelligence artificielle est une préoccupation importante.

« Les travaux existants se concentrent principalement sur l’optimisation de la formation à l’apprentissage profond pour une exécution plus rapide, souvent sans tenir compte de l’impact sur l’efficacité énergétique« , a déclaré Jae-Won Chung, doctorant en informatique et en ingénierie et coauteur de l’étude. Nous avons découvert que l’énergie que nous déversons dans les GPU a un rendement décroissant, ce qui nous permet de réduire considérablement la consommation d’énergie, avec un ralentissement relativement faible.

«L’apprentissage profond est une famille de techniques utilisant des réseaux neuronaux artificiels multicouches pour s’attaquer à une série de tâches courantes d’apprentissage automatique. Ces réseaux sont également connus sous le nom de réseaux neuronaux profonds (DNN). Les modèles eux-mêmes sont extrêmement complexes et apprennent à partir de certains des ensembles de données les plus massifs jamais utilisés dans l’apprentissage automatique. Pour cette raison, ils bénéficient grandement des capacités multitâches des unités de traitement graphique (GPU), qui consomment 70 % de l’énergie nécessaire à l’apprentissage d’un de ces modèles.

Zeus utilise deux ponts logiciels pour réduire la consommation d’énergie. Le premier est la limite de puissance du GPU, qui réduit la consommation d’énergie d’un GPU tout en ralentissant l’entraînement du modèle jusqu’à ce que le paramètre soit à nouveau ajusté. L’autre est le paramètre de taille de lot du modèle d’apprentissage profond, qui contrôle le nombre d’échantillons des données d’apprentissage que le modèle traite avant de mettre à jour la façon dont il représente les relations qu’il trouve dans les données. Des tailles de lots plus élevées réduisent le temps de formation, mais avec une consommation d’énergie accrue.

Zeus est capable d’ajuster chacun de ces paramètres en temps réel, en recherchant le point de compromis optimal qui permet de minimiser la consommation d’énergie avec le moins d’impact possible sur le temps de formation. Dans des exemples, l’équipe a pu démontrer visuellement ce point de compromis en montrant toutes les combinaisons possibles de ces deux paramètres. Bien qu’un tel niveau d’exhaustivité ne soit pas possible dans la pratique pour un travail de formation particulier, Zeus tirera parti de la nature répétitive de l’apprentissage automatique pour s’en approcher.

« Heureusement, les entreprises entraînent le même DNN encore et encore sur des données plus récentes, parfois toutes les heures. Nous pouvons apprendre comment le DNN se comporte en observant ces récurrences« , a déclaré Jie You, récemment diplômé d’un doctorat en informatique et ingénierie et coauteur principal de l’étude.

Zeus est le premier cadre conçu pour s’intégrer dans les flux de travail existants pour une variété de tâches d’apprentissage automatique et de GPU, réduisant la consommation d’énergie sans nécessiter de changements au niveau du matériel d’un système ou de l’infrastructure d’un centre de données.

En outre, l’équipe a développé un logiciel complémentaire qu’elle superpose à Zeus afin de réduire davantage l’empreinte carbone. Ce logiciel, appelé Chase, privilégie la vitesse lorsque de l’énergie à faible teneur en carbone est disponible, et choisit l’efficacité au détriment de la vitesse pendant les périodes de pointe, qui sont plus susceptibles de nécessiter une augmentation de la production d’énergie à forte teneur en carbone, telle que le charbon. Chase a remporté la deuxième place lors du hackathon CarbonHack de l’année dernière et sera présenté le 4 mai lors de l’atelier de la conférence internationale sur les représentations d’apprentissage (International Conference on Learning Representations Workshop).

« Il n’est pas toujours possible de migrer facilement les tâches de formation DNN vers d’autres sites en raison de la taille des ensembles de données ou des réglementations en matière de données« , a déclaré Zhenning Yang, étudiante en master d’informatique et d’ingénierie. « Le report des tâches de formation à des périodes plus vertes n’est pas non plus une option, car les DNN doivent être formés avec les données les plus récentes et déployés rapidement en production pour atteindre la plus grande précision.«

« Notre objectif est de concevoir et de mettre en œuvre des solutions qui n’entrent pas en conflit avec ces contraintes réalistes, tout en réduisant l’empreinte carbone de la formation des DNN.«

L’étude a été soutenue en partie par les subventions CNS-1909067 et CNS-2104243 de la National Science Foundation, par VMWare et par la Kwanjeong Educational Foundation, et par les crédits informatiques fournis par CloudLab et Chameleon Cloud.

Ressources :

Zeus : Understanding and Optimizing GPU Energy Consumption of DNN Training

(.PDF) : Study: Chasing Low-Carbon Electricity for Practical and Sustainable DNN Training

Open Source :