Dans un contexte mondial où l’efficacité énergétique est au cœur de tous les débats, les datacenters sont souvent pointés du doigt, car énergivores. Ils représentent environ 4% de la consommation énergétique mondiale, en croissance de près de 5% par an (1).

Pour réduire la facture économique et écologique, les entreprises travaillent, depuis quelques années, à rendre leurs salles informatiques plus économes en énergie, tout en préservant qualité et continuité de service indispensables à la fourniture des services IT.

Continuité de service et efficience énergétique : un paradoxe ?

La taille de l’univers numérique double tous les quatre ans. Les quelques 2,5 milliards de Go de données créés chaque jour doivent être traitées, stockées et restituées à des utilisateurs de plus en plus exigeants vis-à-vis de la qualité de service. Les datacenters, qui hébergent les services IT, doivent donc être conçus et exploités pour réduire au maximum les risques de panne. A cette fin, leurs exploitants ont longtemps privilégié la redondance des équipements techniques, ainsi que la sécurité des installations. Avec pour principal corollaire, un surdimensionnement des systèmes de refroidissement qui représentent, à eux seuls, près de 40% de la facture énergétique globale d’un datacenter (2). Ce surdimensionnement, qui continue à être observé dans la majorité des salles informatiques, entraine une consommation d’électricité bien supérieure aux besoins réels. Si les prix du kWh en France sont en moyenne 25 % plus bas que dans le reste de l’Europe, cet usage n’est pas responsable d’un point de vue écologique.

Maîtrise de la cascade énergétique : la clé des datacenters agiles et responsables

Conscients de ces enjeux économiques et environnementaux, les exploitants de datacenters ont commencé à travailler depuis quelques années sur la question de l’efficience énergétique. Ils cherchent désormais à maîtriser l’intégralité de la « cascade énergétique », c’est-à-dire à réduire les consommations à tous les niveaux : composants informatiques, équipements techniques, aménagement et intégration des salles informatiques dans leur écosystème géographique.

Le premier axe d’optimisation concerne les composants IT. Le développement de matériaux supraconducteurs, notamment pour les processeurs, permet par exemple de mieux répartir la chaleur et de travailler à des températures plus élevées – la température communément admise aujourd’hui en salle par les serveurs se situant à 23-24°C, contre 16°C à la fin des années 1980. D’autre part, dans de très nombreux cas, les serveurs sont utilisés à moins de 50% de leur capacité, tout en consommant presque autant d’énergie qu’un serveur chargé à 100%. Leur meilleur dimensionnement, couplé à l’utilisation de technologies comme la virtualisation, permet d’optimiser leur utilisation et leur rendement. Enfin, il est important que la politique d’achats intègre le poids énergétique des équipements informatiques : les plus anciens doivent être remplacés par des matériels de nouvelle génération, moins énergivores, dissipant moins de chaleur et capables de supporter de plus hautes températures.

Second axe : optimiser les équipements techniques les plus consommateurs, c’est-à-dire ceux qui assurent le refroidissement et l’alimentation électrique du datacenter. Opter par exemple, pour des systèmes de production de froid ou de distribution électrique de nouvelle génération permet à la fois de bénéficier d’un meilleur rendement des équipements et de réduire les consommations et les déperditions d’énergie.

L’architecture du centre informatique constitue le troisième paramètre clé dans la réduction de la consommation d’énergie. Prenons le cas d’un datacenter fonctionnant à 75% de son niveau de charge IT. Son coût d’exploitation est six fois moindre que celui d’une salle informatique dont le taux de charge est de 10%. Le taux de remplissage n’est cependant pas toujours à son plus haut niveau et les besoins d’hébergement évoluent à hausse comme à la baisse. Afin de répondre à cette volatilité, les datacenters sont de plus en plus conçus de façon modulaire, avec des organes indépendants et adaptables mis en production au fur et à mesure de la montée en charge. Pour les datacenters existants, des gains énergétiques et opérationnels importants peuvent être réalisés avec des opérations de réurbanisation des salles, telles que la densification des serveurs au m² (augmentation de la production à surface égale) ou encore le confinement des allées froides et chaudes. A cet égard, le soufflage en vrac est une hérésie, l’air frais n’étant pas directement insufflé vers l’équipement informatique à refroidir. Afin de maximiser l’efficacité des systèmes de refroidissement, il est indispensable de séparer les flux thermiques pour canaliser le froid et le souffler au plus près des équipements en fonction de leur niveau de charge.

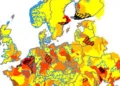

Enfin, dernier élément de la cascade énergétique : l’implantation géographique du datacenter et son intégration dans l’environnement ciblé. Plusieurs paramètres doivent être étudiés, et notamment la température, le degré d’hygrométrie selon les saisons, la pollution atmosphérique. La plupart du temps, les systèmes qui utilisent l’énergie dite gratuite (air, eau) pour refroidir les datacenters permettent de réduire de manière conséquente la facture énergétique. Mais, ils doivent être couplés à des humidificateurs et à des systèmes de filtrage. Il est donc nécessaire lors des phases de conception, de bien évaluer les besoins et contraintes liés à l’exploitation future de la salle, pour faire les choix les plus adaptés.

Demain : encore plus d’actions pour des gains énergétiques substantiels

Le secteur des datacenters traverse aujourd’hui une phase de transition. Transition qui conduit les exploitants à rechercher à la fois maîtrise énergétique, flexibilité et agilité dans l’exploitation de leur salle. L’innovation et l’évolution des technologies ouvrent la voie à de nouveaux gisements d’économie d’énergie.

Du fait de la capacité des matériels à supporter des températures plus importantes, il est désormais envisageable d’utiliser de manière plus systématique des systèmes de refroidissement qui utilisent la température de l’air extérieur (free-cooling, free-chilling…), des nappes souterraines et cours d’eau (géo-cooling). Par ailleurs, le potentiel des solutions de Data Center Infrastructure Management (DCIM) est encore sous-exploité pour monitorer les salles informatiques et détecter les postes énergivores. Les initiatives pour mieux valoriser la chaleur dissipée en la récupérant pour assurer les besoins de chauffage du reste du bâtiment, voire du voisinage immédiat, offrent de belles perspectives. Enfin, les installations de sources d’énergies alternatives (panneaux photovoltaïques…) pour alimenter une partie des équipements du datacenter, se multiplient partout dans le monde, avec des résultats positifs en matière d’efficience énergétique.

En conclusion, de nombreuses solutions éprouvées existent d’ores et déjà pour faire baisser la facture énergétique des datacenters, à tous les niveaux, sans nuire à la continuité de service et sans qu’il soit nécessaire de procéder à des investissements démesurés. Chaque « petite » opération d’optimisation est une pierre à l’édifice écologique et économique. Il s’agit de trouver la bonne combinaison, selon l’existant.

Par Denis Rondeau, ingénieur en optimisation énergétique, APL

(1) Source : RTE – Réseau de Transport Electrique

(2) Source : Gimélec

A propos d’APL

Créé en 1983, APL intervient sur tout le cycle de vie des datacenters. La société compte parmi les leaders en France dans les domaines suivants : conseil en stratégie d’hébergement, conception et réalisation, construction et rénovation, exploitation et optimisation énergétique de centres informatiques. Ses ingénieurs experts interviennent en missions d’audit, d’assistance à maîtrise d’ouvrage, de maîtrise d’œuvre, de transfert de compétences (formations), ou réalisent des projets clé en main. Depuis 2014, APL propose également une offre de financement adaptée aux projets de construction, rénovation et/ou à l’évolution des salles informatiques.

Depuis sa création, APL a mené plus de 1900 projets ou réalisations auprès de sociétés telles que Data IV, Orange, Groupama, Groupe Crédit Agricole, Groupe Casino, Macif, Metro, Sigma ou encore Vinci.

Afin de favoriser le partage d’expérience autour de son domaine d’expertise, APL est membre du Gimélec, CRIP, CLUSIF, de l’ADIRA, AGIT (Alliance Green IT), ATEE ou encore de l’EUDCA. APL participe également activement au Code of Conduct, un groupe de travail piloté par la commission européenne qui soutient les meilleures pratiques relatives à l’efficience énergétique des datacenters. APL est également est accréditée Tier Designer par Uptime Institute depuis décembre 2014.

www.apl-datacenter.fr

je doute de votre chiffre de 4% de la consommation énergétique mondiale, ce ne serait pas plutôt 4% de l’électricité? Avez vous des sources? Autre erreur manifeste: qu’est-ce que les supraconducteurs viennent faire là dedans? Les supraconducteurs les plus « chauds » connus sont dans les 135K, donc ça m’étonnerait qu’on utilise ça à 25°C…

Il n’y a pas que les data centres qui ‘bouffe’ du jus dans notre monde hyper connecté…il y a aussi tous les appareils ‘end users’ (tous ces ‘écrans’ )à ajouter dans l’addition. Pour ce faire une idée: trimtab

Je trouve que l’idée de mettre les serveurs hors des datacenters est à creuser. C’est ce que fait la société Qarnot Computing par exemple (500W 600GFlops). Le seul défaut, c’est que l’été le serveur ne tourne pas. Je pense qu’il y a une bonne piste pour le chauffage collectif/industriel avec rejet de l’air chaud l’été. Dans le nord on chauffe d’octobre à mai (voire début juin certaines années). Si un hébergeur propose la gratuité du chauffage à une grande surface contre son hébergement, je crois connaitre la réponse. La connectivité réseau ne pose pas de problèmes avec la fibre et la confidentialité se traite facilement. Quelques rack de blades à 10kW chacun et le centre commercial du coin sera chauffé. Juste du bon sens.

Mieux encore que les radiateurs de Qarnot, les chauffe-eau de Defab (start-up également) permettent de récupérer la chaleur dégagée par des calculateurs décentralisés quelle que soit la saison. L’eau ainsi chauffée peut servir à des collectivités, bureaux, piscines, etc. Techniquement, cette solution est également plus fiable, puisque grâce à l’utilisation de pompes à chaleur intégrées, les processeurs et autres équipements ne sont pas soumis aux températures élevées générées dans les systèmes Qarnot. On peut arguer que les deux systèmes sont complémentaires, mais je parierais plutôt sur Defab.

Defab fournit le chauffe eau thermodynamique ou paye juste l’electricité? (pas super explicite sur leur site web). Si le chauffe eau est inclu dans l’offre et pas trop encombrant, je passe chez eux pour voir le produit et le prendre (si pas trop bruyant). Cela fait un moment que je trouve stupide d’utiliser un grille pain pour chauffer le ballon d’eau chaude. Belle innovation!

L’utilisation des serveurs comme moyen de chauffage pose le probleme suivant: Quand on a pas besoin du chauffage, on fait quoi? Certes ce type de fonctionnement est possible mais il restera à la marge. Ne pas perdre de vue que ces materiels coute cher et qu’il est souvent necessaire de les exploiter toute l’année 24/24 pour les rentabiliser. L’article (pas mal, aux mélanges prés) décrit les pistes les plus abordables: Virer le système de clim en refroidissant à température ambiante et agir sur une flexibilité de la puissance de calcul mieux adaptée au besoin.)

« Le reste doit pouvoir fonctionner à 80c. » Oui, mais pas sans inconvenients, car les puces trés denses chauffent beaucoup et necessitent un gradiant de température important pour évacuer la chaleur. Si vous augmentez la température de refroidissement, vous limitez l’extraction de puissance possible. Techniquement c’est bien sur faisable, mais ça rends les puces moins performantes et donc au final augmente les couts. « A mon avis avec 400Wc on a pas un serveur qui casse la baraque et il y a toujours le cout de la liaison fibre optique mensuelle. » Tout a fait. Dans la configuration actuelle les alims de « bladecenter » font courrament entre 1000 et 3000W. Et il y en a plusieurs en //. (Je bosse pas dans ce milieu, mais j’en ai un chez moi de 6X2KW, et c’est tout petit!) Je ne pense pas qu’un chauffe eau de particulier soit adapté, entre autres pour les raisons que vous invoquez et celles que j’ai donné plus haut. Par contre ce qui est sur, c’est qu’il doit y avoir des cas industriels ou ça pourrait avoir un interêt (désallement d’eau de mer, séchage de bois, …) . Faudrait déja commencer par là. Des cas concrêts apparaitront certainement. Mais chez le particulier, faudrait une révolution dans les modes de fonctionnement…. Cdlt,