L’intelligence artificielle (IA) offre des performances impressionnantes, mais elle génère également une demande énergétique considérable. Deux chercheurs de l’Institut Max Planck pour la Science de la Lumière en Allemagne proposent une méthode pour entraîner l’IA de manière beaucoup plus efficace, en s’appuyant sur des processus physiques plutôt que sur les réseaux de neurones artificiels numériques actuellement utilisés.

La quantité d’énergie nécessaire pour former GPT-3, qui fait de ChatGPT un Chatbot éloquent et apparemment bien informé, n’a pas été révélée par Open AI, l’entreprise à l’origine de cette intelligence artificielle (IA). Selon la société allemande de statistiques Statista, cela nécessiterait 1 000 mégawattheures, soit l’équivalent de la consommation annuelle de 200 ménages allemands de trois personnes ou plus.

Si cette dépense d’énergie a permis à GPT-3 d’apprendre si le mot « deep » est plus susceptible d’être suivi du mot « sea » ou « learning » dans ses ensembles de données, il n’a pas compris le sens sous-jacent de ces expressions.

Les réseaux neuronaux sur les ordinateurs neuromorphiques

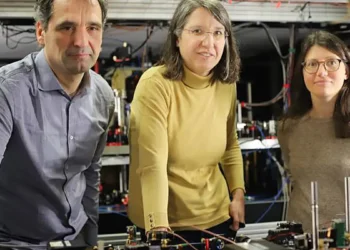

Les chercheurs Víctor López-Pastor et Florian Marquardt explorent le concept de calcul neuromorphique pour réduire la consommation d’énergie des ordinateurs et des applications d’IA.

Contrairement aux réseaux neuronaux artificiels qui fonctionnent sur des ordinateurs numériques conventionnels, le calcul neuromorphique utilise des systèmes qui traitent les données de manière parallèle et non séquentielle, à l’instar du cerveau humain.

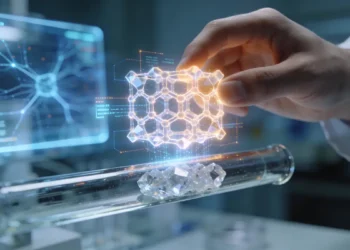

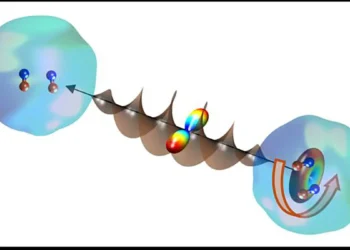

Les circuits photoniques, qui utilisent la lumière plutôt que les électrons pour effectuer des calculs, sont considérés comme des candidats potentiels pour les ordinateurs neuromorphiques. Leurs composants servent à la fois de commutateurs et de cellules mémoire.

Une machine physique auto-apprenante qui optimise ses synapses

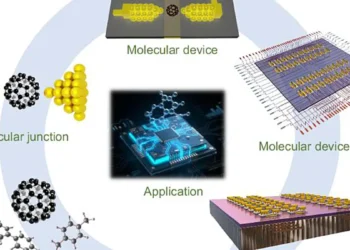

López-Pastor et Marquardt ont conçu une méthode d’entraînement efficace pour les ordinateurs neuromorphiques, basée sur le concept d’une machine physique auto-apprenante. L’idée centrale est de réaliser l’entraînement sous la forme d’un processus physique, dans lequel les paramètres de la machine sont optimisés par le processus lui-même, sans nécessiter de rétroaction externe.

La mise en œuvre et l’entraînement d’une IA sur une machine physique auto-apprenante permettraient non seulement d’économiser de l’énergie, mais aussi du temps de calcul. Pour que cela fonctionne, le processus physique doit être réversible et non linéaire, c’est-à-dire suffisamment complexe.

Test pratique dans un ordinateur neuromorphique optique

Des exemples de processus réversibles et non linéaires peuvent être trouvés dans l’optique. Les deux chercheurs collaborent déjà avec une équipe expérimentale pour développer un ordinateur neuromorphique optique qui traite les informations sous forme d’ondes lumineuses superposées.

« Nous espérons pouvoir présenter la première machine physique auto-apprenante dans trois ans« , ajoute Florian Marquardt. D’ici là, il devrait y avoir des réseaux neuronaux qui pensent avec beaucoup plus de synapses et qui sont formés avec des quantités de données beaucoup plus importantes que celles d’aujourd’hui.

Par conséquent, le désir de mettre en œuvre des réseaux neuronaux en dehors des ordinateurs numériques conventionnels et de les remplacer par des ordinateurs neuromorphiques efficacement entraînés sera probablement encore plus grand.

« Nous sommes donc convaincus que les machines physiques auto-apprenantes ont de fortes chances d’être utilisées dans le développement futur de l’intelligence artificielle« , conclut le physicien.

En synthèse

Les chercheurs du Max Planck proposent une méthode innovante pour entraîner l’IA de manière plus efficace et économe en énergie. Leur approche, basée sur le calcul neuromorphique et les machines physiques auto-apprenantes, pourrait contribuer au développement futur de l’intelligence artificielle.

Pour une meilleure compréhension

Qu’est-ce que le calcul neuromorphique ?

Le calcul neuromorphique est un concept de traitement de données qui s’inspire du fonctionnement du cerveau humain. Il vise à créer des ordinateurs qui traitent les données de manière parallèle et non séquentielle, avec des composants qui servent à la fois de commutateurs et de cellules mémoire.

Quelle est la différence entre les réseaux neuronaux et le calcul neuromorphique ?

Les réseaux neuronaux artificiels fonctionnent sur des ordinateurs numériques conventionnels, où le logiciel est modélisé sur le fonctionnement du cerveau, mais le matériel est constitué d’ordinateurs numériques. Le calcul neuromorphique, en revanche, utilise des systèmes qui traitent les données de manière parallèle et non séquentielle, comme le cerveau humain.

Qu’est-ce qu’une machine physique auto-apprenante ?

Une machine physique auto-apprenante est un concept développé par López-Pastor et Marquardt pour entraîner efficacement les ordinateurs neuromorphiques. Il s’agit d’une machine dont les paramètres sont optimisés par un processus physique, sans nécessiter de rétroaction externe.

Quels sont les avantages des machines physiques auto-apprenantes ?

Les machines physiques auto-apprenantes permettent d’économiser de l’énergie et du temps de calcul lors de l’entraînement d’une IA. Elles rendent également l’entraînement plus efficace en éliminant le besoin de rétroaction externe pour ajuster les forces des connexions synaptiques.

Quand peut-on s’attendre à voir la première machine physique auto-apprenante ?

Les chercheurs espèrent présenter la première machine physique auto-apprenante d’ici trois ans. Cette technologie pourrait jouer un rôle important dans le développement futur de l’intelligence artificielle.

Article : « Self-Learning Machines Based on Hamiltonian Echo Backpropagation » – DOI: 10.1103/PhysRevX.13.031020