Yannick Marandet, Aix-Marseille Université (AMU)

La fusion nucléaire fascine et divise. Au-delà de la grande collaboration internationale ITER, mise en place dans les années 1980 afin de fournir un prototype de centrale électrique réellement utilisable pour alimenter le réseau en électricité, les avancées récentes ont fait apparaître de nouveaux acteurs dans le domaine, notamment des start-ups.

Pour faire le point sur les défis scientifiques et technologiques de la fusion, pour mieux comprendre comment les chercheurs et chercheuses vivent le fait de s’impliquer dans des projets de si longue haleine, Elsa Couderc, cheffe de rubrique Sciences et Technologies à The Conversation France, a rencontré Yannick Marandet. Chercheur en physique des plasmas, il a longtemps été directeur de la Fédération française de recherche sur la fusion par confinement magnétique (FR-FCM) et co-dirige aujourd’hui un grand projet de recherche sur les supraconducteurs et la fusion, financé par France 2030.

The Conversation : Vous travaillez sur la fusion nucléaire depuis vingt-cinq ans et vous avez pris diverses responsabilités pour coordonner les efforts français sur la fusion nucléaire, principalement orientés aujourd’hui vers la collaboration internationale ITER. Est-ce que vous pouvez commencer par nous expliquer ce qu’est la fusion nucléaire ?

Yannick Marandet : La fusion nucléaire, ce sont des réactions nucléaires qui sont à l’œuvre dans les étoiles, notamment dans le Soleil. C’est un peu comme des Lego : on assemble des petits noyaux pour en faire des plus gros. Ce sont en fait les processus par lesquels les éléments chimiques dont on est tous constitués, dont la Terre est constituée – comme le carbone, le fer ou l’oxygène – se sont formés dans des générations d’étoiles précédentes. D’où la fameuse expression, « Nous sommes tous des poussières d’étoiles ».

Ces réactions de fusion permettent de fabriquer des atomes plus gros, et ce faisant, elles libèrent de l’énergie contenue dans les noyaux que l’on assemble. Ainsi, dans une étoile en phase de vie normale, quatre noyaux d’hydrogène s’assemblent (l’élément le plus léger de l’Univers, un proton) pour faire un noyau d’hélium.

En fait, le terme hélium vient d’Hélios, car l’hélium a été découvert initialement en observant une éclipse solaire, en 1868. C’est intéressant de penser qu’on a trouvé de l’hélium dans notre étoile avant de l’observer sur Terre. Mais ce n’est qu’une fois qu’on a découvert cet élément sur notre planète, en 1895, qu’on a pu le peser et se rendre compte qu’il est un peu plus léger que quatre noyaux d’hydrogène – de l’ordre de 1 % plus léger. Cette masse perdue durant la transformation de l’hydrogène en hélium a été convertie en énergie : c’est la célèbre formule d’Einstein, E=mc2.

Comment est née l’idée d’utiliser ces phénomènes au cœur des étoiles pour générer de la chaleur, et donc de l’électricité ?

Y. M. : L’idée d’imiter ce qui se passe dans les étoiles est arrivée assez vite. Mais il faut savoir que les réactions de fusion nucléaire entre atomes d’hydrogène qui ont lieu dans les étoiles sont très inefficaces : les premières étapes de ces réactions sont tellement lentes qu’on ne peut même pas en mesurer la vitesse !

Il a donc d’abord fallu comprendre qu’on ne peut pas faire exactement ce que fait le Soleil, mais qu’on peut essayer de faire mieux, en utilisant des réactions qui sont plus rapides. Pour cela, il faut d’abord étudier comment marche une réaction de fusion.

Il faut d’abord faire se rapprocher les noyaux atomiques… malheureusement, ceux-ci se repoussent spontanément – plus ils sont gros, plus ils sont chargés et plus ils se repoussent. On a vu que la fusion de noyaux d’hydrogène à l’œuvre dans les étoiles n’est pas très efficace et, pour ces raisons, les réactions de fusion entre les isotopes de l’hydrogène ont été considérées. Les noyaux de ces isotopes ont par définition la même charge que l’hydrogène, mais contiennent un ou deux neutrons.

La solution actuelle – celle que l’on doit utiliser dans ITER – est arrivée dans le cadre du projet Manhattan – le projet de recherche du gouvernement américain qui visait à construire une bombe atomique, entre 1939 et 1947. Celui-ci se concentrait évidemment sur la fission nucléaire, mais ils ont assez vite pensé à rajouter une dose de fusion par-dessus. Pendant cette période, d’énormes progrès ont été faits en physique nucléaire parce qu’il y a eu de très gros moyens, très focalisés… ce qui a bénéficié au domaine de la fusion, même si c’est un héritage dont on n’aime pas nécessairement se réclamer.

Quoi qu’il en soit, quand les chercheurs du projet Manhattan ont commencé à faire fonctionner des réacteurs nucléaires, ils ont produit du tritium – l’isotope le plus lourd de l’hydrogène, avec deux neutrons. Et quelqu’un s’est rendu compte que le deutérium et le tritium, pour des raisons d’abord mystérieuses à l’époque, fusionnaient 100 fois plus vite que deux noyaux de deutérium.

Une réaction de fusion exploitable pour en faire de l’électricité avait été découverte.

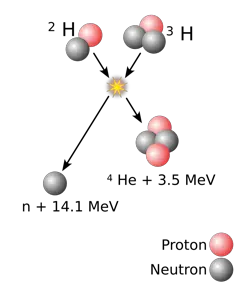

Y. M. : Oui. Quand on fait une réaction deutérium-tritium, ça fait un noyau d’hélium cinq, extrêmement instable, qui se désintègre en un hélium quatre et un neutron. Ceux-ci vont extrêmement vite – l’énergie qu’on a perdue en masse se retrouve dans l’énergie de mouvement. En freinant ces particules, par collision dans la paroi de la machine, on va récupérer cette énergie, faire chauffer de l’eau et faire tourner des turbines.

Cette réaction deutérium-tritium a un énorme avantage, c’est qu’elle est beaucoup plus probable, et donc rapide, que les autres réactions de fusion nucléaire, comme la fusion de deux hydrogènes, observée dans le Soleil et dont on parlait précédemment… mais elle pose deux défis.

Le premier, c’est qu’elle utilise du tritium, qui est radioactif. Le problème n’est pas tant sa dangerosité, qui est limitée, mais plutôt sa demi-vie (le temps nécessaire pour que la moitié des atomes se désintègrent naturellement), qui n’est que de douze ans. De ce fait, c’est un élément très rare. Il faut le fabriquer pour s’en servir comme combustible – dans ITER par exemple, même si le plasma contiendra de l’ordre d’un gramme de tritium, il faudra stocker quelques kilogrammes sur site.

Le deuxième défaut de cette réaction, c’est qu’elle génère des neutrons de 14 mégaélectronvolts. Cette échelle peut sembler un peu absconse quand on n’a pas l’habitude de la manipuler : ce qu’il faut retenir, c’est que ces neutrons sont très énergétiques, suffisamment pour transformer des impuretés dans la paroi en éléments radioactifs. Et ça, c’est un défi – à tel point qu’aujourd’hui, un domaine de recherche entier est dévolu à développer des matériaux sans ces impuretés.

Pour la fusion deutérium-tritium, il faut utiliser ce neutron énergétique pour bombarder du lithium, et ainsi récupérer du tritium : on résout à la fois le problème d’approvisionnement en tritium et on produit de la chaleur supplémentaire par ces réactions.

Si l’on compare à une centrale à charbon de 300 MW électrique, qui brûle de 1 million à 2 millions de tonnes par an, l’avantage de la fusion est évident : il faut 30 kg de deutérium (l’océan en contient en quantité) et une centaine de kilos de lithium par an. Tout ça sans production de gaz à effet de serre ni déchets autres que la machine elle-même, et sans risques d’emballement.

Mais c’est aussi pour s’affranchir des problèmes liés aux neutrons énergétiques que différentes start-ups promettent aujourd’hui ce qu’on appelle la fusion « aneutronique », exploitant des réactions de fusion dans lesquelles on ne produit pas (ou peu) de neutrons. En n’utilisant pas de tritium, on aurait un carburant qui ne serait pas radioactif et pas (ou peu) de neutrons en sortie. La réaction de choix pour faire ça, c’est de fusionner un proton avec du bore (élément chimique dont le noyau compte cinq protons)… mais elle nécessite de monter à des températures dix à cent fois plus élevées que celles envisagées dans ITER, ce qui veut dire que ces start-ups devront obtenir des plasmas extrêmement performants.

À quelle température a lieu la réaction deutérium-tritium, celle qui doit être utilisée dans ITER ?

Y. M. : Cent cinquante millions de degrés ! Cette température est un vrai défi pour les scientifiques aujourd’hui.

Les plans initiaux de développement de la fusion, dans les années 1940 et 1950, étaient très optimistes… En effet, à l’époque, on ne connaissait pas très bien ce qu’on appelle aujourd’hui la « physique des plasmas ». À 150 millions de degrés, un gaz d’hydrogène de deutérium-tritium n’est plus un gaz ! C’est ce qu’on appelle un « plasma », c’est-à-dire un milieu suffisamment énergétique, suffisamment chaud, pour que tous les électrons soient arrachés de leurs noyaux. On se retrouve avec une soupe d’électrons et d’ions.

On pourrait penser que cette soupe est similaire à un gaz ; mais la grosse différence avec des molécules dans un gaz est que les particules chargées se sentent les unes les autres à grande distance. Ainsi, dans un plasma, si on bouscule un électron quelque part, tous les électrons autour vont le sentir, et bouger également… on comprend bien qu’il peut se passer des choses très intéressantes du point de vue de la physique !

Mais plus complexes aussi, surtout du point de vue des applications. Parce qu’un plasma est quelque chose d’assez compliqué à maîtriser, qui devient très vite turbulent.

Et justement, vous avez réalisé votre thèse au début des années 2000, sur l’analyse des plasmas turbulents. Quelles étaient les problématiques à l’époque ?

Y. M. : J’ai fait ma thèse sur la caractérisation de plasmas, en collaboration avec des collègues d’une expérience de fusion appelée à l’époque « Tore Supra » au CEA Cadarache, dans les Bouches-du-Rhône (cette machine est devenue West). J’analysais la lumière émise par les plasmas. Nous avions l’expertise d’analyse, de spectroscopie, et Tore Supra fournissait des plasmas ; ils avaient besoin de mieux comprendre ce qu’ils voyaient.

Une des grandes questions de la recherche sur la fusion a toujours été celle de la qualité du confinement. On utilise des champs magnétiques, générés par des électroaimants, qui confinent les particules chargées dans la machine. En effet, vous l’aurez compris, pour avoir des réactions de fusion, il faut chauffer le plasma. Mais c’est comme à la maison : si on allume les radiateurs à fond mais qu’on laisse les fenêtres ouvertes, la température dans la pièce ne va pas monter beaucoup. Si on ferme les fenêtres, ça va aller mieux, et si on isole mieux la maison, la température va monter plus haut pour la même puissance de radiateur. Dans notre cas, les champs magnétiques jouent un rôle d’isolant. Il faut réussir à isoler suffisamment pour que la température monte à 150 millions de degrés au cœur de la machine et que les réactions de fusion se produisent – après cela, ce sont ces réactions elles-mêmes qui chauffent le plasma.

La qualité de l’isolation est un peu la raison pour laquelle les gens étaient optimistes au départ : on pensait que la chaleur s’échapperait par conduction, c’est-à-dire sans mouvement du plasma, comme quand on pose quelque chose de chaud à un endroit, et que la chaleur passe dans les objets autour. En réalité, le plasma se met en mouvement, comme quand on chauffe de l’eau dans une casserole : il y a des cellules de convection dans la casserole, de la turbulence, qui font que l’eau monte, redescend, et que ça se mélange beaucoup mieux que par conduction ; ce qui mène à une perte de chaleur. Comprendre cette turbulence dans les plasmas est un fil directeur des études sur la fusion depuis longtemps.

La problématique de ma thèse était de mieux caractériser la turbulence en regardant certaines propriétés de la lumière émise par le plasma.

Comment ces problématiques ont-elles évolué au fil de votre carrière ?

Y. M. : La question du confinement magnétique du plasma est globalement beaucoup mieux comprise… mais, encore aujourd’hui, il reste des points difficiles.

En effet, on sait que lorsqu’on dépasse une certaine puissance de chauffage dans le plasma, celui-ci s’organise de manière un peu différente, dans un régime où cette fameuse turbulence qui nous embête se « suicide » au bord du plasma : elle génère elle-même des écoulements qui la suppriment. Ça permet de beaucoup mieux confiner le plasma, et ce régime de fonctionnement (au-dessus d’une certaine puissance de chauffe) a été appelé « le mode H », pour high confinement. C’est le mode d’opération qui a été prévu dans ITER.

Néanmoins, bien que l’on ait compris des aspects importants de son fonctionnement, on ne sait toujours pas prédire avec précision à quel niveau de chauffage la transition vers le mode H va se produire. Des lois empiriques, fondées sur les résultats des expériences actuelles, sont utilisées pour extrapoler à ITER. Cette situation n’est pas si inhabituelle, les avions volent bien que nous n’ayons pas percé tous les secrets de la turbulence autour des ailes. Mais mieux on comprend, plus on peut optimiser.

Pourquoi le mode H résiste-t-il aux efforts des physiciens depuis quarante ans ?

Y. M. : Très probablement parce qu’il implique des interactions entre des phénomènes à différentes échelles. Dans l’espace, on doit comprendre des mécanismes depuis les échelles millimétriques jusqu’au mètre ou à la dizaine de mètres (la taille de la machine) ; et dans le temps, depuis la fraction de microsecondes jusqu’à plusieurs secondes. Il est difficile de capturer toutes ces échelles de manière globale, de les intégrer les unes aux autres, de façon suffisamment générale pour être prédictives.

Ici aussi, on est dans une situation qui est très intéressante du point de vue de la physique, mais qui nécessite une modélisation extrêmement détaillée au niveau des processus microscopiques, car nous avons affaire à des milieux hors d’équilibre. La physique est très riche parce qu’elle implique des particules, des champs électromagnétiques, dans des configurations géométriques complexes. Elle est aussi très « non linéaire ». Pour simplifier, ceci signifie qu’on ne peut pas résoudre les équations à la main, de façon exacte : on approxime les solutions numériquement, avec des ordinateurs. La puissance de calcul disponible sur les très gros calculateurs a ainsi permis de grands progrès.

Ceci étant, malgré ces frustrations au niveau de la compréhension théorique, les expériences ont progressé et les performances des machines comme les tokamaks ont été multipliées par 100 000 depuis les années 1970 (en termes de « triple produit », une métrique qui mesure de la qualité de l’isolation).

La qualité de l’isolation tient-elle à la puissance des aimants ?

Y. M. : En partie. Disons que si on est capable de faire des champs magnétiques plus élevés, en principe, on est capable d’avoir un meilleur confinement. Mais, sur ITER, on a déjà poussé les champs magnétiques proche de la limite pour la technologie d’aimants utilisée, d’autant plus qu’il faut magnétiser un volume gigantesque – ITER fait 800 mètres cubes.

On utilise donc le second facteur pour améliorer l’isolation : on augmente la taille. Pensez au thé – on laisse le thé dans la théière parce qu’il y refroidit moins vite que dans une petite tasse. C’est pour ça que les machines comme ITER, les tokamaks, ont eu tendance à grossir avec les années. On peut dire que la taille d’ITER est directement liée à la technologie d’aimants utilisée.

Aujourd’hui, on entend pourtant parler de start-ups qui veulent faire des machines, des tokamaks, plus petites…

Y. M. : Tout à fait, avec l’idée que cela réduira très significativement le coût de construction. L’idée est d’utiliser une autre technologie d’aimants, plus récente que celle utilisée dans ITER et qui doit encore faire ses preuves. ITER utilise des électro-aimants supraconducteurs, c’est-à-dire à base de matériaux n’opposant aucune résistance au passage d’un courant électrique. On peut faire passer des courants gigantesques, des dizaines de milliers d’ampères, sans perte par chauffage… ce qui permet de faire des aimants très puissants. Mais pour être supraconducteurs, ces matériaux doivent être refroidis à -269 °C et ne doivent pas être plongés dans des champs magnétiques au-dessus de typiquement douze tesla (l’unité des champs magnétiques)

Dans les années 1980, des matériaux supraconducteurs à haute température critiques ont été découverts. Ces matériaux fonctionnent déjà bien à -195 °C, pour le grand public, c’est toujours très froid, mais cela simplifie beaucoup le refroidissement, car on peut utiliser de l’azote liquide.

Et si on utilise ces mêmes supraconducteurs entre -269 °C et -250 °C – ce qui est tout à fait possible, mais nécessite un frigo plus cher et plus encombrant –, on peut faire passer des courants deux fois plus importants que dans les supraconducteurs classiques et générer des champs magnétiques deux fois plus intenses… ce qui permet en principe de réduire la taille de la machine, sans perdre en qualité d’isolation !

VERS DES TOTAMAKS PLUS PETITS

La stratégie de certaines start-ups est de réduire la taille des tokamaks en utilisant des aimants supraconducteurs à plus haute température critique, dans lesquels on puisse faire passer des courants plus forts à basse température. Il y a quelques années, ces matériaux extrêmement difficiles à fabriquer à une échelle industrielle sont devenus relativement mûrs. CFS, une spin-off du Massachusetts Institute of Technology (MIT), s’est mis en tête de développer un aimant de tokamak sur la base d’un matériau appelé Rebco (pour « Rare Earth Baryum Copper Oxyde »). Ils ont démontré qu’ils pouvaient générer un champ magnétique deux fois plus élevé que les aimants d’ITER. Ils construisent maintenant une machine qui s’appelle Sparc. La start-up chinoise Energy Singularity a utilisé les mêmes matériaux pour faire un champ magnétique encore un peu plus intense, en 2024. Un des débats actuels – assez vif – sur la possibilité de réduire la taille des tokamaks porte sur la résistance mécanique de la machine dans son ensemble. En effet, avec ces aimants si puissants, il y a de telles forces qui s’appliquent dans le tokamak qu’il faut vraiment ruser pour que le bâti soit assez résistant – en caricaturant, s’il faut tant d’acier pour tenir les aimants en place qu’on atteint la taille d’ITER, on n’aura rien gagné. À supposer que tout ça fonctionne, on se demande ensuite si, en faisant une machine plus petite on ne risque pas d’accentuer d’autres défis. C’est tout l’enjeu des années à venir, et Sparc est une expérience très intéressante !

C’est pour cela qu’un gros projet a été lancé au niveau français, un « PEPR » (un programme et équipement prioritaire de recherche) appelé SupraFusion, et dont vous êtes un des co-directeurs ?

Y. M. : Oui, SupraFusion s’attaque exactement à cette question : maîtriser la technologie des aimants supraconducteurs à haute température pour développer des applications sociétales – sachant que c’est la fusion qui est en train de tirer l’industrialisation de ces technologies avancées d’aimants supraconducteurs.

Que peut-on faire d’autre avec des aimants supraconducteurs à haute température ?

Y. M. : Il y a déjà un câble électrique d’alimentation de la gare Montparnasse qui utilise ces technologies-là, qui permettent de faire des câbles très compacts – très utiles lorsqu’il y a peu de place, en milieu urbain. On envisage aussi des dispositifs électrotechniques qui permettent de renforcer la stabilité des réseaux électriques (des « limiteurs de courant ») ; mais aussi des génératrices d’éoliennes plus légères, plus efficaces. En santé, on pourrait faire des IRM plus petits voire portables. En physique des particules, de nouveaux accélérateurs.

L’idée, c’est d’utiliser la fusion comme aiguillon – ce qu’on appelle l’« effet Formule 1 ». On s’attaque à quelque chose d’extrêmement difficile pour tirer l’innovation, et on attend un ruissellement sur beaucoup d’autres applications qui sont moins exigeantes.

Est-ce que vous sentez une évolution dans la perception de la fusion nucléaire par rapport à vos débuts ?

Y. M. : Quand je suis arrivé, c’était une phase un petit peu plus compliquée, la décision de construire ITER n’était pas acquise.

Enfant, je rêvais de devenir astrophysicien, mais j’ai finalement choisi de travailler sur la fusion parce que je voulais contribuer plus directement à la société.

Ceci dit, le chemin à parcourir vers l’énergie de fusion restait assez flou pour moi. J’étais focalisé sur ma thématique de recherche et il faut du temps pour acquérir une vision plus large des problématiques en jeu. L’importance du défi scientifique et l’impact qu’aura l’énergie de fusion étaient déjà bien perçus, mais cela restait avant tout pour moi un problème de physique, dont l’ambition me fascinait. Lors de mon postdoc à l’Université de Floride, je me souviens avoir été approché par un collègue qui m’a expliqué travailler avec une entreprise privée de fusion, Tri-Alpha Energy, et m’a encouragé à les rejoindre. Je crois que j’ai dû le dévisager comme s’il était un extraterrestre, cela me semblait complètement décalé ! Cette entreprise existe toujours (TAE Technologies) et génère des revenus en commercialisant des appareils d’imagerie médicale développés dans le cadre de ses recherches sur la fusion.

À l’heure actuelle, de nombreuses start-ups travaillent sur la fusion. Leur existence change la perception qu’ont le public et les décideurs : la physique est suffisamment comprise, et le travail sur ITER a suffisamment fait progresser la technologie pour se lancer dans la bataille de la commercialisation dès maintenant. Les années à venir vont être très intéressantes.

Il me semble, par ailleurs, observer la montée en puissance d’un courant de pensée hostile au progrès scientifique en général et à la fusion en particulier. Se doter d’une nouvelle source d’énergie est perçu comme néfaste – on s’entête dans une forme de fuite en avant alors qu’il faudrait juste être plus sobre. Il s’agit là d’une question de choix de société et le rôle des scientifiques est d’informer ces choix – pour ce qui concerne l’énergie, ma conviction est qu’il est plus sage de se donner les moyens d’agir. S’il devient vital d’extraire du CO2 de l’atmosphère en masse, les besoins énergétiques seront gigantesques et la fusion ne sera pas de trop !

Mais l’actualité de ces dernières années, à la fois géopolitique et climatique, a refocalisé l’attention du grand public sur la question de l’énergie, bien plus qu’au moment où j’ai débuté ma carrière. Il me semble que la fusion est perçue comme une partie de la solution. À mon sens le seul danger est que son développement soit utilisé comme prétexte pour ne pas réduire les émissions de gaz à effet de serre dès maintenant. Les moyens mis dans la fusion peuvent paraître énormes du point de vue de la recherche, mais il faut les comparer au coût de notre système énergétique. Il est alors clair que les ressources mises dans la fusion ne vont pas étouffer la transition énergétique.

Enfin, le projet ITER résulte de discussions entre Reagan et Gorbatchev – il y avait vraiment l’idée de développer cette source d’énergie dans un but de paix. Cette dimension de collaboration scientifique entre grandes puissances pour des applications au bénéfice de tous existe encore dans le monde multipolaire d’aujourd’hui et contribue à donner une image positive de la fusion magnétique.

Est-ce différent de faire de la recherche sur la fusion nucléaire dans un pays où la fission est si bien installée, par rapport à un pays où le mix énergétique n’inclut pas ou peu de fission ?

Y. M. : C’est une question intéressante. L’énergie de fusion sera une énergie pilotable décarbonée, qui est donc très utile pour stabiliser les réseaux électriques et garantir la continuité de l’alimentation. Il en va de même pour les centrales nucléaires actuelles, mais les réserves en uranium sont limitées, surtout dans un contexte de forte croissance du secteur. L’approvisionnement en uranium est l’une des raisons pour lesquelles la France relance aujourd’hui le programme de « réacteurs à neutrons rapides », une technologie de fission nucléaire. Certaines promesses de ces réacteurs sont similaires à celles de la fusion (avec sa capacité à produire de l’électricité pendant très longtemps sur les réserves actuelles, etc.) et ces réacteurs à neutrons rapides ont déjà produit de l’électricité en France (Superphénix). Par contre, cette technologie présente des risques comparables à ceux des centrales nucléaires actuelles. Quoi qu’il en soit, leur relance joue certainement un rôle sur la perception de l’utilité de la fusion à moyen terme au niveau des acteurs français du domaine.

Si l’on regarde ce qui se passe ailleurs, le Royaume-Uni investit lourdement dans la fusion et construit des réacteurs nucléaires EPR français en parallèle. La Chine a les moyens de développer toutes les technologies de front : les variantes de la fission, et plusieurs projets de fusion majeurs. De fait, on estime que la Chine dépense plus de 1,5 milliard d’euros par an pour son programme fusion, devant les États-Unis et l’Europe.

La situation est différente en Allemagne, qui est sortie du nucléaire et où la production pilotable est essentiellement assurée par des centrales au charbon et au gaz, qui émettent des quantités importantes de gaz à effet de serre. L’Allemagne s’est dotée récemment d’une feuille de route ambitieuse pour la fusion, dans l’optique de décarboner à terme cette part pilotable.

Le fait est que si la France investit lourdement dans l’énergie nucléaire, elle investit également dans la fusion : dans le projet ITER dont les retombées économiques sont majeures (6 milliards d’euros de contrats pour les industriels français à ce jour) et, en parallèle, dans l’étape suivante, à travers le projet de PEPR et le soutien à une start-up française du domaine, située à Grenoble, Renaissance Fusion.

Avec la fusion, les échéances semblent toujours lointaines – on parle de plasma dans ITER en 2035, de génération d’électricité pour alimenter le réseau à la fin du siècle. Est-ce que vous avez l’impression de vivre dans le futur en travaillant sur quelque chose qui n’arrivera pas d’ici la fin de votre carrière ?

Y. M. : Quelqu’un a comparé ça aux constructeurs de cathédrales. On travaille sur un projet dont les fruits ne seront pas nécessairement disponibles dans la durée de notre vie. On se met au service de quelque chose de plus grand. C’est une forme d’humilité, chacun apporte sa pierre ! Alors, il y a les boutades habituelles sur la fusion (« C’est pour dans trente ans et ça le restera »)… mais ce que je constate, c’est qu’il y a beaucoup de progrès, comme je vous le disais, sur les performances depuis les années 1970.

En ce moment, on progresse sur des aspects importants, comme le record de durée de plasma réalisé dans West cette année (1 337 secondes, soit 22 minutes).

En termes de performance sur le gain de fusion, les progrès ont été portés par nos collègues de la fusion inertielle, qui utilisent des lasers et ont obtenu des gains nets supérieurs à 1, c’est à dire que le plasma a produit plus d’énergie que ce qui lui a été apporté par les lasers. Sur ce point, pour la fusion magnétique, nous sommes dans une phase de latence, le temps qu’ITER soit finalisé. Je pense qu’une des raisons pour lesquelles ça prend autant de temps, c’est que les objectifs d’ITER sont extrêmement ambitieux : puisque on veut faire dix fois mieux qu’aujourd’hui en termes de performance, et le faire pendant mille secondes pour s’approcher du fonctionnement d’une centrale… alors que les records de performance actuels, en termes de gain, ont été atteints pour moins d’une seconde.

En d’autres termes, vous cherchez à faire dix fois mieux pendant mille fois plus longtemps…

Y. M. : Oui, et c’est important, parce que certaines start-ups promettent des choses bien plus tôt, mais sur des durées de plasma beaucoup plus courtes. Les résultats seront très intéressants, mais cela leur permet d’éviter pour l’instant des problèmes que l’on aura de toute façon, un jour ou l’autre, dans une centrale.

Mais je pense qu’on travaille en fait en parallèle, car ces start-ups poussent des technologies qui pourraient s’avérer clé pour la suite. Ma conviction, c’est que grâce à ces efforts combinés, l’étape « post-ITER » va beaucoup accélérer.

Yannick Marandet, Directeur de recherches CNRS, Aix-Marseille Université (AMU)

Cet article est republié à partir de The Conversation sous licence Creative Commons. Lire l’article original.