Alors que le sommet de l’IA bat son plein, les chercheurs sont désireux de soulever un problème très réel associé à la technologie – lui apprendre à oublier. La société est maintenant en effervescence avec l’IA moderne et ses capacités exceptionnelles ; nous sommes constamment rappelés de ses bénéfices potentiels, dans tant de domaines, imprégnant pratiquement toutes les facettes de nos vies – mais aussi de ses dangers.

L’apprentissage de la machine à oublier

Dans un domaine de recherche émergent, les scientifiques mettent en évidence une arme importante dans notre arsenal pour atténuer les risques de l’IA – ‘l’oubli de la machine’. Ils aident à trouver de nouvelles façons de faire oublier aux modèles d’IA connus sous le nom de Deep Neural Networks (DNNs) les données qui posent un risque pour la société.

Le problème est que la rééducation des programmes d’IA pour ‘oublier’ les données est une tâche très coûteuse et ardue. Les DNNs modernes tels que ceux basés sur les ‘Large Language Models‘ (comme ChatGPT, Bard, etc.) nécessitent d’énormes ressources pour être formés – et prennent des semaines ou des mois pour le faire. Ils nécessitent également des dizaines de gigawattheures d’énergie pour chaque programme de formation, certaines recherches estimant autant d’énergie que pour alimenter des milliers de ménages pendant un an.

L’oubli de la machine : un nouveau champ de recherche

L’oubli de la machine est un domaine de recherche naissant qui pourrait éliminer rapidement, à moindre coût et en utilisant moins de ressources, les données problématiques des DNNs. L’objectif est de le faire tout en continuant à garantir une grande précision.

Des experts en informatique de l’Université de Warwick, en collaboration avec Google DeepMind, sont à l’avant-garde de cette recherche. Le professeur Peter Triantafillou, du département d’informatique de l’Université de Warwick, a récemment co-écrit une publication ‘Vers un oubli de la machine sans limites‘.

En synthèse

Les DNNs sont des structures extrêmement complexes, composées de jusqu’à des billions de paramètres. Souvent, nous manquons d’une compréhension solide de comment et pourquoi ils atteignent leurs objectifs. Étant donné leur complexité, et la complexité et la taille des ensembles de données sur lesquels ils sont formés, les DNNs peuvent être nuisibles à la société.

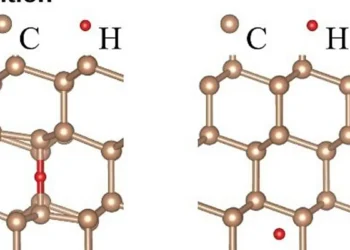

Les DNNs peuvent être nuisibles, par exemple, en étant formés sur des données avec des biais – propageant ainsi des stéréotypes négatifs. Les données pourraient refléter des préjugés existants, des stéréotypes et des suppositions sociétales erronées – comme un biais selon lequel les médecins sont des hommes, les infirmières des femmes – ou même des préjugés raciaux.

Les DNNs pourraient également contenir des données avec des ‘annotations erronées’ – par exemple, l’étiquetage incorrect d’éléments, comme l’étiquetage d’une image comme étant un deep fake ou non.

De manière alarmante, les DNNs peuvent être formés sur des données qui violent la vie privée des individus. Cela pose un énorme défi aux méga-entreprises technologiques, avec une législation significative en place (par exemple le RGPD) qui vise à sauvegarder le droit à l’oubli – c’est-à-dire le droit de toute personne à demander que ses données soient supprimées de tout ensemble de données et programme d’IA.

Notre recherche récente a dérivé un nouvel algorithme d’oubli de la machine qui assure que les DNNs peuvent oublier les données douteuses, sans compromettre les performances globales de l’IA. L’algorithme peut être introduit dans le DNN, lui faisant oublier spécifiquement les données que nous avons besoin qu’il oublie, sans avoir à le ré-entraîner entièrement à partir de zéro. C’est le seul travail qui différencie les besoins, les exigences et les métriques de succès parmi les trois différents types de données à oublier : les biais, les annotations erronées et les problèmes de confidentialité.

L’oubli de la machine est un domaine de recherche passionnant qui peut être un outil important pour atténuer les risques de l’IA.

Pour une meilleure compréhension

Qu’est-ce que l’oubli de la machine ?

L’oubli de la machine est un domaine de recherche émergent qui vise à enseigner aux modèles d’IA, en particulier aux réseaux neuronaux profonds (DNNs), comment oublier les données qui peuvent poser un risque pour la société.

Pourquoi est-il important d’enseigner à l’IA à oublier ?

Les DNNs peuvent être formés sur des données biaisées, propageant ainsi des stéréotypes négatifs. Ils peuvent également contenir des données avec des annotations erronées ou qui violent la vie privée des individus. L’oubli de la machine peut aider à atténuer ces risques.

Quels sont les défis de l’oubli de la machine ?

La rééducation des programmes d’IA pour oublier les données est une tâche coûteuse et ardue. Cela nécessite d’énormes ressources et beaucoup de temps, ainsi que des quantités significatives d’énergie.

Quelles sont les avancées récentes dans ce domaine ?

Des experts en informatique de l’Université de Warwick, en collaboration avec Google DeepMind, ont développé un nouvel algorithme d’oubli de la machine qui permet aux DNNs d’oublier les données problématiques sans compromettre les performances globales de l’IA.

Quel est l’avenir de l’oubli de la machine ?

L’oubli de la machine est un domaine de recherche passionnant qui peut être un outil important pour atténuer les risques de l’IA. Les recherches futures se concentreront probablement sur l’amélioration de l’efficacité et de l’efficience de ces algorithmes.

Université de Warwick, Google DeepMind, Professeur Peter Triantafillou

Lisez l’article complet ici : https://arxiv.org/abs/2302.09880

L’équipe organise également la toute première compétition sur le désapprentissage automatique dans le cadre de NeurIPS 2023, hébergée par Kaggle (avec actuellement environ 950 équipes participantes du monde entier) pour dériver des algorithmes de désapprentissage pour une tâche difficile (désapprentissage de visages à partir d’un ensemble de données sur les visages). Parallèlement, nous organisons un atelier sur le désapprentissage des machines dans le cadre de NeurIPS 2023.