Les forces et les limites des progrès informatiques repoussent les limites de ce que les machines quantiques peuvent accomplir.

Du téléphone dans votre poche aux superordinateurs les plus rapides au monde, en passant par le monde encore expérimental de la technologie quantique, les ordinateurs se présentent sous de nombreuses formes, chacune avec ses forces et ses limites. Mais que pourront faire les ordinateurs du futur ?

Alors que les ordinateurs classiques alimentent notre vie quotidienne, les superordinateurs sont capables de relever certains des défis les plus difficiles de l’humanité. Quant aux ordinateurs quantiques, ils pourraient un jour résoudre des problèmes auxquels nous ne pouvons même pas encore penser. Comprendre en quoi ces trois types d’ordinateurs diffèrent et comment ils se complètent met en évidence le rôle unique que chacun joue dans la technologie moderne.

À l’université de Rochester, des chercheurs étudient comment améliorer le fonctionnement des ordinateurs actuels, utilisent des superordinateurs pour faire avancer la recherche et explorent les avancées fondamentales de la science et de la technologie quantiques. Leurs travaux contribuent à relier les découvertes dans des domaines tels que la physique et l’ingénierie aux progrès de l’informatique.

John Nichol, professeur associé au département de physique et d’astronomie, qui étudie l’informatique quantique expérimentale et le comportement quantique dans les systèmes à l’échelle nanométrique, déclare : « C’est une période vraiment passionnante pour étudier la mécanique quantique et l’informatique. »

Les ordinateurs classiques : le pilier du quotidien

Les ordinateurs classiques sont les machines que la plupart d’entre nous connaissent et utilisent dans notre vie quotidienne, des ordinateurs portables et téléphones aux ordinateurs de bureau et serveurs.

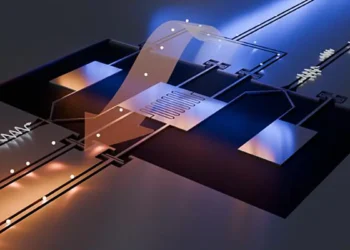

Au cœur de chaque ordinateur se trouve un processeur, un circuit intégré (ou puce) contenant plusieurs milliards de transistors. Les transistors sont de minuscules commutateurs qui représentent des bits et peuvent être soit à 0 (éteints), soit à 1 (allumés). Le processeur effectue des calculs en activant et désactivant les transistors, suivant les instructions stockées dans la mémoire. Ces instructions proviennent d’un logiciel (ou code), qui indique aux ordinateurs, étape par étape, comment traiter les informations et exécuter les tâches.

Points forts : La plupart des ordinateurs classiques actuels sont équipés de plusieurs processeurs (généralement entre 4 et 16), ce qui leur permet d’effectuer plusieurs tâches à la fois. Les processeurs spécialisés dans l’intelligence artificielle peuvent comporter des milliers de petits processeurs. Les ordinateurs classiques sont polyvalents, abordables et fiables pour les tâches quotidiennes telles que la saisie de documents, la navigation sur Internet, l’envoi d’e-mails et le streaming vidéo.

Limites : Certains problèmes sont trop importants ou trop complexes pour que les ordinateurs classiques puissent les résoudre dans un délai raisonnable. Pendant des décennies, les performances des puces ont été améliorées en réduisant la taille des transistors afin d’en intégrer davantage sur une puce, un principe connu sous le nom de loi de Moore. Mais cette approche a ses limites. Eby Friedman, professeur au département d’ingénierie électrique et informatique, étudie comment concevoir des processeurs et des systèmes informatiques afin d’optimiser les performances et l’efficacité énergétique. Il explique : « Les transistors ont été miniaturisés pendant des décennies, mais nous en sommes maintenant à un point où les transistors et les fils ne mesurent plus que quelques nanomètres de large. On ne peut pas miniaturiser indéfiniment. »

Une fois que l’on atteint des transistors si petits qu’ils sont à l’échelle des atomes, la physique entre en jeu : la chaleur s’accumule, le courant électrique devient excessif et l’efficacité chute. Les recherches de M. Friedman abordent ces questions sans se limiter à la miniaturisation des transistors, mais en repensant la conception des processeurs et des systèmes informatiques dans leur ensemble. Ses travaux explorent des moyens d’améliorer les performances et l’efficacité énergétique grâce à des circuits et des architectures plus intelligents, permettant aux ordinateurs classiques de continuer à progresser même lorsque les limites physiques sont atteintes.

Bien que les ordinateurs classiques soient suffisamment rapides pour les tâches quotidiennes, il est important d’améliorer leurs performances pour résoudre des problèmes d’ingénierie complexes, analyser de grands ensembles de données et soutenir les technologies émergentes telles que l’intelligence artificielle.

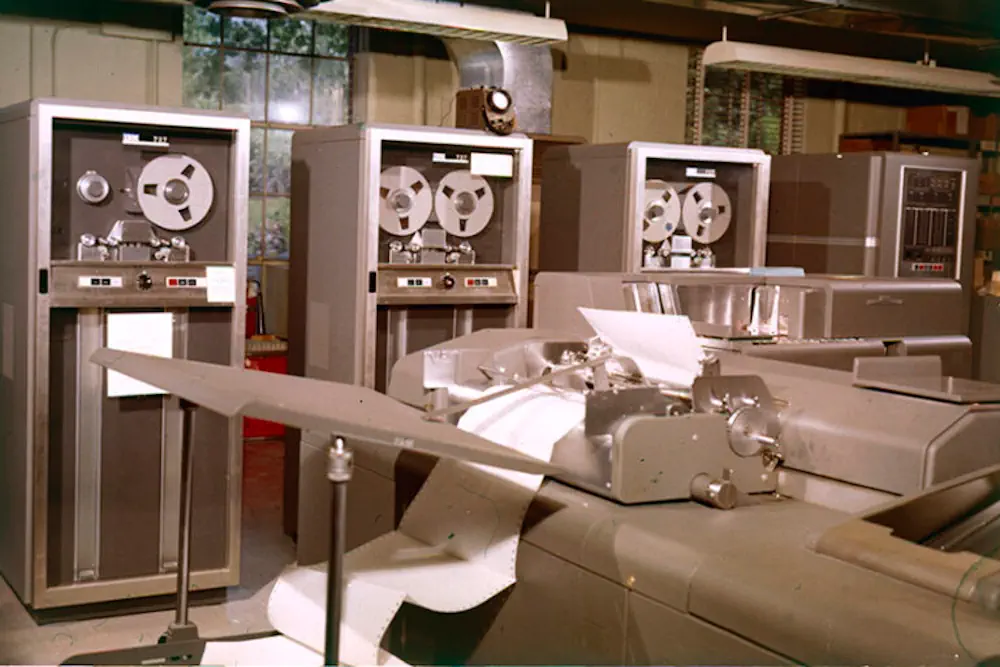

Des cartes perforées aux processeurs parallèles, l’histoire d’URochester retrace des décennies d’exploitation de la puissance de calcul.

Superordinateurs : des concentrés de puissance à grande échelle

Les superordinateurs font passer l’informatique classique à un niveau supérieur. À la base, les superordinateurs sont des ordinateurs classiques, mais ils sont beaucoup plus grands et plus rapides. Au lieu d’une poignée de processeurs, les superordinateurs utilisent des centaines de milliers de gros processeurs qui fonctionnent ensemble.

Mais les superordinateurs ne sont pas le seul moyen d’augmenter la puissance des ordinateurs classiques. Selon M. Friedman, de nombreuses tâches autrefois réservées aux supercalculateurs sont désormais prises en charge par des centres de données, qui sont des entrepôts de serveurs connectés. Alors que les supercalculateurs sont conçus pour résoudre un problème complexe à une vitesse incroyable, les centres de données tels que les fermes de serveurs cloud de Google ou d’Amazon sont conçus pour traiter simultanément de nombreuses tâches indépendantes, notamment l’hébergement de sites web, le stockage dans le cloud ou l’exécution d’outils d’IA. Leur puissance provient de leur grande échelle plutôt que de leur vitesse extrême pour traiter un seul problème.

Bien que ces systèmes puissent être conçus pour des objectifs différents, les ordinateurs classiques, les superordinateurs et les centres de données partagent tous les mêmes composants et principes de base.

« La technologie est optimisée différemment, les architectures sont optimisées différemment et les logiciels sont optimisés différemment, mais, en même temps, il s’agit toujours de transistors, ils calculent toujours en mémoire, c’est toujours binaire et les langages de programmation sont ceux que vous reconnaissez », explique Eby Friedman.

Points forts : les supercalculateurs sont efficaces pour résoudre des problèmes nécessitant d’importants calculs qui prendraient beaucoup trop de temps à des ordinateurs ordinaires. Ils peuvent prédire la météo, modéliser des pandémies, concevoir de nouvelles structures et simuler des systèmes complexes. Au Laboratoire d’énergie laser de Rochester, par exemple, les chercheurs utilisent le superordinateur Conesus pour modéliser des phénomènes physiques à des températures et des densités extrêmes, comme celles qui règnent au centre des étoiles. Ils simulent notamment la fusion afin de faire progresser les applications liées à l’énergie propre et à la sécurité nationale, analysent des données expérimentales et planifient des expériences plus efficaces.

« Le superordinateur Conesus a considérablement amélioré les capacités de calcul du LLE, permettant de comprendre des phénomènes physiques très complexes en trois dimensions avec un niveau de détail sans précédent », indique Valeri Goncharov, directeur de la division théorie du LLE et professeur adjoint de recherche au département de génie mécanique. « L’augmentation significative de la vitesse de calcul ouvre également des possibilités d’utiliser les résultats de la simulation pour entraîner des modèles d’IA, ce qui permet des avancées transformatrices dans des domaines tels que la recherche sur la fusion. »

Limites : malgré leur puissance considérable, et même avec les progrès réalisés dans les circuits, l’architecture et l’efficacité des ordinateurs classiques, certains calculs restent hors de portée d’un supercalculateur. Par exemple, les supercalculateurs peuvent simuler des molécules simples, mais la simulation de molécules complexes avec une grande précision peut submerger même les meilleures machines.

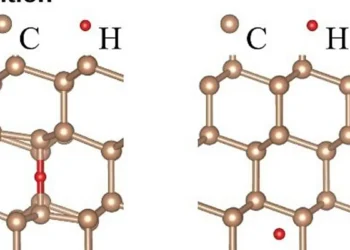

« La simulation de ma molécule préférée, et peut-être de votre molécule préférée, la caféine, nécessiterait un nombre de transistors à peu près égal au nombre d’atomes de silicium présents sur toute la planète Terre », ajoute M. Nichol. « Nous ne sommes en fait pas loin d’avoir des transistors individuels de la taille d’un atome individuel. Si nous voulons poursuivre la miniaturisation de la technologie informatique moderne, nous serons confrontés aux propriétés quantiques des atomes individuels et, dans un certain sens, nous serons contraints de passer à l’informatique quantique. »

Les ordinateurs quantiques : le nouveau paradigme

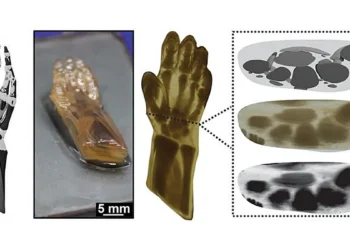

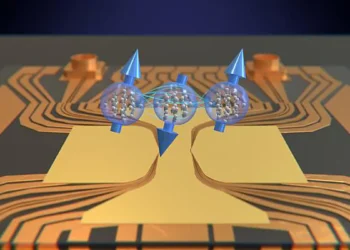

Les ordinateurs quantiques sont fondamentalement différents des ordinateurs classiques et des superordinateurs. Au lieu des bits ordinaires, qui ne peuvent être que 0 ou 1, les ordinateurs quantiques utilisent des bits quantiques appelés qubits. Grâce à des principes de la mécanique quantique tels que la superposition et l’intrication, les qubits peuvent exister dans plusieurs états à la fois. Autrement dit, ils peuvent être simultanément 0 et 1, ce qui ouvre des possibilités de calcul qui dépassent les capacités des ordinateurs classiques. Certains ordinateurs quantiques vont au-delà du qubit et utilisent des qudits, qui impliquent non seulement 0 et 1, mais aussi 2, 3, etc.

Les fondements de la mécanique quantique ont été développés il y a environ 100 ans, lorsque les scientifiques ont réalisé que la physique classique existante ne pouvait expliquer certains phénomènes, tels que la raison pour laquelle le métal chauffé brille en rouge plutôt qu’en bleu. Ils ont découvert que la lumière se présente sous forme de minuscules paquets, appelés plus tard photons. Au cours des décennies qui ont suivi, ces idées ont donné naissance à la mécanique quantique, la branche de la physique qui étudie le comportement souvent étrange et imprévisible de particules minuscules, telles que les électrons et les atomes.

Les progrès en informatique quantique dépendent donc de la compréhension des principes fondamentaux de la mécanique quantique, raison pour laquelle des scientifiques tels que John Nichol étudient ces systèmes à leur niveau le plus fondamental.

« L’information est physique », observe J. Nichol. « Les ordinateurs manipulent l’information. La physique nous explique comment cette information est manipulée. L’informatique quantique est donc un excellent exemple de cette interaction entre la physique et l’informatique. »

Points forts : les ordinateurs quantiques ne sont actuellement pas plus rapides dans tous les domaines, mais ils pourraient révolutionner certains secteurs, notamment le chiffrement et le déchiffrement, en permettant de nouvelles méthodes de sécurisation et de transmission des données. Les ordinateurs quantiques sont également adaptés à des tâches telles que la simulation de molécules et de matériaux complexes, ce qui pourrait transformer la découverte de médicaments et la science des matériaux. Les chercheurs étudient également comment les ordinateurs quantiques pourraient aider à résoudre des problèmes d’optimisation tels que l’amélioration de la logistique ou de la circulation routière.

Limites : Les technologies quantiques en sont encore à leurs balbutiements. Comme elles sont encore expérimentales et coûteuses, « le principal marché des ordinateurs quantiques est celui des gouvernements et des autres scientifiques », ajoute J. Nichol. L’un des principaux obstacles est la correction des erreurs : il s’agit de développer un ordinateur quantique capable de détecter et de corriger de manière fiable ses propres erreurs afin de pouvoir effectuer des calculs longs et complexes sans tomber en panne.

« Un ordinateur quantique universel tolérant aux pannes n’est pas encore pour demain », précise J. Nichol. « Mais certaines entreprises et certains groupes de recherche universitaires disposent désormais de processeurs quantiques dotés de centaines de qubits. Ces machines commencent à être capables d’effectuer des calculs assez importants qui ne peuvent être réalisés même par les meilleurs superordinateurs classiques. »

L’avenir de l’informatique

MM. Nichol et Friedman soulignent tous deux que les ordinateurs classiques ne disparaîtront pas, du moins pas dans un avenir proche. Les ordinateurs classiques resteront indispensables au quotidien, tandis que les superordinateurs continueront à relever les défis scientifiques et techniques les plus complexes. Quant aux ordinateurs quantiques, ils pourraient un jour ouvrir la voie à des problèmes et des solutions entièrement nouveaux.

Pourrions-nous donc un jour avoir des ordinateurs quantiques chez nous ?

J. Nichol estime que les ordinateurs quantiques ne feront probablement pas leur apparition dans les foyers dans un avenir proche, car les algorithmes et les calculs qu’ils exécutent ne sont pas particulièrement utiles pour les tâches quotidiennes. Mais, souligne-t-il, il est difficile de prédire comment la technologie va évoluer.

« Supposons que nous remontions le temps jusqu’en 1960 et que nous racontions aux gens ce que nous faisons aujourd’hui avec les ordinateurs », conclut le scientifique. « Ils ne nous croiraient pas. Je pense que nous en sommes au même point avec les ordinateurs quantiques. Nous n’avons aucune idée de toutes les choses pour lesquelles ils seront utiles. »

Source : Université de Rochester