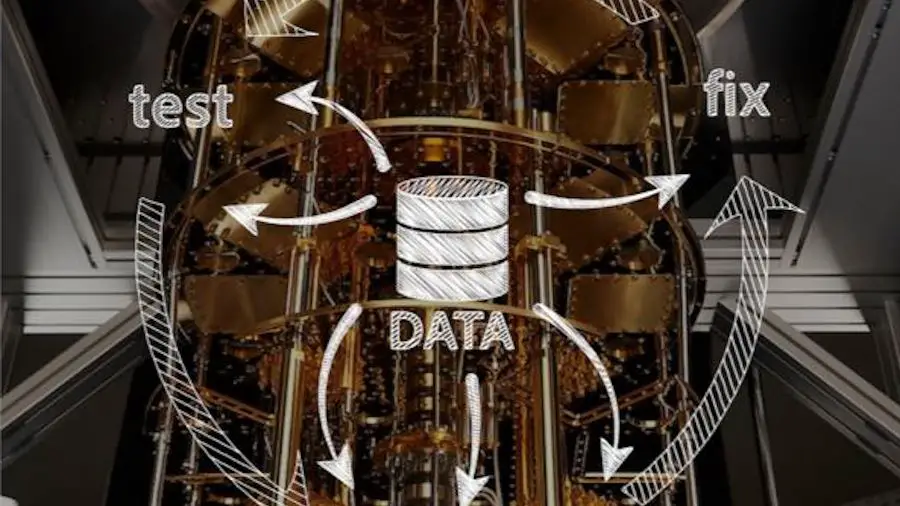

Les ordinateurs quantiques deviennent de véritables boîtes noires à mesure que leur taille et leur complexité augmentent. En utilisant des méthodes issues de la physique mathématique, une équipe est parvenue à extraire des nombres concrets de séquences de données aléatoires. Ces nombres peuvent servir de référence pour évaluer les performances d’un système informatique quantique.

Des experts du Helmholtz-Zentrum Berlin, de la Freie Universität Berlin, du Qusoft Research Centre Amsterdam, de l’Université de Copenhague et du Technology Innovation Institute Abu Dhabi ont participé à ces travaux, publiés dans Nature Communications.

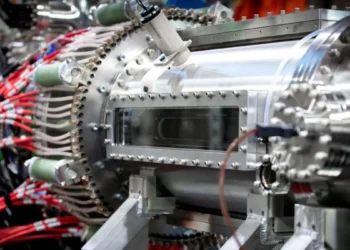

Les ordinateurs quantiques peuvent calculer des systèmes quantiques beaucoup plus efficacement et résoudre des problèmes en recherche sur les matériaux, par exemple. Cependant, plus les ordinateurs quantiques deviennent grands et complexes, moins les processus menant au résultat sont transparents. Des outils adaptés sont donc nécessaires pour caractériser de telles opérations quantiques et comparer équitablement les capacités des ordinateurs quantiques à la puissance de calcul classique pour les mêmes tâches. Une telle approche aux talents surprenants a été développée par une équipe dirigée par le professeur Jens Eisert et Ingo Roth.

Le professeur Roth, qui est actuellement en train de mettre en place un groupe au Technology Innovation Institute d’Abou Dhabi, explique : « À partir des résultats de séquences de test aléatoires, nous pouvons maintenant extraire différents nombres qui montrent à quel point les opérations sont proches statistiquement des opérations souhaitées. Cela nous permet d’apprendre beaucoup plus des mêmes données qu’auparavant. Et ce qui est crucial : la quantité de données nécessaires ne croît pas linéairement mais seulement de manière logarithmique. »

Cela signifie que pour apprendre cent fois plus, seulement deux fois plus de données sont nécessaires. Une énorme amélioration. L’équipe a pu le prouver en utilisant des méthodes issues de la physique mathématique.

« Il s’agit d’étalonner les ordinateurs quantiques« , déclare Eisert, qui dirige un groupe de recherche conjoint sur la physique théorique au Helmholtz-Zentrum Berlin et à la Freie Universität Berlin. « Nous avons montré comment des données aléatoires peuvent être utilisées pour calibrer de tels systèmes. Ce travail est important pour le développement des ordinateurs quantiques.«

Des séquences de données aléatoires pour étalonner les ordinateurs quantiques

L’équipe de recherche a développé une nouvelle approche pour extraire des informations quantitatives précises sur les opérations effectuées par un ordinateur quantique, à partir de séquences de données aléatoires.

Cette méthode permet d’évaluer les performances réelles d’un système quantique par rapport à un fonctionnement idéal théorique.

La quantité de données nécessaire pour caractériser un système quantique croît beaucoup moins vite que prévu, selon une loi logarithmique. Cette découverte ouvre la voie à une calibration plus efficace des futurs ordinateurs quantiques.

Cette approche fournit un outil de référence pour étalonner les ordinateurs quantiques, comparer leurs performances et guider leur développement technologique. Elle sera cruciale pour tirer pleinement parti du potentiel des technologies quantiques émergentes.

En synthèse

Cette recherche propose une nouvelle méthode prometteuse pour caractériser et étalonner les opérations effectuées par les ordinateurs quantiques. En extrayant des nombres de référence à partir de séquences de données aléatoires, elle permet d’évaluer précisément les performances réelles d’un système quantique.

L’approche développée nécessite aussi beaucoup moins de données que prévu pour apprendre sur le fonctionnement d’un ordinateur quantique. Elle constitue donc un outil essentiel pour le développement et l’optimisation des technologies quantiques émergentes, qui restent encore très opaques malgré leur fort potentiel.

Pour une meilleure compréhension

Quelle nouvelle approche a été développée ?

Il s’agit d’une méthode permettant d’extraire des nombres de référence à partir de séquences de données aléatoires générées par un ordinateur quantique. Ces nombres quantifient la proximité des opérations réelles par rapport aux opérations idéales.

À quoi sert cette approche ?

Elle sert à étalonner les ordinateurs quantiques, évaluer leurs performances réelles et comparer différents systèmes quantiques entre eux.

Quel est son principal avantage ?

Elle nécessite beaucoup moins de données que prévu pour caractériser un système quantique, grâce à une croissance logarithmique et non linéaire.

Pourquoi est-ce important ?

Cet outil de référence est crucial pour le développement des technologies quantiques, qui sont encore très opaques et difficiles à appréhender.

Qui a participé à cette recherche ?

Des experts de centres de recherche allemands, néerlandais, danois et émiriens ont collaboré à ces travaux.

Quel est le principal défi des ordinateurs quantiques ?

Leur manque de transparence et leur fonctionnement comme des boîtes noires à mesure qu’ils gagnent en taille et en complexité.

Comment cette méthode aide-t-elle à relever ce défi ?

En fournissant un moyen d’étalonner et de quantifier précisément les opérations effectuées par ces systèmes complexes.

Légende illustration principale : Les ordinateurs quantiques (ici une expérience à l’Institut d’innovation technologique d’Abu Dhabi) fonctionnent à très basse température pour minimiser le bruit et les perturbations indésirables. Grâce à un nouvel outil mathématique, il est désormais possible d’évaluer les performances d’un ordinateur quantique à l’aide de données de test aléatoires et de diagnostiquer d’éventuels bogues. Crédit : I. Roth/Quantum research center, TII

Article : « Shadow estimation of gate-set properties from random sequences » – DOI: 10.1038/s41467-023-39382-9