Divya Mahajan, Georgia Institute of Technology

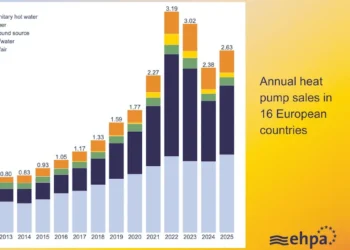

L’intelligence artificielle se développe rapidement, tout comme le nombre d’ordinateurs qui l’alimentent. En coulisses, cette croissance rapide met à rude épreuve les centres de données qui gèrent les modèles d’intelligence artificielle. Ces installations consomment plus d’énergie que jamais.

Les modèles d’IA sont de plus en plus volumineux et complexes. Les systèmes les plus avancés d’aujourd’hui ont des milliards de paramètres, les valeurs numériques dérivées des données d’entraînement, et fonctionnent sur des milliers de puces informatiques. Pour suivre le rythme, les entreprises ont réagi en ajoutant plus de matériel, plus de puces, plus de mémoire et des réseaux plus puissants. Cette approche de force brute a permis à l’IA de faire de grands progrès, mais elle a également créé un nouveau défi : Les centres de données deviennent des géants énergivores.

Certaines entreprises technologiques réagissent en cherchant à alimenter elles-mêmes leurs centres de données à l’aide de combustibles fossiles et de centrales nucléaires. La demande d’énergie liée à l’IA a également stimulé les efforts visant à fabriquer des puces informatiques plus efficaces.

Je suis ingénieur informaticien et professeur à Georgia Tech, spécialisé dans le calcul à haute performance. Je vois une autre voie pour réduire l’appétit énergétique de l’IA : Rendre les centres de données plus conscients des ressources et plus efficaces.

Énergie et chaleur

Les centres de données d’IA modernes peuvent consommer autant d’électricité qu’une petite ville. Et ce n’est pas seulement l’informatique qui consomme de l’énergie. La mémoire et les systèmes de refroidissement y contribuent également. À mesure que les modèles d’IA se développent, ils ont besoin de plus de stockage et d’un accès plus rapide aux données, ce qui génère plus de chaleur. En outre, à mesure que les puces deviennent plus puissantes, l’évacuation de la chaleur devient un défi majeur.

Le refroidissement n’est pas qu’un détail technique ; il représente une part importante de la facture énergétique. Le refroidissement traditionnel est assuré par des systèmes de climatisation spécialisés qui éliminent la chaleur des baies de serveurs. De nouvelles méthodes, comme le refroidissement par liquide, sont utiles, mais elles nécessitent une planification et une gestion de l’eau rigoureuses. En l’absence de solutions plus intelligentes, les besoins énergétiques et les coûts de l’IA pourraient devenir insoutenables.

Même avec tout cet équipement de pointe, de nombreux centres de données ne fonctionnent pas efficacement. En effet, les différentes parties du système ne communiquent pas toujours entre elles. Par exemple, le logiciel de planification peut ne pas savoir qu’une puce est en surchauffe ou qu’une connexion réseau est obstruée. Par conséquent, certains serveurs restent inactifs tandis que d’autres s’efforcent de suivre. Ce manque de coordination peut entraîner un gaspillage d’énergie et une sous-utilisation des ressources.

Une voie plus intelligente

Pour relever ce défi, il faut repenser la manière de concevoir et de gérer les systèmes qui soutiennent l’IA. Cela signifie qu’il faut s’éloigner de la mise à l’échelle par force brute et s’orienter vers une infrastructure plus intelligente et plus spécialisée.

Voici trois idées clés :

Tenir compte de la variabilité du matériel. Toutes les puces ne sont pas identiques. Même au sein d’une même génération, les puces varient en termes de vitesse de fonctionnement et de tolérance à la chaleur, ce qui entraîne une hétérogénéité des performances et de l’efficacité énergétique. Les systèmes informatiques des centres de données doivent reconnaître les différences entre les puces en termes de performances, de tolérance à la chaleur et de consommation d’énergie, et s’adapter en conséquence.

S’adapter aux conditions changeantes. Les charges de travail de l’IA varient dans le temps. Par exemple, les points chauds thermiques sur les puces peuvent déclencher leur ralentissement, la fluctuation de l’alimentation du réseau peut limiter la puissance maximale que les centres peuvent tirer, et les rafales de données entre les puces peuvent créer une congestion dans le réseau qui les connecte. Les systèmes doivent être conçus pour réagir en temps réel à des facteurs tels que la température, la disponibilité de l’énergie et le trafic de données. https://www.youtube.com/embed/vZkA0z9JRgw?wmode=transparent&start=0 Comment fonctionne le refroidissement d’un centre de données.

Casser les silos. Les ingénieurs qui conçoivent les puces, les logiciels et les centres de données devraient travailler ensemble. Lorsque ces équipes collaborent, elles peuvent trouver de nouveaux moyens d’économiser l’énergie et d’améliorer les performances. À cette fin, mes collègues, les étudiants et moi-même, au AI Makerspace de Georgia Tech, un centre de données d’IA à haute performance, explorons ces défis de manière pratique. Nous travaillons dans plusieurs disciplines, du matériel aux logiciels en passant par les systèmes énergétiques, pour construire et tester des systèmes d’IA efficaces, évolutifs et durables.

L’intelligence au service de la croissance

L’IA a le potentiel de transformer la science, la médecine, l’éducation et bien d’autres domaines, mais elle risque de se heurter à des limites en termes de performances, d’énergie et de coûts. L’avenir de l’IA dépend non seulement de meilleurs modèles, mais aussi d’une meilleure infrastructure.

Pour que l’IA continue à se développer d’une manière bénéfique pour la société, je pense qu’il est important de passer d’une mise à l’échelle par la force à une mise à l’échelle par l’intelligence.

Divya Mahajan, Assistant Professor of Computer Engineering, Georgia Institute of Technology

This article is republished from The Conversation under a Creative Commons license. Read the original article.