Des chercheurs américains ont mis au point un dispositif matériel de pointe capable de réduire la consommation d’énergie des applications d’intelligence artificielle (IA) d’un facteur d’au moins 1 000.

Face à la demande croissante des applications d’IA, les chercheurs cherchent des moyens de créer des processus plus économes en énergie, tout en maintenant une performance élevée et des coûts réduits. Les processus d’intelligence artificielle transfèrent couramment des données entre la logique (où les informations sont traitées) et la mémoire (où les données sont stockées), ce qui consomme une grande quantité d’énergie.

Une équipe de chercheurs du Collège des sciences et de l’ingénierie de l’Université du Minnesota a démontré un nouveau modèle où les données ne quittent jamais la mémoire, appelé mémoire à accès aléatoire computationnelle (CRAM).

« Ce travail est la première démonstration expérimentale de la CRAM, où les données peuvent être traitées entièrement au sein de la matrice de mémoire sans avoir besoin de quitter la grille où un ordinateur stocke les informations », a expliqué Yang Lv, chercheur postdoctoral au Département de génie électrique et informatique de l’Université du Minnesota et auteur principal de l’article.

Prévisions énergétiques alarmantes et solutions innovantes

L’Agence internationale de l’énergie (AIE) a publié en mars 2024 une prévision mondiale de la consommation d’énergie, prévoyant que la consommation d’énergie pour l’IA pourrait doubler, passant de 460 térawattheures (TWh) en 2022 à 1 000 TWh en 2026. Cela équivaut à peu près à la consommation électrique de tout le Japon.

Selon les auteurs du nouvel article, un accélérateur d’inférence de machine learning basé sur la CRAM est estimé à améliorer l’efficacité énergétique d’un facteur de 1 000. Un autre exemple a montré une économie d’énergie de 2 500 et 1 700 fois par rapport aux méthodes traditionnelles.

« Notre concept initial d’utiliser les cellules de mémoire directement pour le calcul il y a 20 ans était considéré comme fou », a déclaré Jian-Ping Wang, auteur principal de l’article et professeur distingué McKnight et titulaire de la chaire Robert F. Hartmann au Département de génie électrique et informatique de l’Université du Minnesota.

« Avec un groupe évolutif d’étudiants depuis 2003 et une véritable équipe interdisciplinaire de professeurs à l’Université du Minnesota – de la physique, la science des matériaux et l’ingénierie, l’informatique et l’ingénierie, à la modélisation et au benchmarking, et à la création de matériel – nous avons pu obtenir des résultats positifs et avons maintenant démontré que ce type de technologie est réalisable et prêt à être incorporé dans la technologie », a ajouté Jian-Ping Wang.

Applications et perspectives futures

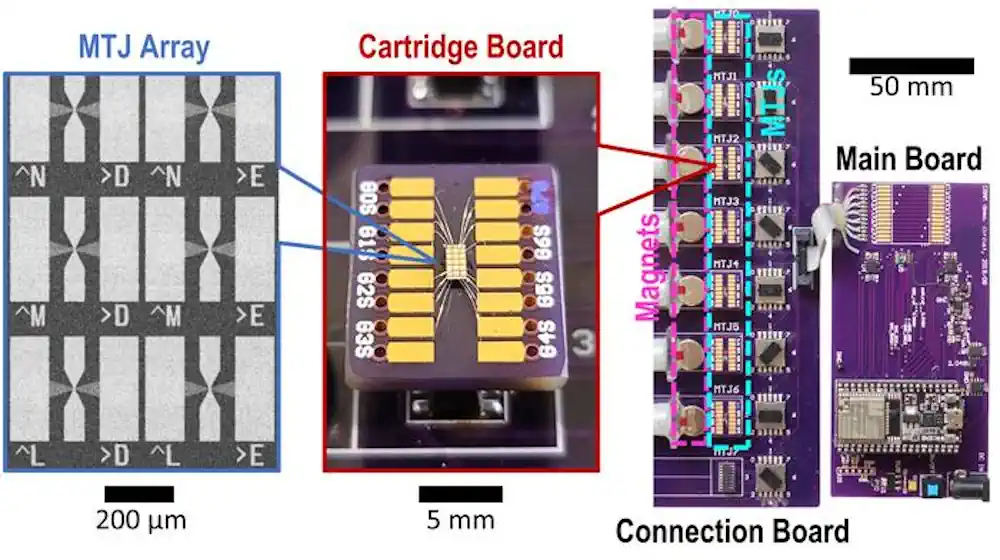

Cette recherche s’inscrit dans un effort cohérent et de longue date, s’appuyant sur les recherches pionnières et brevetées de Wang et de ses collaborateurs sur les dispositifs à jonction tunnel magnétique (MTJ), qui sont des dispositifs nanostructurés utilisés pour améliorer les disques durs, les capteurs et d’autres systèmes microélectroniques, y compris la mémoire à accès aléatoire magnétique (MRAM), utilisée dans les systèmes embarqués tels que les microcontrôleurs et les montres intelligentes.

L’architecture CRAM permet un véritable calcul dans et par la mémoire et élimine le goulet d’étranglement entre le calcul et la mémoire dans l’architecture traditionnelle de von Neumann, un concept théorique pour un ordinateur à programme stocké qui sert de base à presque tous les ordinateurs modernes.

« En tant que substrat de calcul en mémoire extrêmement économe en énergie, la CRAM est très flexible en ce que le calcul peut être effectué à n’importe quel endroit de la matrice de mémoire. En conséquence, nous pouvons reconfigurer la CRAM pour mieux correspondre aux besoins de performance d’un ensemble diversifié d’algorithmes d’IA », a précisé pour sa part Ulya Karpuzcu, experte en architecture informatique, co-auteur de l’article et professeure associée au Département de génie électrique et informatique de l’Université du Minnesota. « Elle est plus économe en énergie que les blocs de construction traditionnels pour les systèmes d’IA d’aujourd’hui. »

Actuellement, l’équipe prévoit de travailler avec des leaders de l’industrie des semi-conducteurs, y compris ceux du Minnesota, pour fournir des démonstrations à grande échelle et produire le matériel nécessaire pour faire progresser les fonctionnalités de l’IA.

La recherche, publiée dans npj Unconventional Computing, une revue scientifique évaluée par des pairs et éditée par Nature, présente une avancée significative dans le domaine de l’IA. Les chercheurs ont déposé plusieurs brevets pour la technologie utilisée dans ce dispositif.

Article : « Experimental demonstration of magnetic tunnel junction-based computational random-access memory » – DOI: 10.1038/s44335-024-00003-3