Les systèmes de conception assistée par ordinateur (CAO) sont des outils éprouvés utilisés pour concevoir de nombreux objets physiques que nous utilisons chaque jour. Mais les logiciels de CAO nécessitent une expertise approfondie pour être maîtrisés, et de nombreux outils intègrent un tel niveau de détail qu’ils ne se prêtent pas au brainstorming ou au prototypage rapide.

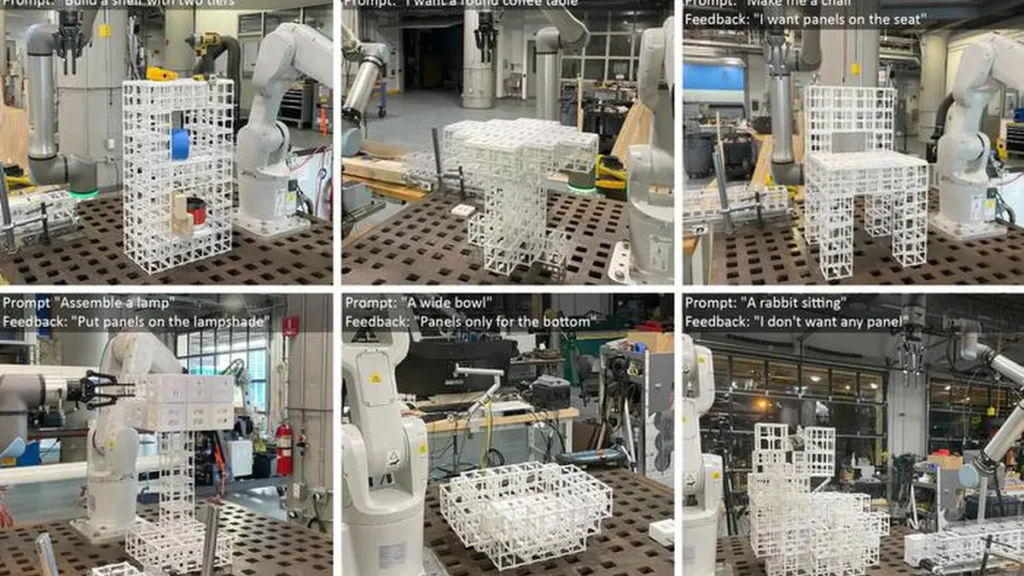

Dans un effort pour rendre la conception plus rapide et plus accessible aux non-experts, des chercheurs du MIT et d’ailleurs ont développé un système d’assemblage robotique piloté par IA qui permet aux gens de construire des objets physiques en les décrivant simplement avec des mots.

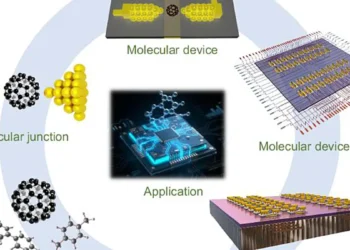

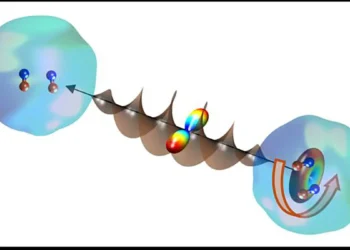

Leur système utilise un modèle d’IA générative pour construire une représentation 3D de la géométrie d’un objet à partir de l’invite de l’utilisateur. Ensuite, un second modèle d’IA générative raisonne sur l’objet souhaité et détermine où les différents composants doivent être placés, en fonction de la fonction et de la géométrie de l’objet.

Le système peut automatiquement construire l’objet à partir d’un ensemble de pièces préfabriquées en utilisant un assemblage robotique. Il peut également itérer sur la conception en fonction des retours de l’utilisateur.

Les chercheurs ont utilisé ce système de bout en bout pour fabriquer des meubles, notamment des chaises et des étagères, à partir de deux types de composants prêts à l’emploi. Les composants peuvent être démontés et remontés à volonté, réduisant ainsi la quantité de déchets générés par le processus de fabrication.

Ils ont évalué ces conceptions via une étude utilisateur et ont constaté que plus de 90 pour cent des participants préféraient les objets fabriqués par leur système piloté par IA, par rapport à différentes approches.

Bien que ce travail soit une démonstration initiale, le cadre pourrait être particulièrement utile pour le prototypage rapide d’objets complexes comme les composants aérospatiaux et les objets architecturaux. À plus long terme, il pourrait être utilisé dans les foyers pour fabriquer des meubles ou d’autres objets localement, sans avoir besoin de faire expédier des produits encombrants depuis une installation centrale.

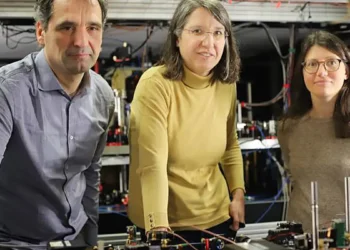

« Tôt ou tard, nous voulons pouvoir communiquer et parler à un robot et à un système d’IA de la même manière que nous nous parlons pour fabriquer des choses ensemble. Notre système est un premier pas vers cet avenir », explique l’auteur principal Alex Kyaw, étudiant diplômé des départements de génie électrique et d’informatique (EECS) et d’architecture du MIT.

Kyaw est rejoint sur l’article par Richa Gupta, une étudiante diplômée en architecture du MIT ; Faez Ahmed, professeur associé de génie mécanique ; Lawrence Sass, professeur et directeur du groupe de calcul du département d’architecture ; l’auteur principal Randall Davis, professeur à l’EECS et membre du Laboratoire d’informatique et d’intelligence artificielle (CSAIL) ; ainsi que d’autres chez Google Deepmind et Autodesk Research. L’article a récemment été présenté à la Conférence sur les systèmes de traitement de l’information neuronale.

Génération d’une conception à plusieurs composants

Bien que les modèles d’IA générative soient bons pour générer des représentations 3D, appelées maillages, à partir d’invites textuelles, la plupart ne produisent pas de représentations uniformes de la géométrie d’un objet ayant les détails au niveau des composants nécessaires à l’assemblage robotique.

Séparer ces maillages en composants est un défi pour un modèle car l’attribution des composants dépend de la géométrie et de la fonctionnalité de l’objet et de ses parties.

Les chercheurs ont relevé ces défis en utilisant un modèle vision-langage (VLM), un puissant modèle d’IA générative pré-entraîné pour comprendre les images et le texte. Ils confient au VLM la tâche de déterminer comment deux types de pièces préfabriquées, les composants structurels et les composants de panneaux, doivent s’assembler pour former un objet.

« Il existe de nombreuses façons de placer des panneaux sur un objet physique, mais le robot doit voir la géométrie et raisonner sur cette géométrie pour prendre une décision à son sujet. En servant à la fois d’yeux et de cerveau au robot, le VLM lui permet de le faire », déclare Kyaw.

Un utilisateur sollicite le système avec du texte, peut-être en tapant « fabrique-moi une chaise », et lui donne une image générée par IA d’une chaise pour commencer.

Ensuite, le VLM raisonne sur la chaise et détermine où les composants de panneaux doivent être placés sur les composants structurels, en se basant sur la fonctionnalité de nombreux objets exemples qu’il a vus auparavant. Par exemple, le modèle peut déterminer que l’assise et le dossier doivent avoir des panneaux pour offrir des surfaces à une personne assise et adossée sur la chaise.

Il sort ces informations sous forme de texte, comme « assise » ou « dossier ». Chaque surface de la chaise est ensuite étiquetée avec des nombres, et l’information est renvoyée au VLM.

Puis le VLM choisit les étiquettes qui correspondent aux parties géométriques de la chaise qui doivent recevoir des panneaux sur le maillage 3D pour finaliser la conception.

Co-conception humain-IA

L’utilisateur reste dans la boucle tout au long de ce processus et peut affiner la conception en donnant au modèle une nouvelle instruction, comme « utilise des panneaux uniquement sur le dossier, pas sur l’assise ».

« L’espace de conception est très vaste, donc nous le réduisons grâce aux retours des utilisateurs. Nous pensons que c’est la meilleure façon de procéder car les gens ont des préférences différentes, et construire un modèle idéalisé pour tout le monde serait impossible », affirme Kyaw.

« Le processus avec l’humain dans la boucle permet aux utilisateurs d’orienter les conceptions générées par l’IA et d’avoir un sentiment d’appropriation du résultat final », ajoute Gupta.

Une fois le maillage 3D finalisé, un système d’assemblage robotique construit l’objet en utilisant des pièces préfabriquées. Ces pièces réutilisables peuvent être démontées et remontées dans différentes configurations.

Les chercheurs ont comparé les résultats de leur méthode avec un algorithme qui place des panneaux sur toutes les surfaces horizontales orientées vers le haut, et un algorithme qui place des panneaux au hasard. Dans une étude utilisateur, plus de 90 pour cent des individus ont préféré les conceptions réalisées par leur système.

Ils ont également demandé au VLM d’expliquer pourquoi il avait choisi de placer des panneaux dans ces zones.

« Nous avons appris que le modèle vision-langage est capable de comprendre dans une certaine mesure les aspects fonctionnels d’une chaise, comme s’adosser et s’asseoir, pour comprendre pourquoi il place des panneaux sur l’assise et le dossier. Il ne sort pas ces attributions au hasard », explique Kyaw.

À l’avenir, les chercheurs souhaitent améliorer leur système pour gérer des invites utilisateur plus complexes et nuancées, comme une table en verre et métal. De plus, ils souhaitent intégrer des composants préfabriqués supplémentaires, tels que des engrenages, des charnières ou d’autres pièces mobiles, afin que les objets puissent avoir plus de fonctionnalités.

« Notre espoir est de réduire considérablement la barrière d’accès aux outils de conception. Nous avons montré que nous pouvons utiliser l’IA générative et la robotique pour transformer des idées en objets physiques de manière rapide, accessible et durable », conclut Davis.

Article : « Text to Robotic Assembly of Multi Component Objects using 3D Generative AI and Vision Language Models » – DOI : Lien vers l’étude