Les chercheurs de l’Université Macquarie ont remis en question une théorie vieille de 75 ans sur la façon dont les humains déterminent la provenance des sons. Cette découverte permettrait de créer par exemple une nouvelle génération de dispositifs auditifs plus adaptables et plus efficaces, allant des appareils auditifs aux smartphones.

Remise en question d’un modèle d’ingénierie des années 1940

Dans les années 1940, un modèle d’ingénierie a été développé pour expliquer comment les humains peuvent localiser une source sonore en se basant sur des différences de seulement quelques dizaines de millionièmes de seconde dans le temps d’arrivée du son à chaque oreille. Ce modèle reposait sur la théorie selon laquelle nous devons disposer d’un ensemble de détecteurs spécialisés dont la seule fonction était de déterminer la provenance d’un son, la localisation dans l’espace étant représentée par un neurone dédié.

Les hypothèses de ce modèle ont guidé et influencé la recherche – et la conception des technologies audio – depuis lors. Un nouvel article de recherche publié dans Current Biology par les chercheurs en audition de l’Université Macquarie a finalement révélé que l’idée d’un réseau neuronal dédié à l’audition spatiale ne tient pas.

Utilisation d’un réseau neuronal plus simple chez les humains et les animaux

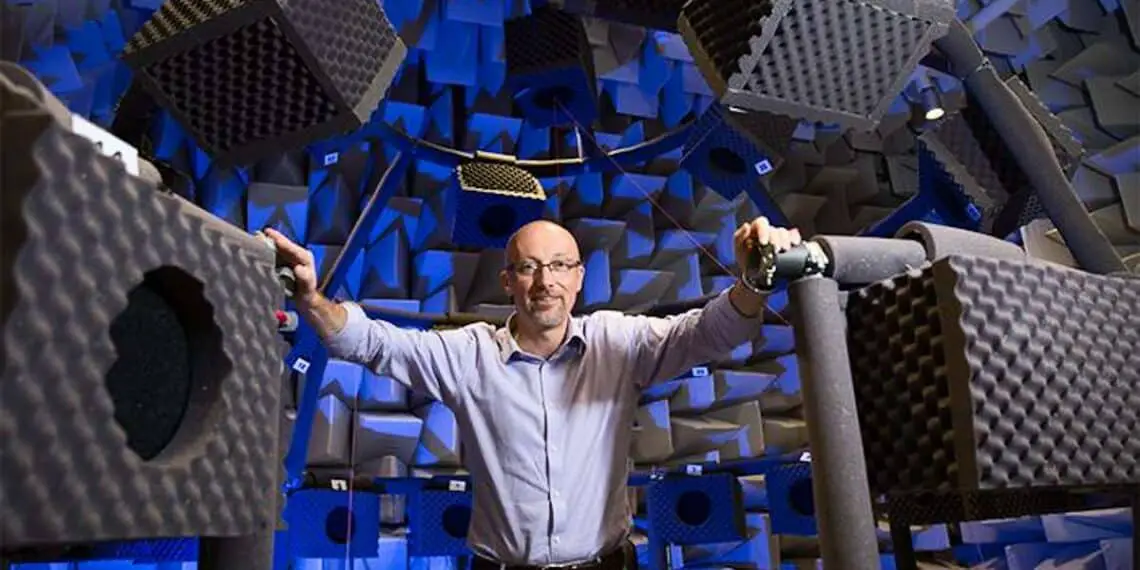

L’auteur principal, David McAlpine, professeur distingué d’audition à l’Université Macquarie, a passé les 25 dernières années à prouver qu’un animal après l’autre utilisait en réalité un réseau neuronal beaucoup plus clairsemé, avec des neurones des deux côtés du cerveau remplissant cette fonction en plus d’autres. Démontrer cela en action chez l’homme était plus difficile.

Grâce à la combinaison d’un test auditif spécialisé, d’une imagerie cérébrale avancée et de comparaisons avec les cerveaux d’autres mammifères, notamment les singes rhésus, lui et son équipe ont montré pour la première fois que les humains utilisent également ces réseaux plus simples. «Nous aimons penser que nos cerveaux doivent être bien plus avancés que ceux des autres animaux à tous points de vue, mais ce n’est que de l’orgueil», déclare le professeur McAlpine.

Implications pour la conception des dispositifs auditifs et des assistants électroniques

L’équipe de recherche a également prouvé que le même réseau neuronal sépare la parole des sons de fond – une découverte importante pour la conception des dispositifs auditifs et des assistants électroniques de nos téléphones. Tous les types d’audition artificielle sont confrontés au défi d’entendre dans le bruit, connu sous le nom de «problème de la soirée cocktail». Cela rend difficile pour les personnes équipées de dispositifs auditifs de distinguer une voix dans un espace bondé, et pour nos appareils intelligents de nous comprendre lorsque nous leur parlons.

Le professeur McAlpine affirme que les dernières découvertes de son équipe suggèrent qu’au lieu de se concentrer sur les grands modèles de langage (LLM) actuellement utilisés, nous devrions adopter une approche beaucoup plus simple. «Les LLM sont brillants pour prédire le mot suivant dans une phrase, mais ils essaient d’en faire trop», dit-il.

Vers une nouvelle approche de l’audition artificielle

Selon le professeur McAlpine, pour localiser efficacement la source d’un son, nous n’avons pas besoin d’un «cerveau profond» du langage. D’autres animaux peuvent le faire, et ils n’ont pas de langage. Lorsque nous écoutons, nos cerveaux ne suivent pas le son en permanence, ce que les grands processeurs de langage essaient de faire. Au lieu de cela, nous, et d’autres animaux, utilisons notre « cerveau superficiel » pour sélectionner de très petits extraits de son, y compris la parole, et les utilisons pour étiqueter l’emplacement et peut-être même l’identité de la source.

Cette découverte montre qu’une machine n’a pas besoin d’être entraînée au langage comme un cerveau humain pour pouvoir écouter efficacement. «Nous n’avons besoin que de ce cerveau de gerbille», conclut le professeur McAlpine. La prochaine étape pour l’équipe est d’identifier la quantité minimale d’informations pouvant être transmise dans un son tout en obtenant le maximum d’écoute spatiale.

Légende illustration : David McAlpine, professeur émérite de l’audition, dans la chambre anéchoïque de l’Université Macquarie. Crédit : Macquarie University

“The neural representation of an auditory spatial cue in the primate cortex”, par Dr Jaime Undurraga, Dr Robert Luke, Dr Lindsey Van Yper, Dr Jessica Monaghan, and Distinguished Professor David McAlpine, is published dans l’édition de mai 2024 de Current Biology: 10.1016/j.cub.2024.04.034