Le matériel informatique dédié à l’IA doit devenir plus semblable au cerveau pour répondre aux demandes énergétiques croissantes des applications du monde réel, selon des chercheurs.

Dans une étude publiée dans Frontiers in Science, des scientifiques de l’Université Purdue et du Georgia Institute of Technology ont décrit des approches pratiques pour surmonter les limites du matériel informatique moderne.

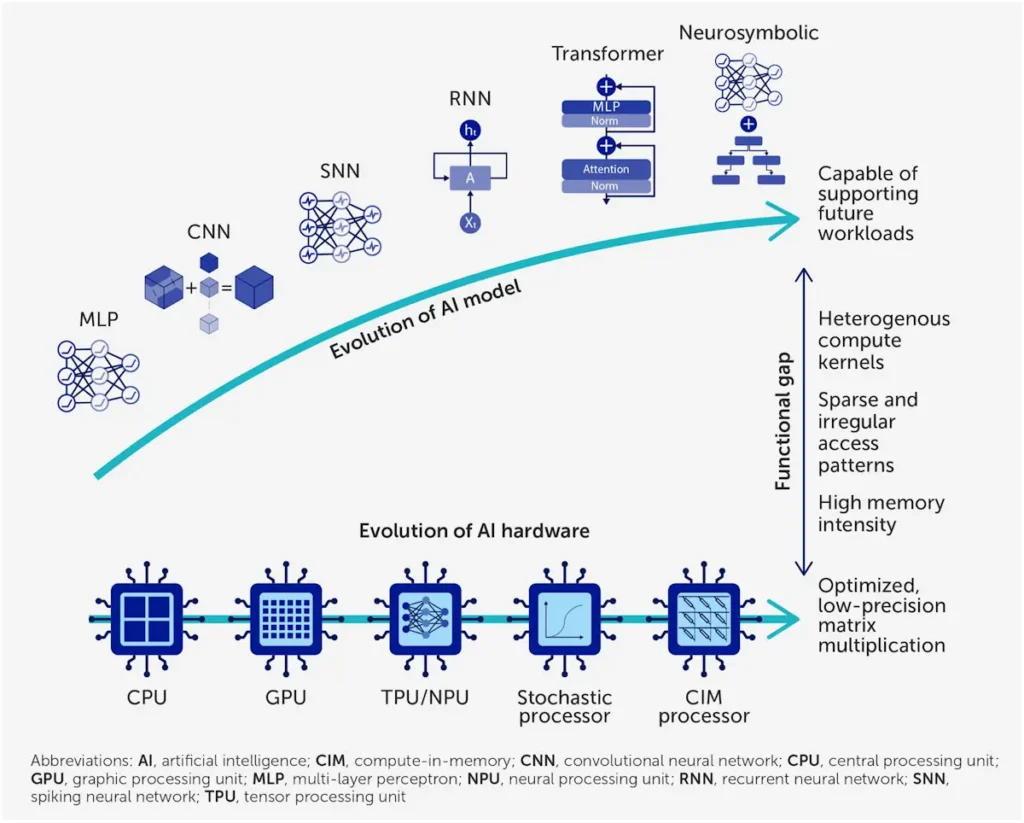

Les ordinateurs conventionnels sont basés sur l’architecture de von Neumann, avec des unités de traitement et de mémoire séparées. Chaque fois que des données sont nécessaires, l’information doit faire des allers-retours entre les deux composants. Ce transfert, connu sous le nom de mur de la mémoire, est responsable de la plupart des délais et de la consommation d’énergie dans le traitement de l’IA.

Les chercheurs soutiennent que l’intégration de la capacité de traitement au sein ou à côté de l’unité de mémoire aiderait à surmonter ce goulot d’étranglement. Y parvenir pourrait permettre de nouveaux types d’algorithmes qui rendent les applications d’IA réalisables sans dépendre de l’informatique en nuage, gourmande en données et en énergie.

« Les modèles de traitement du langage ont vu leur taille multipliée par 5 000 au cours des quatre dernières années. Cette expansion alarmante rend cruciale une efficacité maximale de l’IA. Cela signifie repenser fondamentalement la conception des ordinateurs », a déclaré Kaushik Roy, professeur de génie électrique et informatique à l’Université Purdue et auteur principal de l’étude.

Inspiré par le cerveau

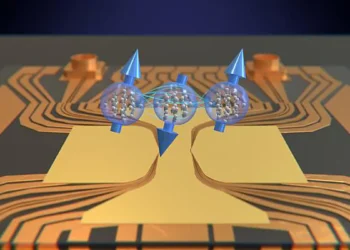

Un moyen d’éviter le problème du mur de la mémoire et de rendre le calcul de l’IA plus efficace est de s’inspirer de notre cerveau.

Lorsqu’un neurone reçoit des signaux d’activation d’autres neurones, il accumule une charge électrique, appelée potentiel de membrane. Si ce potentiel atteint un certain seuil, le neurone envoie son propre signal. Ce faisant, un neurone stocke et traite l’information au même endroit et ne communique que lorsque quelque chose change.

Cela a inspiré de nouveaux algorithmes d’IA connus sous le nom de réseaux de neurones à impulsions (SNN), qui peuvent répondre efficacement à des événements irréguliers et occasionnels. Cela contraste avec les réseaux d’IA traditionnels, qui excellent dans les tâches gourmandes en données comme la reconnaissance faciale, la classification d’images, l’analyse d’images et la reconstruction 3D.

« Les capacités du cerveau humain ont longtemps été une source d’inspiration pour les systèmes d’IA. Les algorithmes d’apprentissage automatique sont issus de la capacité du cerveau à apprendre et à généraliser à partir des données d’entrée. Maintenant, nous voulons passer au niveau supérieur et recréer les mécanismes de traitement efficaces du cerveau », a expliqué Adarsh Kosta, co-auteur et chercheur à l’Université Purdue.

L’IA en temps réel

Cette approche neuro-inspirée pourrait permettre aux applications d’IA de s’étendre au-delà des grands centres de données.

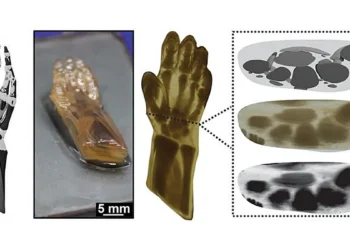

Par exemple, un drone autonome dans un scénario de recherche et de sauvetage doit détecter son environnement, identifier et suivre des objets, prendre des décisions et planifier ses actions en temps réel. S’appuyer sur le calcul en nuage peut entraîner un décalage trop important, ces processus doivent donc être effectués à bord aussi efficacement que possible.

Dans de tels scénarios, il est essentiel que les systèmes informatiques soient légers et à faible consommation. Un gain d’efficacité consiste pour les drones à utiliser des caméras événementielles. Contrairement aux caméras vidéo qui enregistrent un flux régulier d’images, ces capteurs n’envoient des données que lorsqu’il y a un changement suffisant des pixels.

Les caméras événementielles utilisent moins de données et d’énergie; cependant, leurs sorties intermittentes et dépendantes du temps ne sont pas bien adaptées aux unités de traitement traditionnelles. Les algorithmes SNN, tout comme le cerveau, sont très efficaces pour répondre à des séquences d’événements, tirant le meilleur parti de ces signaux épars.

Cette approche pourrait permettre au drone d’être plus performant ou d’avoir une plus grande autonomie. Une plus grande efficacité bénéficierait également aux applications d’IA dans un large éventail de domaines, comme les transports ou les dispositifs médicaux.

« L’IA est l’une des technologies les plus transformatrices du 21e siècle. Cependant, pour la sortir des centres de données et l’intégrer dans le monde réel, nous devons réduire considérablement sa consommation d’énergie. Avec moins de transfert de données et un traitement plus efficace, l’IA peut s’intégrer dans de petits appareils abordables dont les batteries durent plus longtemps », a révélé Tanvi Sharma, co-auteur et chercheuse à l’Université Purdue.

Solutions matérielles

L’application réussie des SNN nécessitera un matériel spécialisé qui surmonte le mur de la mémoire.

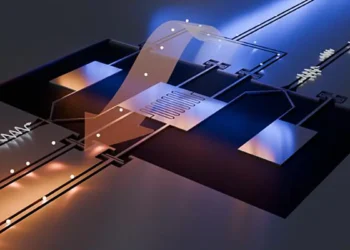

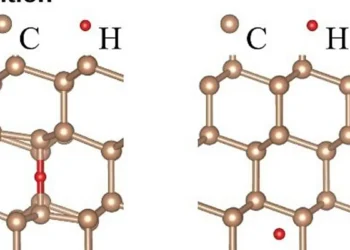

Les systèmes de calcul en mémoire (CIM) effectuent les calculs là où les données sont stockées, réduisant ainsi les coûteux mouvements de données. C’est idéal pour les algorithmes SNN, qui doivent se référer à plusieurs reprises à la mémoire pour mettre à jour et vérifier les potentiels de membrane au fil du temps.

Il existe deux principales façons d’y parvenir. Les méthodes analogiques utilisent des courants électriques circulant à travers les cellules de mémoire pour effectuer des calculs. Les méthodes numériques utilisent une logique numérique standard (0 et 1) à l’intérieur ou à côté du réseau de mémoire. Le numérique est plus précis mais consomme plus d’énergie que l’analogique.

Il existe plusieurs technologies potentielles qui pourraient fournir des systèmes CIM, mais aucune ne se présente comme un gagnant clair dans tous les cas. Au lieu de cela, les auteurs soulignent la valeur de combiner les approches et de concevoir les algorithmes, les circuits et la mémoire ensemble, afin que chaque application utilise les blocs de construction les plus appropriés.

« La co-conception du matériel et des algorithmes est le seul moyen de franchir le mur de la mémoire et de fournir une IA rapide, légère et à faible consommation », a affirmé Roy. « Cette approche de conception collaborative pourrait également créer des plateformes bien plus polyvalentes en basculant entre les réseaux d’IA traditionnels et les réseaux neuro-inspirés selon l’application. »

Article : Breaking the memory wall: next-generation artificial intelligence hardware – Journal : Frontiers in Science – DOI : Lien vers l’étude